diff --git a/README.md b/README.md

index 3f8b67a436..5b21de3d3b 100644

--- a/README.md

+++ b/README.md

@@ -148,3 +148,8 @@ Thanks to [JetBrains](https://www.jetbrains.com/?from=dlink) for providing a fre

Please refer to the [LICENSE](https://github.com/DataLinkDC/dinky/blob/dev/LICENSE) document.

+# Contributors

+

+

+  +

diff --git a/README_zh_CN.md b/README_zh_CN.md

index 2ec688593c..a497d493d3 100644

--- a/README_zh_CN.md

+++ b/README_zh_CN.md

@@ -148,4 +148,10 @@ Dinky 是一个 `开箱即用` 、`易扩展` ,以 `Apache Flink` 为基础,

## 版权

-请参考 [LICENSE](https://github.com/DataLinkDC/dinky/blob/dev/LICENSE) 文件。

\ No newline at end of file

+请参考 [LICENSE](https://github.com/DataLinkDC/dinky/blob/dev/LICENSE) 文件。

+

+# 贡献者

+

+

+

+

diff --git a/README_zh_CN.md b/README_zh_CN.md

index 2ec688593c..a497d493d3 100644

--- a/README_zh_CN.md

+++ b/README_zh_CN.md

@@ -148,4 +148,10 @@ Dinky 是一个 `开箱即用` 、`易扩展` ,以 `Apache Flink` 为基础,

## 版权

-请参考 [LICENSE](https://github.com/DataLinkDC/dinky/blob/dev/LICENSE) 文件。

\ No newline at end of file

+请参考 [LICENSE](https://github.com/DataLinkDC/dinky/blob/dev/LICENSE) 文件。

+

+# 贡献者

+

+

+  +

diff --git a/dinky-admin/src/main/java/org/dinky/service/impl/TaskServiceImpl.java b/dinky-admin/src/main/java/org/dinky/service/impl/TaskServiceImpl.java

index 43d4d5d36a..550be8e02b 100644

--- a/dinky-admin/src/main/java/org/dinky/service/impl/TaskServiceImpl.java

+++ b/dinky-admin/src/main/java/org/dinky/service/impl/TaskServiceImpl.java

@@ -511,14 +511,21 @@ public boolean changeTaskLifeRecyle(Integer taskId, JobLifeCycle lifeCycle) thro

boolean saved = saveOrUpdate(task.buildTask());

if (saved && Asserts.isNotNull(task.getJobInstanceId())) {

JobInstance jobInstance = jobInstanceService.getById(task.getJobInstanceId());

- jobInstance.setStep(lifeCycle.getValue());

- jobInstanceService.updateById(jobInstance);

- log.info("jobInstance [{}] step change to {}", jobInstance.getJid(), lifeCycle.getValue());

+ if (Asserts.isNotNull(jobInstance)) {

+ jobInstance.setStep(lifeCycle.getValue());

+ boolean updatedJobInstance = jobInstanceService.updateById(jobInstance);

+ if (updatedJobInstance) jobInstanceService.refreshJobInfoDetail(jobInstance.getId(), true);

+ log.warn(

+ "JobInstance [{}] step change to [{}] ,Trigger Force Refresh",

+ jobInstance.getName(),

+ lifeCycle.getValue());

+ }

}

return saved;

}

@Override

+ @Transactional(rollbackFor = Exception.class)

public boolean saveOrUpdateTask(Task task) {

Task byId = getById(task.getId());

if (byId != null && JobLifeCycle.PUBLISH.equalsValue(byId.getStep())) {

diff --git a/dinky-web/src/pages/DataStudio/LeftContainer/Project/function.tsx b/dinky-web/src/pages/DataStudio/LeftContainer/Project/function.tsx

index e3d76a29a8..36b02ad10f 100644

--- a/dinky-web/src/pages/DataStudio/LeftContainer/Project/function.tsx

+++ b/dinky-web/src/pages/DataStudio/LeftContainer/Project/function.tsx

@@ -80,19 +80,19 @@ export const buildStepValue = (step: number) => {

return {

title: l('global.table.lifecycle.dev'),

status: 'processing',

- color: '#1890ff'

+ color: 'cyan'

};

case 2:

return {

title: l('global.table.lifecycle.online'),

status: 'success',

- color: '#52c41a'

+ color: 'purple'

};

default:

return {

title: l('global.table.lifecycle.dev'),

status: 'default',

- color: '#1890ff'

+ color: 'cyan'

};

}

};

@@ -144,7 +144,8 @@ export const buildProjectTree = (

<>

);

diff --git a/dinky-web/src/pages/DevOps/JobDetail/JobOverview/components/FlinkTable.tsx b/dinky-web/src/pages/DevOps/JobDetail/JobOverview/components/FlinkTable.tsx

index dd539aaa97..bc2a4595fa 100644

--- a/dinky-web/src/pages/DevOps/JobDetail/JobOverview/components/FlinkTable.tsx

+++ b/dinky-web/src/pages/DevOps/JobDetail/JobOverview/components/FlinkTable.tsx

@@ -19,7 +19,12 @@

import StatusTag from '@/components/JobTags/StatusTag';

import { JobProps } from '@/pages/DevOps/JobDetail/data';

-import { parseByteStr, parseMilliSecondStr, parseNumStr } from '@/utils/function';

+import {

+ formatTimestampToYYYYMMDDHHMMSS,

+ parseByteStr,

+ parseMilliSecondStr,

+ parseNumStr

+} from '@/utils/function';

import { l } from '@/utils/intl';

import { ProCard, ProColumns, ProTable } from '@ant-design/pro-components';

import { Typography } from 'antd';

@@ -32,8 +37,10 @@ export type VerticesTableListItem = {

metrics: any;

parallelism: number;

startTime?: number;

+ 'start-time'?: number;

duration?: number;

endTime?: number;

+ 'end-time'?: number;

tasks: any;

};

@@ -101,15 +108,20 @@ const FlinkTable = (props: JobProps): JSX.Element => {

},

{

title: l('global.table.startTime'),

- dataIndex: 'startTime',

- valueType: 'dateTime'

+ render: (dom, entity) => {

+ return entity.startTime === -1 || entity['start-time'] === -1

+ ? '-'

+ : formatTimestampToYYYYMMDDHHMMSS(entity['start-time'] as number) ||

+ formatTimestampToYYYYMMDDHHMMSS(entity.startTime as number);

+ }

},

{

title: l('global.table.endTime'),

- dataIndex: 'endTime',

- valueType: 'dateTime',

render: (dom, entity) => {

- return entity.endTime === -1 ? '-' : entity.endTime;

+ return entity.endTime === -1 || entity['end-time'] === -1

+ ? '-'

+ : formatTimestampToYYYYMMDDHHMMSS(entity['end-time'] as number) ||

+ formatTimestampToYYYYMMDDHHMMSS(entity.endTime as number);

}

},

{

diff --git a/dinky-web/src/pages/DevOps/JobDetail/JobOverview/components/JobDesc.tsx b/dinky-web/src/pages/DevOps/JobDetail/JobOverview/components/JobDesc.tsx

index bb645801e7..99e50d90f6 100644

--- a/dinky-web/src/pages/DevOps/JobDetail/JobOverview/components/JobDesc.tsx

+++ b/dinky-web/src/pages/DevOps/JobDetail/JobOverview/components/JobDesc.tsx

@@ -88,7 +88,7 @@ const JobDesc = (props: JobProps) => {

- {jobDetail?.jobDataDto?.config?.executionConfig?.restartStrategy}

+ {jobDetail?.jobDataDto?.config['execution-config']['restart-strategy']}

@@ -109,13 +109,11 @@ const JobDesc = (props: JobProps) => {

- {jobDetail?.history?.configJson?.useSqlFragment

- ? l('button.enable')

- : l('button.disable')}

+ {jobDetail?.history?.configJson?.fragment ? l('button.enable') : l('button.disable')}

- {jobDetail?.history?.configJson?.useBatchModel

+ {jobDetail?.history?.configJson?.batchModel

? l('global.table.execmode.batch')

: l('global.table.execmode.streaming')}

@@ -125,7 +123,7 @@ const JobDesc = (props: JobProps) => {

- {jobDetail?.jobDataDto?.config?.executionConfig?.jobParallelism}

+ {jobDetail?.jobDataDto?.config['execution-config']['job-parallelism']}

@@ -137,7 +135,7 @@ const JobDesc = (props: JobProps) => {

- {jobDetail?.history?.configJson.savePointPath}

+ {jobDetail?.history?.configJson?.configJson['state.savepoints.dir'] ?? '-'}

diff --git a/dinky-web/src/pages/DevOps/JobDetail/index.tsx b/dinky-web/src/pages/DevOps/JobDetail/index.tsx

index 337d7ab1b4..e80134a2af 100644

--- a/dinky-web/src/pages/DevOps/JobDetail/index.tsx

+++ b/dinky-web/src/pages/DevOps/JobDetail/index.tsx

@@ -65,7 +65,7 @@ const JobDetail = (props: any) => {

pollingInterval: 3000

});

- const jobInfoDetail: Jobs.JobInfoDetail = data;

+ const jobInfoDetail = data as Jobs.JobInfoDetail;

const [tabKey, setTabKey] = useState(OperatorEnum.JOB_BASE_INFO);

diff --git a/dinky-web/src/types/DevOps/data.d.ts b/dinky-web/src/types/DevOps/data.d.ts

index 13d615472b..f25fff4868 100644

--- a/dinky-web/src/types/DevOps/data.d.ts

+++ b/dinky-web/src/types/DevOps/data.d.ts

@@ -18,7 +18,7 @@

*/

import { BaseBeanColumns } from '@/types/Public/data';

-import { Alert } from '@/types/RegCenter/data.d';

+import { Alert, Cluster } from '@/types/RegCenter/data.d';

/**

* about flink job

@@ -48,6 +48,62 @@ declare namespace Jobs {

useBatchModel: string;

};

+ export type ExecutorSetting = {

+ type: string;

+ host: string;

+ port: number;

+ useBatchModel: boolean;

+ checkpoint: string;

+ parallelism: number;

+ useSqlFragment: boolean;

+ useStatementSet: boolean;

+ savePointPath: string;

+ jobName: string;

+ config: Map;

+ variables: Map;

+ jarFiles: [];

+ jobManagerAddress: string;

+ plan: boolean;

+ remote: boolean;

+ validParallelism: boolean;

+ validJobName: boolean;

+ validHost: boolean;

+ validPort: boolean;

+ validConfig: boolean;

+ validVariables: boolean;

+ validJarFiles: boolean;

+ };

+

+ export type JobConfigJsonInfo = {

+ type: string;

+ checkpoint: string;

+ savePointStrategy: string;

+ savePointPath: string;

+ parallelism: number;

+ clusterId: number;

+ clusterConfigurationId: number;

+ step: number;

+ configJson: {

+ 'state.savepoints.dir': string;

+ };

+ useResult: boolean;

+ useChangeLog: boolean;

+ useAutoCancel: boolean;

+ useRemote: boolean;

+ address: string;

+ taskId: number;

+ jarFiles: [];

+ pyFiles: [];

+ jobName: string;

+ fragment: boolean;

+ statementSet: boolean;

+ batchModel: boolean;

+ maxRowNum: number;

+ gatewayConfig: any;

+ variables: Map;

+ executorSetting: ExecutorSetting;

+ };

+

export type History = {

id: number;

tenantId: number;

@@ -61,7 +117,7 @@ declare namespace Jobs {

type: string;

error: string;

result: string;

- configJson: JobConfig;

+ configJson: JobConfigJsonInfo;

startTime: string;

endTime: string;

taskId: number;

@@ -166,13 +222,18 @@ declare namespace Jobs {

jid: string;

name: string;

executionConfig: ExecutionConfig;

+ 'execution-config': ExecutionConfig;

};

export type ExecutionConfig = {

executionMode: string;

+ 'execution-mode': string;

restartStrategy: string;

+ 'restart-strategy': string;

jobParallelism: number;

- objectReuse: boolean;

+ 'job-parallelism': number;

+ 'object-reuse': boolean;

userConfig: any;

+ 'user-config': any;

};

export type JobDataDtoItem = {

@@ -191,8 +252,8 @@ declare namespace Jobs {

export type JobInfoDetail = {

id: number;

instance: JobInstance;

- clusterInstance: any;

- clusterConfiguration: any;

+ clusterInstance: Cluster.Instance;

+ clusterConfiguration: Cluster.Config;

history: History;

jobDataDto: JobDataDtoItem;

jobManagerConfiguration: any;

diff --git a/dinky-web/src/utils/function.tsx b/dinky-web/src/utils/function.tsx

index 755deca87d..e00484b843 100644

--- a/dinky-web/src/utils/function.tsx

+++ b/dinky-web/src/utils/function.tsx

@@ -45,7 +45,6 @@ import { l } from '@/utils/intl';

import { Monaco } from '@monaco-editor/react';

import dayjs from 'dayjs';

import cookies from 'js-cookie';

-import { trim } from 'lodash';

import { editor, KeyCode, KeyMod } from 'monaco-editor';

import path from 'path';

import { format } from 'sql-formatter';

@@ -619,6 +618,13 @@ export const formatDateToYYYYMMDDHHMMSS = (date: Date) => {

return dayjs(date).format(DATETIME_FORMAT);

};

+export const formatTimestampToYYYYMMDDHHMMSS = (timestamp: number) => {

+ if (timestamp == null) {

+ return '-';

+ }

+ return dayjs(timestamp).format(DATETIME_FORMAT);

+};

+

export const parseDateStringToDate = (dateString: Date) => {

return dayjs(dateString).toDate();

};

diff --git a/docs/docs/data_integration_guide/dinky_k8s_quick_start.mdx b/docs/docs/data_integration_guide/dinky_k8s_quick_start.mdx

index 74518fffce..f4e08b931f 100644

--- a/docs/docs/data_integration_guide/dinky_k8s_quick_start.mdx

+++ b/docs/docs/data_integration_guide/dinky_k8s_quick_start.mdx

@@ -3,6 +3,7 @@ sidebar_position: 1

id: dinky_k8s_quick_start

title: K8s集成

---

+

import Tabs from '@theme/Tabs';

import TabItem from '@theme/TabItem';

@@ -20,27 +21,21 @@ Dinky支持以下几种 Flink on k8s 运行模式:

**部分内容可参考 Flink 对应集成 k8s 文档链接**

-

-

-

-[https://nightlies.apache.org/flink/flink-docs-release-1.13/zh/docs/deployment/resource-providers/native_kubernetes/](https://nightlies.apache.org/flink/flink-docs-release-1.16/zh/docs/deployment/resource-providers/native_kubernetes/)

-

-

-

-

-[https://nightlies.apache.org/flink/flink-docs-release-1.14/zh/docs/deployment/resource-providers/native_kubernetes/](https://nightlies.apache.org/flink/flink-docs-release-1.16/zh/docs/deployment/resource-providers/native_kubernetes/)

-

-

-

-

-[https://nightlies.apache.org/flink/flink-docs-release-1.15/zh/docs/deployment/resource-providers/native_kubernetes/](https://nightlies.apache.org/flink/flink-docs-release-1.16/zh/docs/deployment/resource-providers/native_kubernetes/)

-

-

-

-

-[https://nightlies.apache.org/flink/flink-docs-release-1.16/zh/docs/deployment/resource-providers/native_kubernetes/](https://nightlies.apache.org/flink/flink-docs-release-1.16/zh/docs/deployment/resource-providers/native_kubernetes/)

-

-

+

+ [https://nightlies.apache.org/flink/flink-docs-release-1.14/zh/docs/deployment/resource-providers/native_kubernetes/](https://nightlies.apache.org/flink/flink-docs-release-1.16/zh/docs/deployment/resource-providers/native_kubernetes/)

+

+

+ [https://nightlies.apache.org/flink/flink-docs-release-1.15/zh/docs/deployment/resource-providers/native_kubernetes/](https://nightlies.apache.org/flink/flink-docs-release-1.16/zh/docs/deployment/resource-providers/native_kubernetes/)

+

+

+ [https://nightlies.apache.org/flink/flink-docs-release-1.16/zh/docs/deployment/resource-providers/native_kubernetes/](https://nightlies.apache.org/flink/flink-docs-release-1.16/zh/docs/deployment/resource-providers/native_kubernetes/)

+

+

+ [https://nightlies.apache.org/flink/flink-docs-release-1.17/zh/docs/deployment/resource-providers/native_kubernetes/](https://nightlies.apache.org/flink/flink-docs-release-1.16/zh/docs/deployment/resource-providers/native_kubernetes/)

+

+

+ [https://nightlies.apache.org/flink/flink-docs-release-1.18/zh/docs/deployment/resource-providers/native_kubernetes/](https://nightlies.apache.org/flink/flink-docs-release-1.16/zh/docs/deployment/resource-providers/native_kubernetes/)

+

@@ -144,52 +139,61 @@ ADD extends /opt/flink/lib # 把当前extends目录下的jar添加进依赖目

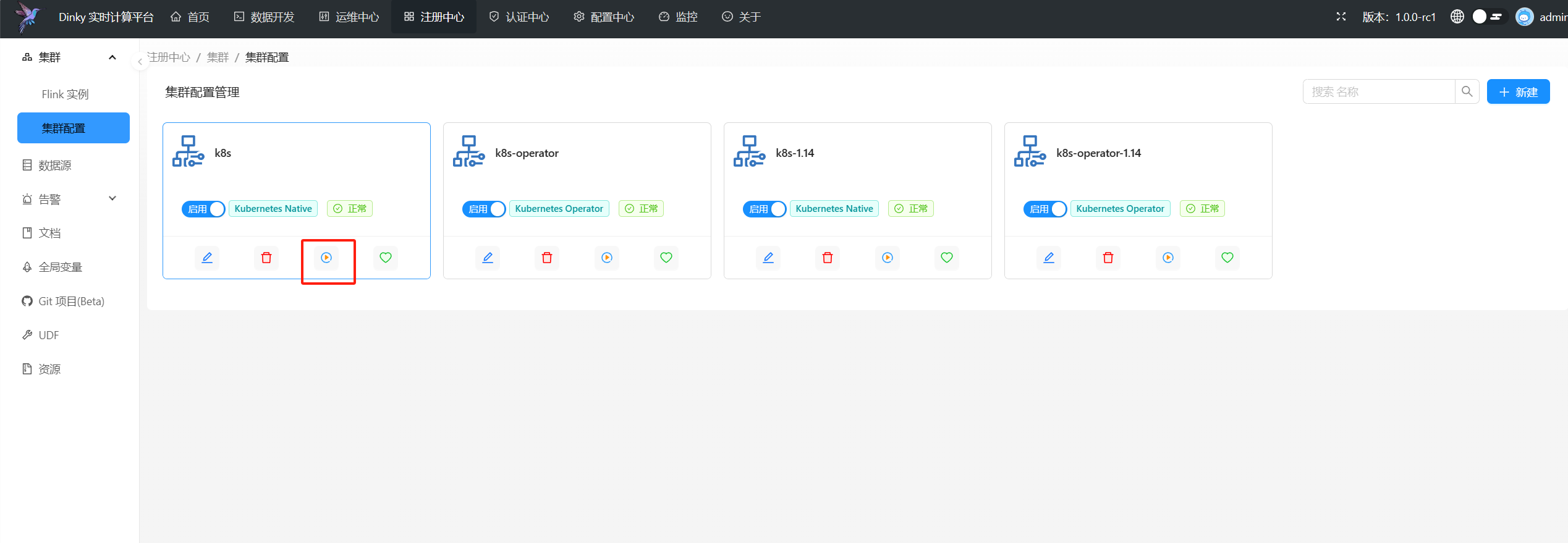

##### Kubernetes 配置

-| 参数 | 说明 | 是否必填 | 默认值 | 示例值 |

-|--------|--------------------------------------------------------|:----:|:---:|:----------:|

-| 暴露端口类型 | 支持NodePort与ClusterIP | 是 | 无 | NodePort |

-| Kubernetes 命名空间 | 集群所在的 Kubernetes 命名空间 | 是 | 无 | dinky |

-| K8s 提交账号 | 集群提交任务的账号 | 是 | 无 | default |

-| Flink 镜像地址 | 上一步打包的镜像地址 | 是 | 无 | dinky-flink-1.0.0-1.15.4 |

-| JobManager CPU 配置 | JobManager 资源配置 | 否 | 无 | 1 |

-| TaskManager CPU 配置 | TaskManager 资源配置 | 否 | 无 | 1 |

-| Flink 配置文件路径 | 仅指定到文件夹,dinky会自行读取文件夹下的配置文件并作为flink的默认配置 | 否 | 无 | /opt/flink/conf |

+| 参数 | 说明 | 是否必填 | 默认值 | 示例值 |

+|--------------------|------------------------------------------|:----:|:---:|:------------------------:|

+| 暴露端口类型 | 支持NodePort与ClusterIP | 是 | 无 | NodePort |

+| Kubernetes 命名空间 | 集群所在的 Kubernetes 命名空间 | 是 | 无 | dinky |

+| K8s 提交账号 | 集群提交任务的账号 | 是 | 无 | default |

+| Flink 镜像地址 | 上一步打包的镜像地址 | 是 | 无 | dinky-flink-1.0.0-1.15.4 |

+| JobManager CPU 配置 | JobManager 资源配置 | 否 | 无 | 1 |

+| TaskManager CPU 配置 | TaskManager 资源配置 | 否 | 无 | 1 |

+| Flink 配置文件路径 | 仅指定到文件夹,dinky会自行读取文件夹下的配置文件并作为flink的默认配置 | 否 | 无 | /opt/flink/conf |

> 如果您有其他的配置项需要添加,请点击添加配置项按钮,添加完毕后,点击保存即可

##### Kubernetes 连接与pod配置

-| 参数 | 说明 | 是否必填 | 默认值 | 示例值 |

-|--------|--------------------------------------------------------|:----:|:---:|:----------:|

-|K8s KubeConfig |集群的KubeConfig内容,如果不填写,则默认使用`~/.kube/config`文件 | 否 | 无 | 无 |

-|Default Pod Template |默认的Pod模板 | 否 | 无 | 无 |

-|JM Pod Template |JobManager的Pod模板 | 否 | 无 | 无 |

-|TM Pod Template |TaskManager的Pod模板 | 否 | 无 | 无 |

+| 参数 | 说明 | 是否必填 | 默认值 | 示例值 |

+|----------------------|-----------------------------------------------|:----:|:---:|:---:|

+| K8s KubeConfig | 集群的KubeConfig内容,如果不填写,则默认使用`~/.kube/config`文件 | 否 | 无 | 无 |

+| Default Pod Template | 默认的Pod模板 | 否 | 无 | 无 |

+| JM Pod Template | JobManager的Pod模板 | 否 | 无 | 无 |

+| TM Pod Template | TaskManager的Pod模板 | 否 | 无 | 无 |

##### 提交 FlinkSQL 配置项 (Application 模式必填)-公共配置

-| 参数 | 说明 | 是否必填 | 默认值 | 示例值 |

-|--------|----------------------------------------------------------------------------------------------------------|:----:|:---:|:--------------:|

-| Jar 文件路径 | 指定镜像内dinky-app的 Jar 文件路径,如果该集群配置用于提交 Application 模式任务时 则必填| 否 | 无 | local:///opt/flink/dinky-app-1.16-1.0.0-jar-with-dependencies.jar |

+| 参数 | 说明 | 是否必填 | 默认值 | 示例值 |

+|----------|------------------------------------------------------------|:----:|:---:|:-----------------------------------------------------------------:|

+| Jar 文件路径 | 指定镜像内dinky-app的 Jar 文件路径,如果该集群配置用于提交 Application 模式任务时 则必填 | 否 | 无 | local:///opt/flink/dinky-app-1.16-1.0.0-jar-with-dependencies.jar |

> 由于flink限制,k8s模式只能加载镜像内的jar包,也就是地址必须为local://开头,如果想要自定义jar提交,请查阅jar提交部分

#### Flink 预设配置(高优先级)-公共配置

-| 参数 | 说明 | 是否必填 | 默认值 | 示例值 |

-|-----------------|----|:----:|:---:|:--:|

-| JobManager 内存 | JobManager 内存大小! | 否 | 无 | 1g |

-| TaskManager 内存 | TaskManager 内存大小! | 否 | 无 | 1g |

-| TaskManager 堆内存 | TaskManager 堆内存大小! | 否 | 无 | 1g |

-| 插槽数 | 插槽数量 | 否 | 无 | 2 |

-| 保存点路径 | 对应SavePoint目录 | 否 | 无 | hdfs:///flink/savepoint |

-| 检查点路径 | 对应CheckPoint目录 | 否 | 无 | hdfs:///flink/checkpoint |

+| 参数 | 说明 | 是否必填 | 默认值 | 示例值 |

+|-----------------|--------------------|:----:|:---:|:------------------------:|

+| JobManager 内存 | JobManager 内存大小! | 否 | 无 | 1g |

+| TaskManager 内存 | TaskManager 内存大小! | 否 | 无 | 1g |

+| TaskManager 堆内存 | TaskManager 堆内存大小! | 否 | 无 | 1g |

+| 插槽数 | 插槽数量 | 否 | 无 | 2 |

+| 保存点路径 | 对应SavePoint目录 | 否 | 无 | hdfs:///flink/savepoint |

+| 检查点路径 | 对应CheckPoint目录 | 否 | 无 | hdfs:///flink/checkpoint |

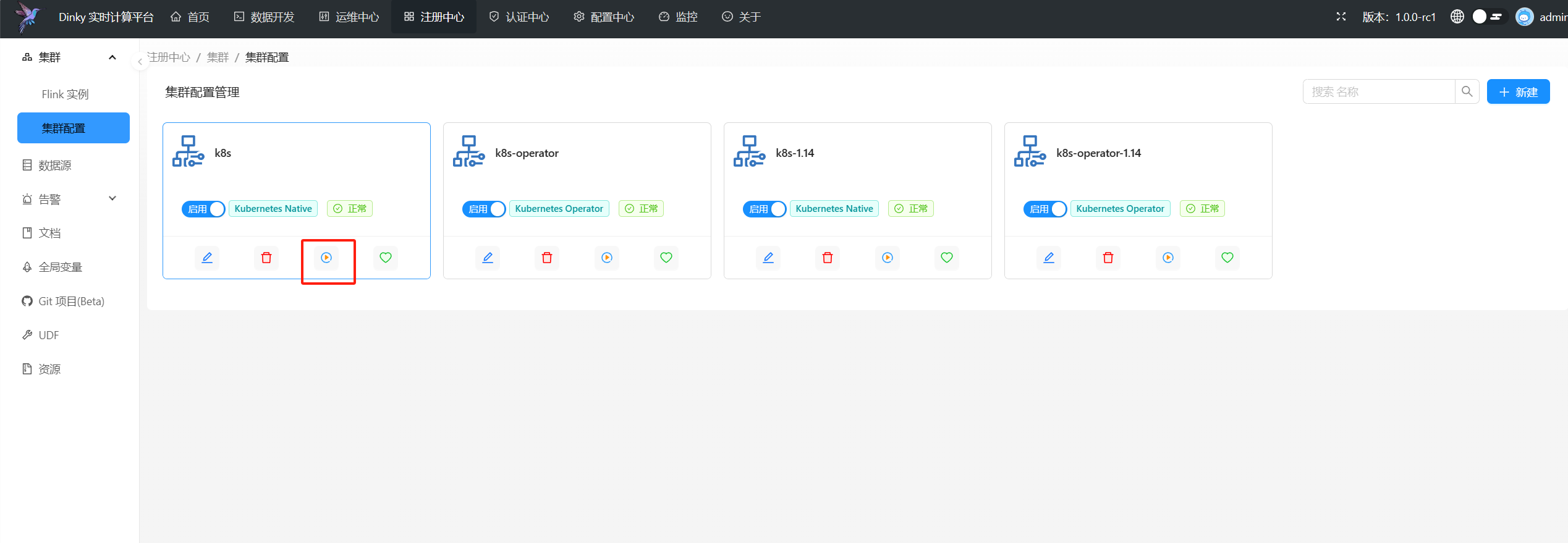

## 启动session集群(可选)

+

除了您自己手动部署session集群外,dinky还提供了快捷方式部署Kubernetes session集群,在上面Kubernetes集群配置完成后,点击启动按钮即可向指定Kubernetes集群提交session集群

+

+

至此,所有准备工作均已完成完成,接下来就可以通过` kubernetes session`模式或`kubernetes application`模式进行任务提交啦。

+

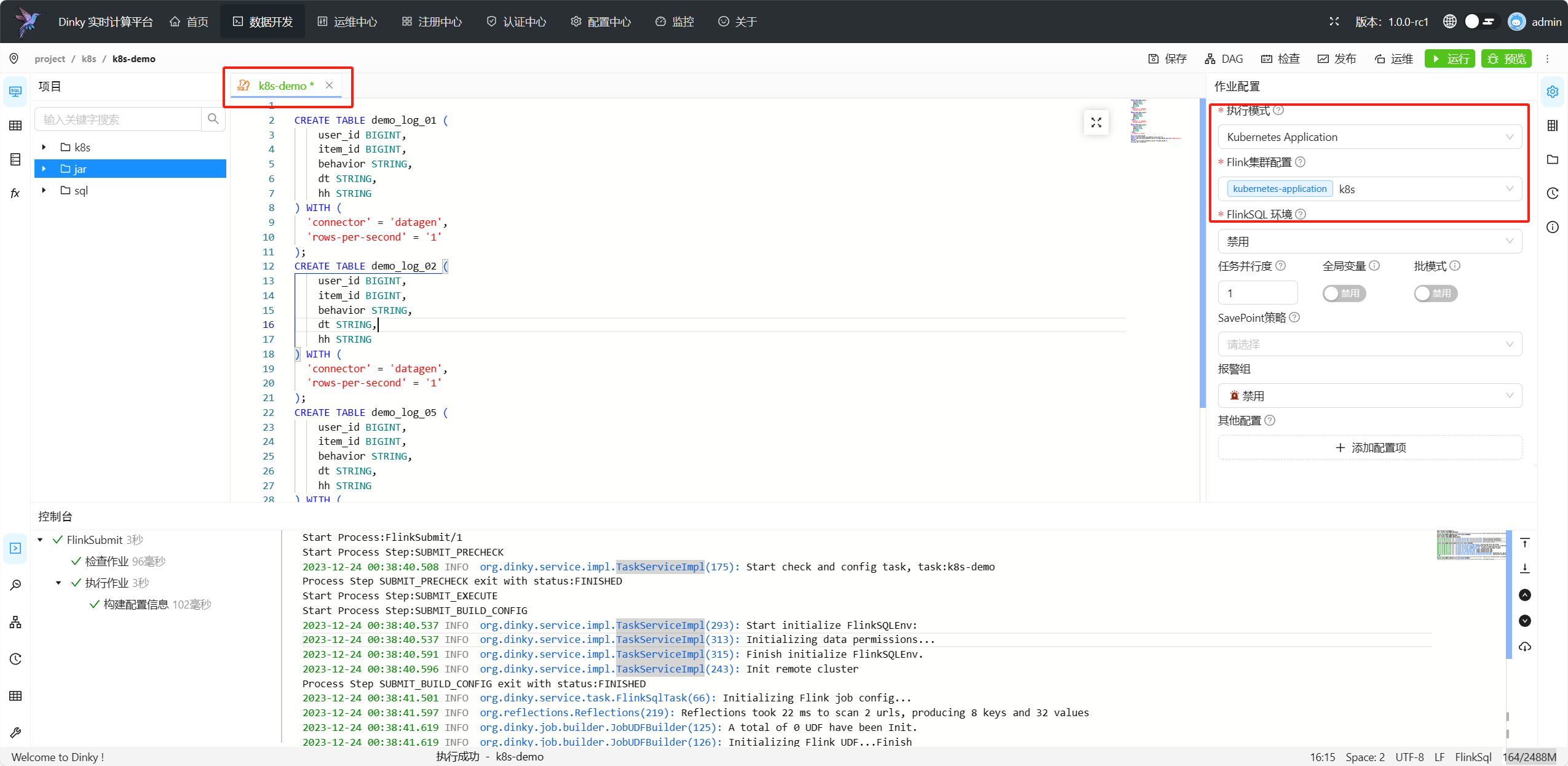

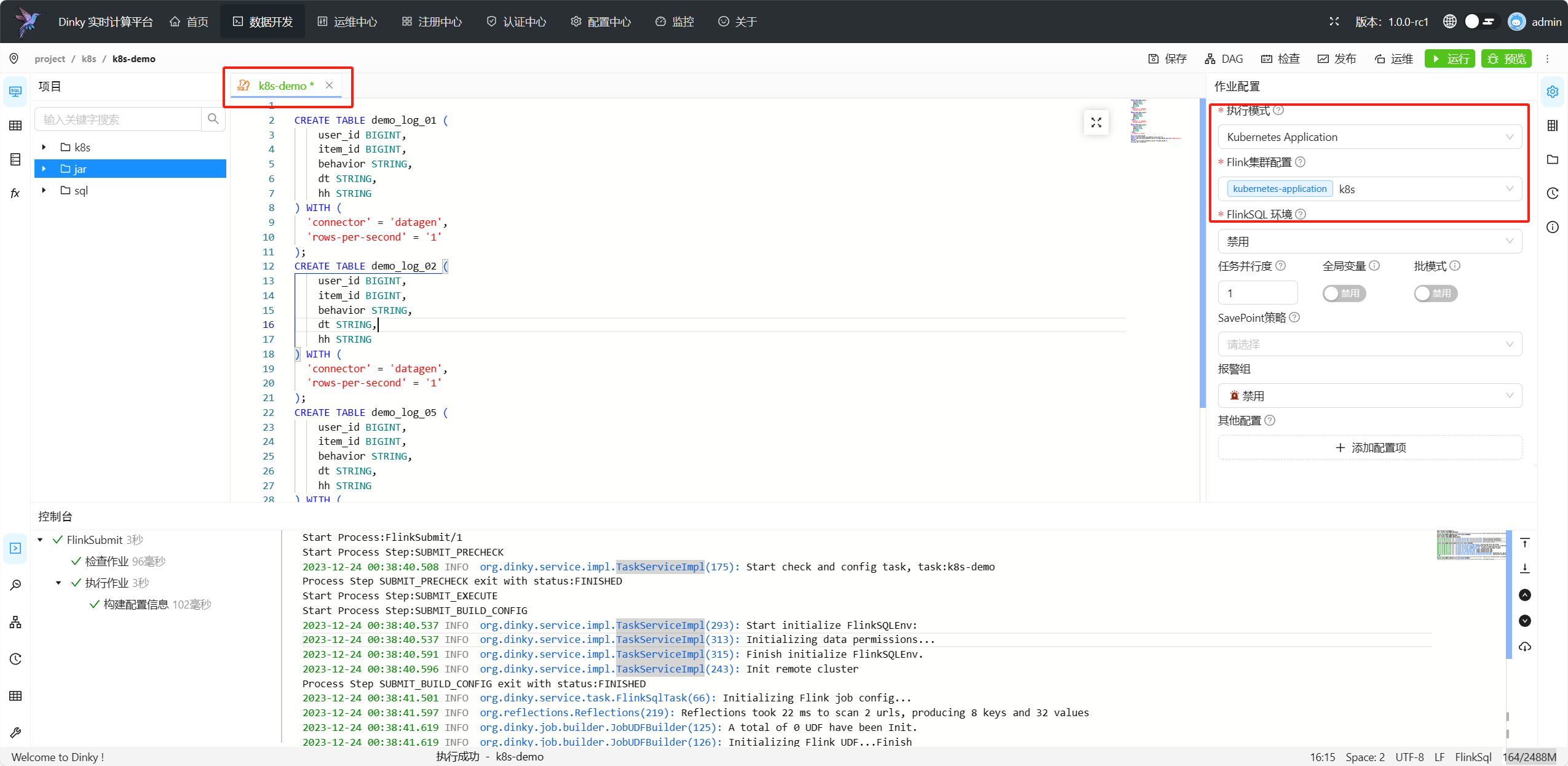

## 提交 kubernetes application 任务

+

进入数据开发页面,新建一个flink sql任务,选择集群类型为`kubernetes application`,集群选择为我们刚刚配置的集群,点击提交即可

-## 提交 kubernetes session 任务

+

+

+

+## 提交 kubernetes session 任务

+

进入数据开发页面,新建一个flink sql任务,选择集群类型为`kubernetes session`,集群选择为我们刚刚配置的集群,点击提交即可

图片同上

\ No newline at end of file

diff --git a/docs/docs/developer_guide/local_debug.md b/docs/docs/developer_guide/local_debug.md

index 8d1bbd6a94..69d99a8ecb 100644

--- a/docs/docs/developer_guide/local_debug.md

+++ b/docs/docs/developer_guide/local_debug.md

@@ -90,7 +90,7 @@ npm run dev

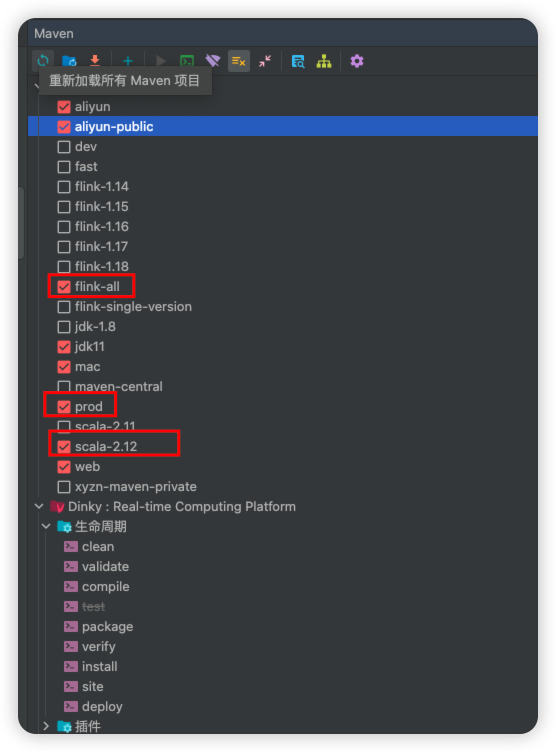

由于目前 Dinky 各个模块未发布到 Maven 中央仓库,所以需要先进行 Install 编译。从而在本地仓库中生成相应的依赖。

-如果你是第一次编译 Dinky,那么请勾选以下 Maven Profile,然后下图中的`生命周期 -> Install`进行编译。

+如果你是第一次编译 Dinky,那么请勾选以下 Maven Profile,然后双击下图中的`生命周期 -> Install`进行编译。

:::

diff --git a/docs/docs/extend/function_expansion/alert.md b/docs/docs/extend/function_expansion/alert.md

deleted file mode 100644

index abd034f218..0000000000

--- a/docs/docs/extend/function_expansion/alert.md

+++ /dev/null

@@ -1,169 +0,0 @@

----

-sidebar_position: 4

-id: alert

-title: 扩展报警插件

----

-

-

-

-

-Dinky 告警机制遵循 SPI,可随意扩展所需要的告警机制。如需扩展可在 dinky-alert 模块中进行可插拔式扩展。现已经支持的告警机制包括如下:

-

-- DingDingTalk

-- 企业微信: 同时支持**APP** 和 **WeChat 群聊** 方式

-- Email

-- 飞书

-

-Dinky 学习了 ``Apache Dolphinscheduler`` 的插件扩展机制,可以在 Dinky 中添加自定义的告警机制。

-

-## 准备工作

-- 本地开发环境搭建

- - 详见 [开发者本地调试手册](../../developer_guide/local_debug)

-

-## 后端开发

-- 在 **dinky-alert** 新建子模块 , 命名规则为 `dinky-alert-{报警类型}` 在子模块中实现相关告警机制

-- **代码层面** 根据告警场景自行实现报警逻辑

- - 注意事项:

- - 不可在父类的基础上修改代码,可以在子类中进行扩展 ,或者重写父类方法

- - 注意告警所使用到的常量需要继承**AlertBaseConstant** 其他差异的特殊常量在新建的模块中定义,参考其他告警类型代码

- - 扩展告警类型需要同时提交**测试用例**

-- 需要在新建的此模块的 **resource** 下 新建包 ``META-INF.services`` , 在此包中新建文件 ``org.dinky.alert.Alert`` 内容如下:

- - ``org.dinky.alert.{报警类型}.{报警类型Alert}`` 参考其他告警类型的此文件

-- 打包相关配置 修改如下:

- - 在 **dinky-core** 模块的 **pom.xml** 下 , 找到扩展告警相关的依赖 `放在一起方便管理` 并且新增如下内容:

- ```xml

-

- org.dinky

- 模块名称

- ${scope.runtime}

-

- ```

-

- - 在 **dinky-admin** 模块的 **pom.xml** 下 , 找到扩展告警相关的依赖 `放在一起方便管理` 并且新增如下内容:

- ```xml

-

- org.dinky

- 模块名称

- ${expand.scope}

-

- ```

-

-- 在 **dinky** 根下 **pom.xml** 中 ,新增如下内容:

- ```xml

-

- org.dinky

- 模块名称

- ${project.version}

-

- ```

-

-- 在 **dinky-assembly** 模块中 , 找到 ``package.xml`` 路径: **/dinky-assembly/src/main/assembly/package.xml** , 新增如下内容:

-```xml

-

- ${project.parent.basedir}/dinky-alert/模块名称/target

-

- lib

-

- 模块名称-${project.version}.jar

-

-

- ```

-

-

-----

-

-## 前端开发

-- **dinky-web** 为 Dinky 的前端模块

-- 扩展告警插件相关表单所在路径: `dinky-web/src/pages/RegistrationCenter/AlertManage/AlertInstance`

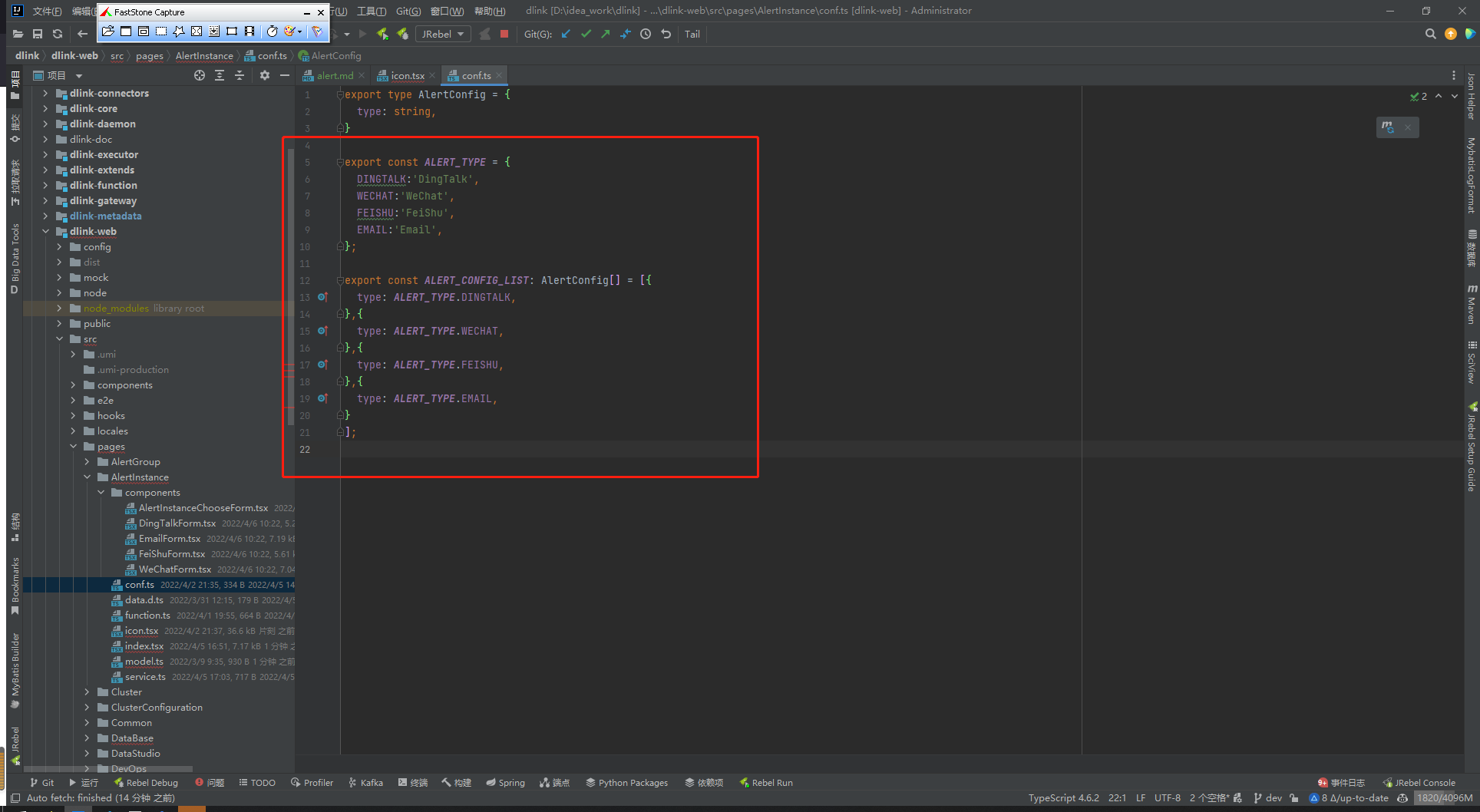

- - 修改 `dinky-web/src/pages/RegistrationCenter/AlertManage/AlertInstance/conf.ts`

-

- **ALERT_TYPE** 添加如下 eg:

- ``` typescript

- EMAIL:'Email',

- ```

- **ALERT_CONFIG_LIST** 添加如下 eg:

- ```typescript

- {

- type: ALERT_TYPE.EMAIL,

- }

- ```

- **注意:** 此处属性值需要与后端 `AlertTypeEnum` 声明的值保持一致

-

-如下图:

-

-

-

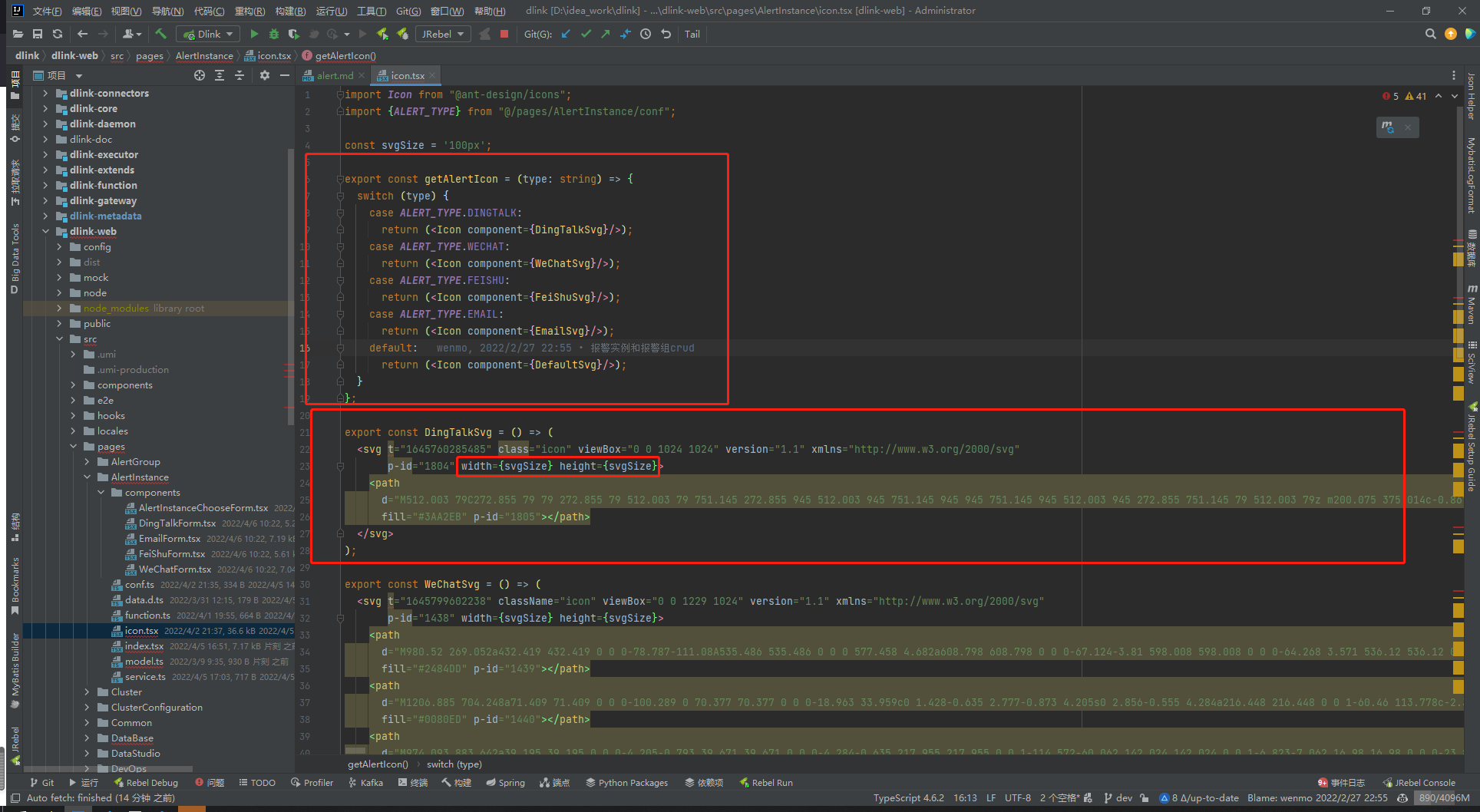

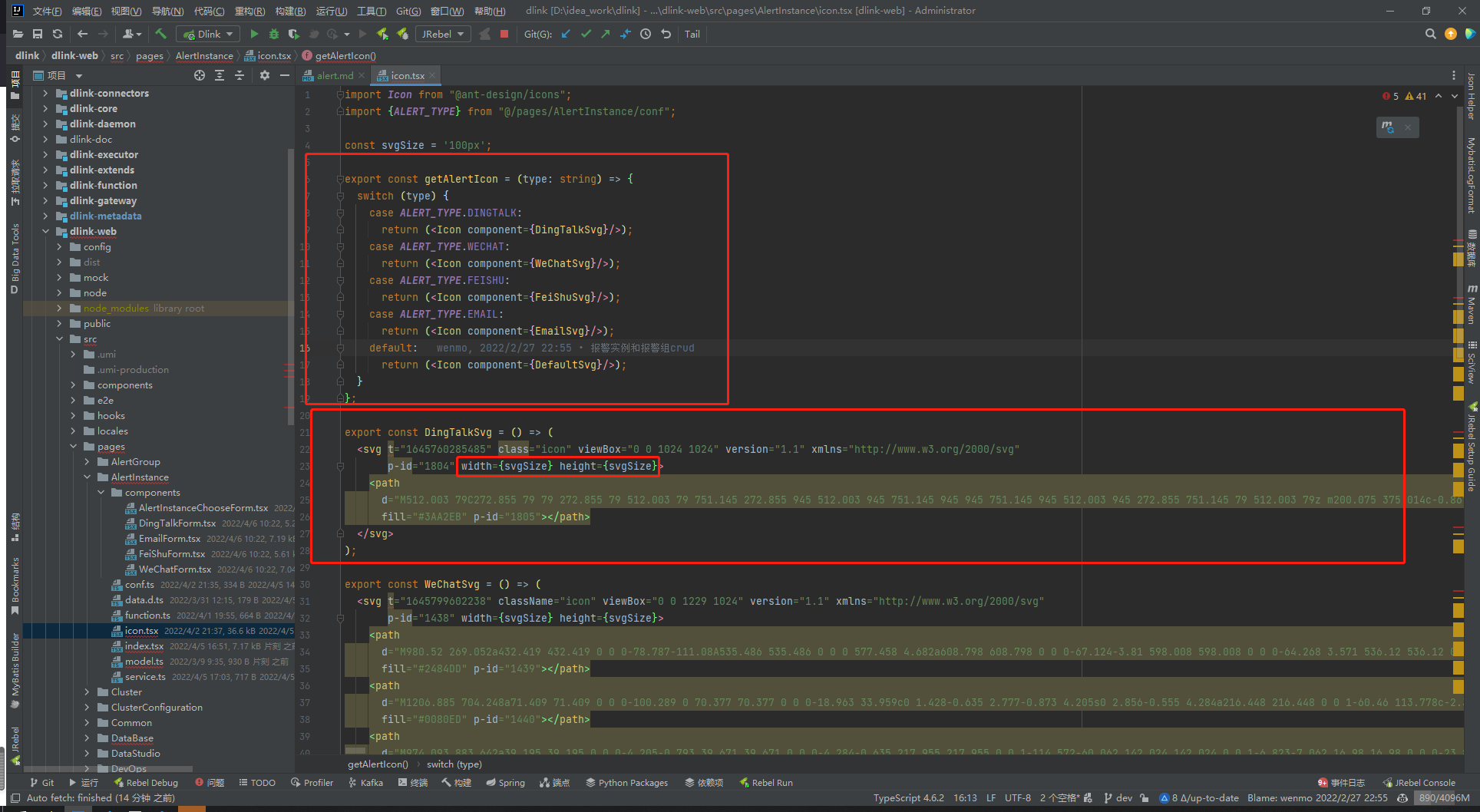

- 修改 `dinky-web/src/pages/RegistrationCenter/AlertManage/AlertInstance/icon.tsx` 的 **getAlertIcon** 中

-

- 添加如下 eg:

-```typescript

- case ALERT_TYPE.EMAIL:

- return ();

-```

-同时在下方定义 SVG : `如不定义将使用默认 SVG`

-

-svg 获取: [https://www.iconfont.cn](https://www.iconfont.cn)

-``` typescript

-export const EmailSvg = () => (

- {svg 相关代码}

-);

-```

-**注意:** svg 相关代码中需要将 **width** **height** 统一更换为 **width={svgSize} height={svgSize}**

-

-如下图:

-

-

-

-

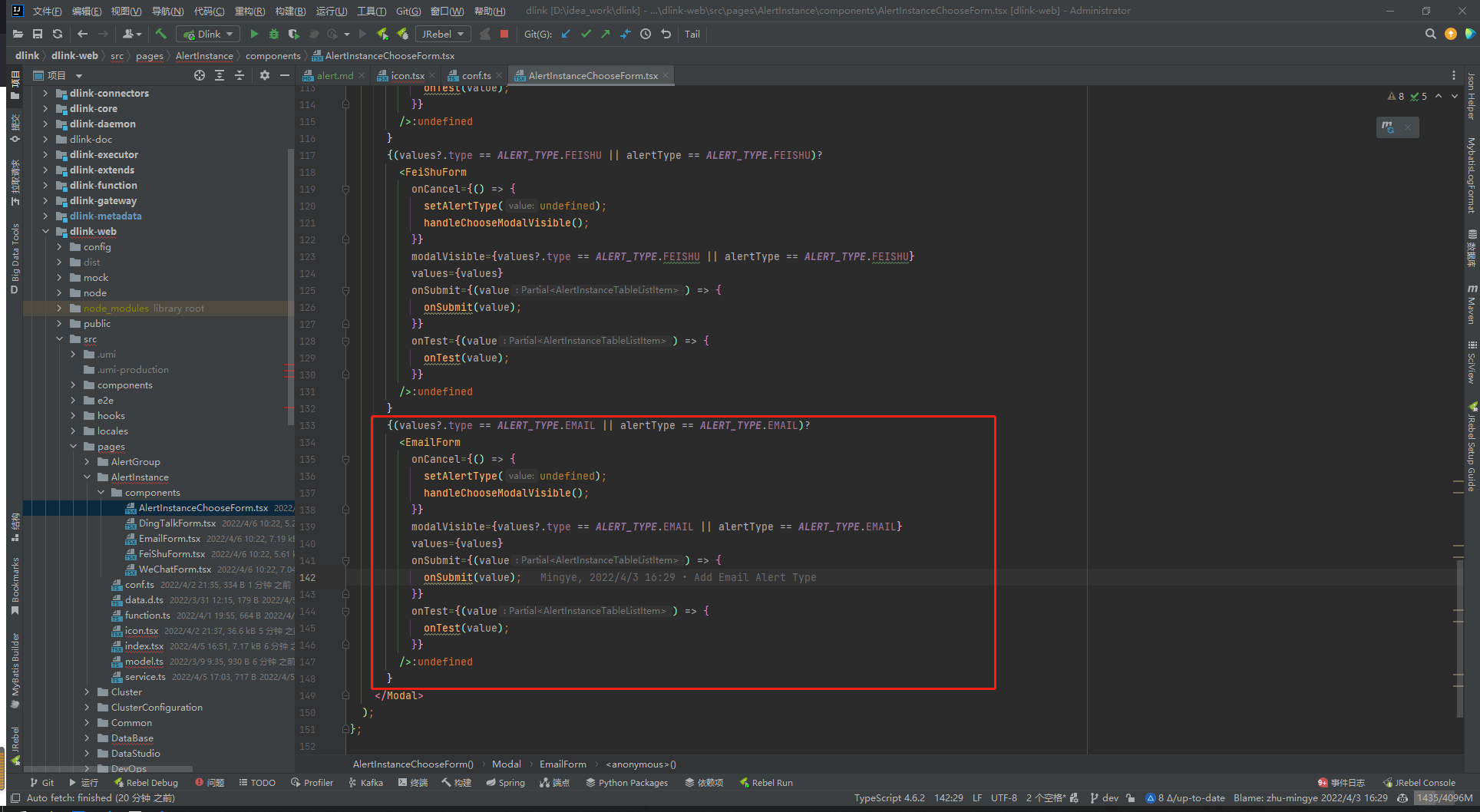

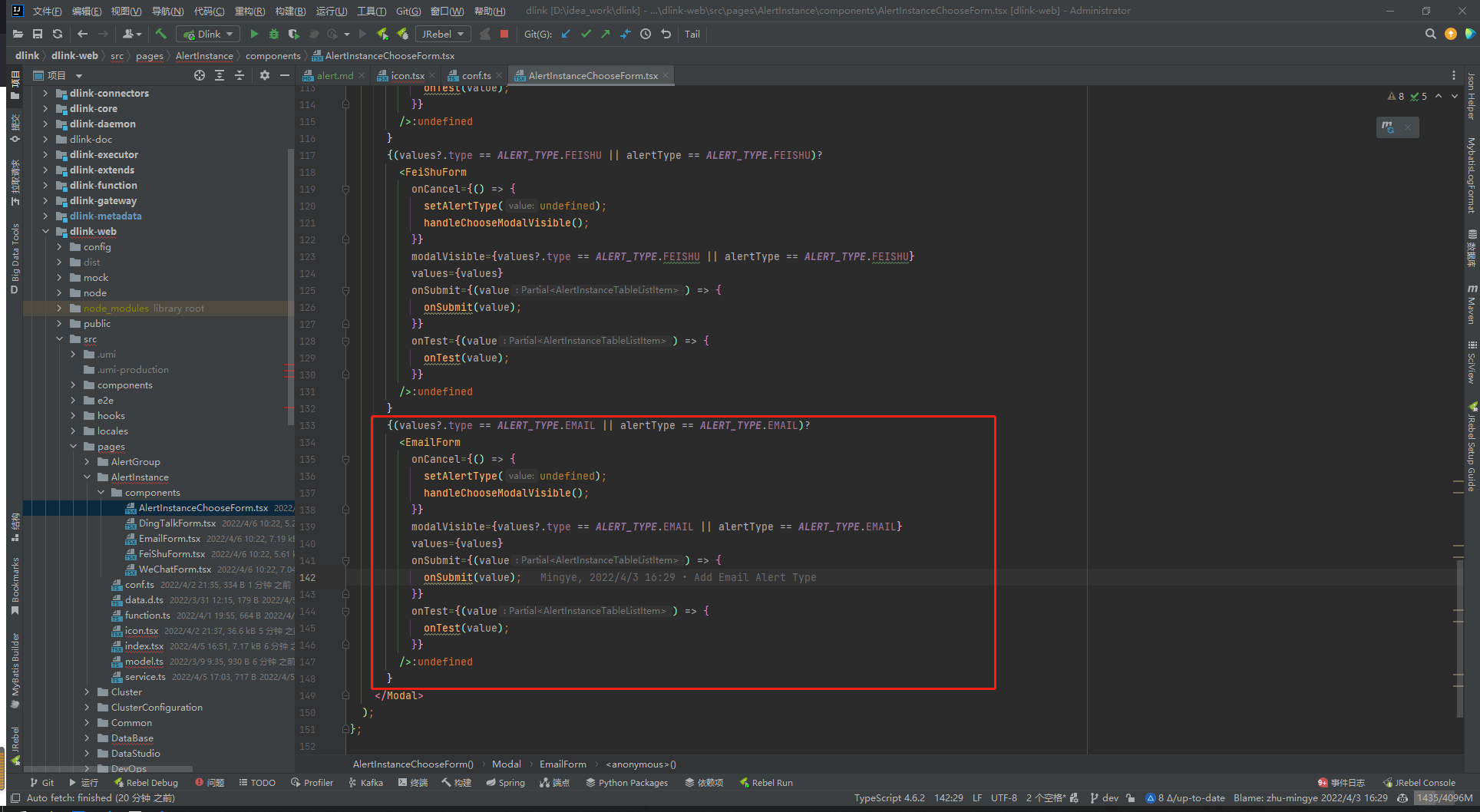

- - 修改 `dinky-web/src/pages/RegistrationCenter/AlertManage/AlertInstance/components/AlertInstanceChooseForm.tsx`

-

- 追加如下 eg:

-```typescript

- {(values?.type == ALERT_TYPE.EMAIL || alertType == ALERT_TYPE.EMAIL)?

- {

- setAlertType(undefined);

- handleChooseModalVisible();

- }}

- modalVisible={values?.type == ALERT_TYPE.EMAIL || alertType == ALERT_TYPE.EMAIL}

- values={values}

- onSubmit={(value) => {

- onSubmit(value);

- }}

- onTest={(value) => {

- onTest(value);

- }}

- />:undefined

- }

-```

-其中需要修改的地方为

-- `EMAIL` 替换为上述 **dinky-web/src/pages/RegistrationCenter/AlertManage/AlertInstance/conf.ts** 中 **ALERT_TYPE** 的新增类型

-- `EmailForm` 为新建告警表单文件 **dinky-web/src/pages/RegistrationCenter/AlertManage/AlertInstance/components/EmailForm.tsx** 中的 **EmailForm** .

-

-如下图:

-

-

- - 需要新建表单文件 , 命名规则: ``{告警类型}Form``

- - 该文件中除 **表单属性** 外 , 其余可参照其他类型告警 , 建议复制其他类型告警的表单 , 修改其中的表单属性即可

- - 注意:

- - 部分表单属性保存为 Json 格式

- - 需要修改 如下的表单配置

-

-

- ```typescript

- // 找到如下相关代码:

- const [formVals, setFormVals] = useState>({

- id: props.values?.id,

- name: props.values?.name,

- type: ALERT_TYPE.EMAIL, // 此处需要修改为新增的告警类型

- params: props.values?.params,

- enabled: props.values?.enabled,

- });

-

-```

-

-

-----

-:::tip 说明

-至此 , 基于 Dinky 扩展告警完成 , 如您也有扩展需求 ,请参照如何 [[Issuse]](../../developer_guide/contribution/issue) 和如何[[提交 PR]](../../developer_guide/contribution/pull_request)

-:::

\ No newline at end of file

diff --git a/docs/docs/extend/function_expansion/completion.md b/docs/docs/extend/function_expansion/completion.md

deleted file mode 100644

index 652aab6d32..0000000000

--- a/docs/docs/extend/function_expansion/completion.md

+++ /dev/null

@@ -1,44 +0,0 @@

----

-sidebar_position: 5

-id: completion

-title: FlinkSQL 编辑器自动补全函数

----

-

-

-

-

-## FlinkSQL 编辑器自动补全函数

-

-Dlink-0.3.2 版本上线了一个非常实用的功能——自动补全。

-

-我们在使用 IDEA 等工具时,提示方法并补全、生成的功能大大提升了开发效率。而 Dlink 的目标便是让 FlinkSQL 更加丝滑,所以其提供了自定义的自动补全功能。对比传统的使用 `Java` 字符串来编写 FlinkSQL 的方式,Dlink 的优势是巨大。

-

-在文档中心,我们可以根据自己的需要扩展相应的自动补全规则,如 `UDF`、`Connector With` 等 FlinkSQL 片段,甚至可以扩展任意可以想象到内容,如注释、模板、配置、算法等。

-

-具体新增规则的示例请看下文描述。

-

-## set 语法来设置执行环境参数

-

-对于一个 FlinkSQL 的任务来说,除了 sql 口径,其任务配置也十分重要。所以 Dlink-0.3.2 版本中提供了 `sql-client` 的 `set` 语法,可以通过 `set` 关键字来指定任务的执行配置(如 “ `set table.exec.resource.default-parallelism=2;` ” ),其优先级要高于 Dlink 自身的任务配置(面板右侧)。

-

-那么长的参数一般人谁记得住?等等,别忘了 Dlink 的新功能自动补全~

-

-配置实现输入 `parallelism` 子字符串来自动补全 `table.exec.resource.default-parallelism=` 。

-

-在文档中心中添加一个规则,名称为 `parallelism`,填充值为 `table.exec.resource.default-parallelism=`,其他内容随意。

-

-保存之后,来到编辑器输入 `par` .

-

-选中要补全的规则后,编辑器中自动补全了 `table.exec.resource.default-parallelism=` 。

-

-至此,有些小伙伴发现,是不是可以直接定义 `pl2` 来自动生成 `set table.exec.resource.default-parallelism=2;` ?

-

-当然可以的。

-

-还有小伙伴问,可不可以定义 `pl` 生成 `set table.exec.resource.default-parallelism=;` 后,光标自动定位到 `=` 于 `;` 之间?

-

-这个也可以的,只需要定义 `pl` 填充值为 `set table.exec.resource.default-parallelism=${1:};` ,即可实现。

-

-所以说,只要能想象到的都可以定义,这样的 Dlink 你爱了吗?

-

-嘘,还有点小 bug 后续修复呢。如果有什么建议及问题请及时指出哦。

\ No newline at end of file

diff --git a/docs/docs/extend/function_expansion/connector.md b/docs/docs/extend/function_expansion/connector.md

deleted file mode 100644

index ab25f82d72..0000000000

--- a/docs/docs/extend/function_expansion/connector.md

+++ /dev/null

@@ -1,38 +0,0 @@

----

-sidebar_position: 2

-id: connector

-title: 扩展连接器

----

-

-

-

-

-## Flink Connector 介绍

-

-Flink做为实时计算引擎,支持非常丰富的上下游存储系统的 Connectors。并从这些上下系统读写数据并进行计算。对于这些 Connectors 在 Flink 中统一称之为数据源(Source) 端和 目标(Sink) 端。

-

-- 数据源(Source)指的是输入流计算系统的上游存储系统来源。在当前的 FlinkSQL 模式的作业中,数据源可以是消息队列 Kafka、数据库 MySQL 等。

-- 目标(Sink)指的是流计算系统输出处理结果的目的地。在当前的流计算 FlinkSQL 模式的作业中,目标端可以是消息队列 Kafka、数据库 MySQL、OLAP引擎 Doris、ClickHouse 等。

-

-Dinky 实时计算平台支持支持 Flink 1.13、Flink 1.14、Flink 1.15、Flink 1.16 五个版本,对应的版本支持所有开源的上下游存储系统具体Connector信息详见Flink开源社区:

-

-- [Flink1.13](https://nightlies.apache.org/flink/flink-docs-release-1.13/docs/connectors/table/overview/)

-- [Flink1.14](https://nightlies.apache.org/flink/flink-docs-release-1.14/docs/connectors/table/overview/)

-- [Flink1.15](https://nightlies.apache.org/flink/flink-docs-release-1.15/docs/connectors/table/overview/)

-- [Flink1.16](https://nightlies.apache.org/flink/flink-docs-release-1.16/docs/connectors/table/overview/)

-

-

-另外非 Flink 官网支持的 Connector 详见 github:

-

-- [Flink-CDC](https://github.com/ververica/flink-cdc-connectors/releases/)

-- [Hudi](https://github.com/apache/hudi/releases)

-- [Iceberg](https://github.com/apache/iceberg/releases)

-- [Doris](https://github.com/apache/incubator-doris-flink-connector/tags)

-- [Starrocks](https://github.com/StarRocks/flink-connector-starrocks/releases)

-- [ClickHouse](https://github.com/itinycheng/flink-connector-clickhouse)

-- [Pulsar](https://github.com/streamnative/pulsar-flink/releases)

-

-

-## 扩展 Connector

-

-将 Flink 集群上已扩展好的 Connector 直接放入 Dlink 的 lib 或者 plugins 下,然后重启即可。定制 Connector 过程同 Flink 官方一样。

diff --git a/docs/docs/extend/function_expansion/datasource.md b/docs/docs/extend/function_expansion/datasource.md

deleted file mode 100644

index 3e909022f6..0000000000

--- a/docs/docs/extend/function_expansion/datasource.md

+++ /dev/null

@@ -1,623 +0,0 @@

----

-sidebar_position: 3

-id: datasource

-title: 扩展数据源

----

-

-

-

-

- Dinky 数据源遵循 SPI,可随意扩展所需要的数据源。数据源扩展可在 dlink-metadata 模块中进行可插拔式扩展。现已经支持的数据源包括如下:

-

- - MySQL

- - Oracle

- - SQLServer

- - PostGreSQL

- - Phoenix

- - Doris(Starrocks)

- - ClickHouse

- - Hive ``需要的jar包: hive-jdbc-2.1.1.jar && hive-service-2.1.1.jar``

-

-使用以上数据源,详见注册中心[数据源管理](../../user_guide/register_center/datasource_manage),配置数据源连接

-:::tip 注意事项

- Dinky 不在对 Starorcks 进行额外扩展,Doris 和 Starorcks 底层并无差别,原则上只是功能区分。经社区测试验证,可采用 Doris 扩展连接 Starrocks。

-:::

-----

-

-## 准备工作

-- 本地开发环境搭建

- - 详见 [开发者本地调试手册](../../developer_guide/local_debug)

-

-## 后端开发

-- 本文以 Hive 数据源扩展为例

-- 在 **dlink-metadata** 模块中, 右键**新建子模块**, 命名规则: **dlink-metadata-{数据源名称}**

-- **代码层面**

- - 注意事项:

- - 不可在父类的基础上修改代码,可以在子类中进行扩展 ,或者重写父类方法

- - 扩展数据源需要同时提交**测试用例**

- - 在此模块的 **pom.xml** 中,添加所需依赖, 需要注意的是 : 数据源本身的 ``JDBC``的 jar 不要包含在打包中 , 而是后续部署时,添加在 ``plugins`` 下

- - 需要在此模块的 **resource** 下 新建包 ``META-INF.services`` , 在此包中新建文件 ``com.dlink.metadata.driver.Driver`` 内容如下:

- - ``com.dlink.metadata.driver.数据源类型Driver``

- 基础包:

-```bash

-顶层包名定义: com.dlink.metadata

- 子包含义:

- - constant: 常量定义 目前此模块中主要定义各种动态构建的执行 SQL

- - convert: 存放数据源的数据类型<->Java 类型的转换类 ps: 可以不定义 不定义使用 dlink-metadata-base 的默认转换 即调用父类的方法

- - driver: 存放数据源驱动类,获取元数据的主要类,类 extends AbstractJdbcDriver implements Driver

- - query : 存放解析获取元数据的主要类,类 extends AbstractDBQuery 方法不重写 默认使用父类

-```

-代码如下:

-

-HiveConstant

-```java

-public interface HiveConstant {

-

- /**

- * 查询所有database

- */

- String QUERY_ALL_DATABASE = " show databases";

- /**

- * 查询所有schema下的所有表

- */

- String QUERY_ALL_TABLES_BY_SCHEMA = "show tables";

- /**

- * 扩展信息Key

- */

- String DETAILED_TABLE_INFO = "Detailed Table Information";

- /**

- * 查询指定schema.table的扩展信息

- */

- String QUERY_TABLE_SCHEMA_EXTENED_INFOS = " describe extended `%s`.`%s`";

- /**

- * 查询指定schema.table的信息 列 列类型 列注释

- */

- String QUERY_TABLE_SCHEMA = " describe `%s`.`%s`";

- /**

- * 使用 DB

- */

- String USE_DB = "use `%s`";

- /**

- * 只查询指定schema.table的列名

- */

- String QUERY_TABLE_COLUMNS_ONLY = "show columns in `%s`.`%s`";

-}

-

-```

-

-HiveTypeConvert

-```java

-

-public class HiveTypeConvert implements ITypeConvert {

- // 主要是将获取到的数据类型转换为 Java 数据类型的映射 存储在 Column 中 , 此处根据扩展的数据源特性进行修改

- @Override

- public ColumnType convert(Column column) {

- if (Asserts.isNull(column)) {

- return ColumnType.STRING;

- }

- String t = column.getType().toLowerCase().trim();

- if (t.contains("char")) {

- return ColumnType.STRING;

- } else if (t.contains("boolean")) {

- if (column.isNullable()) {

- return ColumnType.JAVA_LANG_BOOLEAN;

- }

- return ColumnType.BOOLEAN;

- } else if (t.contains("tinyint")) {

- if (column.isNullable()) {

- return ColumnType.JAVA_LANG_BYTE;

- }

- return ColumnType.BYTE;

- } else if (t.contains("smallint")) {

- if (column.isNullable()) {

- return ColumnType.JAVA_LANG_SHORT;

- }

- return ColumnType.SHORT;

- } else if (t.contains("bigint")) {

- if (column.isNullable()) {

- return ColumnType.JAVA_LANG_LONG;

- }

- return ColumnType.LONG;

- } else if (t.contains("largeint")) {

- return ColumnType.STRING;

- } else if (t.contains("int")) {

- if (column.isNullable()) {

- return ColumnType.INTEGER;

- }

- return ColumnType.INT;

- } else if (t.contains("float")) {

- if (column.isNullable()) {

- return ColumnType.JAVA_LANG_FLOAT;

- }

- return ColumnType.FLOAT;

- } else if (t.contains("double")) {

- if (column.isNullable()) {

- return ColumnType.JAVA_LANG_DOUBLE;

- }

- return ColumnType.DOUBLE;

- } else if (t.contains("timestamp")) {

- return ColumnType.TIMESTAMP;

- } else if (t.contains("date")) {

- return ColumnType.STRING;

- } else if (t.contains("datetime")) {

- return ColumnType.STRING;

- } else if (t.contains("decimal")) {

- return ColumnType.DECIMAL;

- } else if (t.contains("time")) {

- return ColumnType.DOUBLE;

- }

- return ColumnType.STRING;

- }

-

- // 转换为 DB 的数据类型

- @Override

- public String convertToDB(ColumnType columnType) {

- switch (columnType) {

- case STRING:

- return "varchar";

- case BOOLEAN:

- case JAVA_LANG_BOOLEAN:

- return "boolean";

- case BYTE:

- case JAVA_LANG_BYTE:

- return "tinyint";

- case SHORT:

- case JAVA_LANG_SHORT:

- return "smallint";

- case LONG:

- case JAVA_LANG_LONG:

- return "bigint";

- case FLOAT:

- case JAVA_LANG_FLOAT:

- return "float";

- case DOUBLE:

- case JAVA_LANG_DOUBLE:

- return "double";

- case DECIMAL:

- return "decimal";

- case INT:

- case INTEGER:

- return "int";

- case TIMESTAMP:

- return "timestamp";

- default:

- return "varchar";

- }

- }

-}

-

-

-```

-

-

-HiveDriver

-```java

-

-public class HiveDriver extends AbstractJdbcDriver implements Driver {

- // 获取表的信息

- @Override

- public Table getTable(String schemaName, String tableName) {

- List

+

diff --git a/dinky-admin/src/main/java/org/dinky/service/impl/TaskServiceImpl.java b/dinky-admin/src/main/java/org/dinky/service/impl/TaskServiceImpl.java

index 43d4d5d36a..550be8e02b 100644

--- a/dinky-admin/src/main/java/org/dinky/service/impl/TaskServiceImpl.java

+++ b/dinky-admin/src/main/java/org/dinky/service/impl/TaskServiceImpl.java

@@ -511,14 +511,21 @@ public boolean changeTaskLifeRecyle(Integer taskId, JobLifeCycle lifeCycle) thro

boolean saved = saveOrUpdate(task.buildTask());

if (saved && Asserts.isNotNull(task.getJobInstanceId())) {

JobInstance jobInstance = jobInstanceService.getById(task.getJobInstanceId());

- jobInstance.setStep(lifeCycle.getValue());

- jobInstanceService.updateById(jobInstance);

- log.info("jobInstance [{}] step change to {}", jobInstance.getJid(), lifeCycle.getValue());

+ if (Asserts.isNotNull(jobInstance)) {

+ jobInstance.setStep(lifeCycle.getValue());

+ boolean updatedJobInstance = jobInstanceService.updateById(jobInstance);

+ if (updatedJobInstance) jobInstanceService.refreshJobInfoDetail(jobInstance.getId(), true);

+ log.warn(

+ "JobInstance [{}] step change to [{}] ,Trigger Force Refresh",

+ jobInstance.getName(),

+ lifeCycle.getValue());

+ }

}

return saved;

}

@Override

+ @Transactional(rollbackFor = Exception.class)

public boolean saveOrUpdateTask(Task task) {

Task byId = getById(task.getId());

if (byId != null && JobLifeCycle.PUBLISH.equalsValue(byId.getStep())) {

diff --git a/dinky-web/src/pages/DataStudio/LeftContainer/Project/function.tsx b/dinky-web/src/pages/DataStudio/LeftContainer/Project/function.tsx

index e3d76a29a8..36b02ad10f 100644

--- a/dinky-web/src/pages/DataStudio/LeftContainer/Project/function.tsx

+++ b/dinky-web/src/pages/DataStudio/LeftContainer/Project/function.tsx

@@ -80,19 +80,19 @@ export const buildStepValue = (step: number) => {

return {

title: l('global.table.lifecycle.dev'),

status: 'processing',

- color: '#1890ff'

+ color: 'cyan'

};

case 2:

return {

title: l('global.table.lifecycle.online'),

status: 'success',

- color: '#52c41a'

+ color: 'purple'

};

default:

return {

title: l('global.table.lifecycle.dev'),

status: 'default',

- color: '#1890ff'

+ color: 'cyan'

};

}

};

@@ -144,7 +144,8 @@ export const buildProjectTree = (

<>

);

diff --git a/dinky-web/src/pages/DevOps/JobDetail/JobOverview/components/FlinkTable.tsx b/dinky-web/src/pages/DevOps/JobDetail/JobOverview/components/FlinkTable.tsx

index dd539aaa97..bc2a4595fa 100644

--- a/dinky-web/src/pages/DevOps/JobDetail/JobOverview/components/FlinkTable.tsx

+++ b/dinky-web/src/pages/DevOps/JobDetail/JobOverview/components/FlinkTable.tsx

@@ -19,7 +19,12 @@

import StatusTag from '@/components/JobTags/StatusTag';

import { JobProps } from '@/pages/DevOps/JobDetail/data';

-import { parseByteStr, parseMilliSecondStr, parseNumStr } from '@/utils/function';

+import {

+ formatTimestampToYYYYMMDDHHMMSS,

+ parseByteStr,

+ parseMilliSecondStr,

+ parseNumStr

+} from '@/utils/function';

import { l } from '@/utils/intl';

import { ProCard, ProColumns, ProTable } from '@ant-design/pro-components';

import { Typography } from 'antd';

@@ -32,8 +37,10 @@ export type VerticesTableListItem = {

metrics: any;

parallelism: number;

startTime?: number;

+ 'start-time'?: number;

duration?: number;

endTime?: number;

+ 'end-time'?: number;

tasks: any;

};

@@ -101,15 +108,20 @@ const FlinkTable = (props: JobProps): JSX.Element => {

},

{

title: l('global.table.startTime'),

- dataIndex: 'startTime',

- valueType: 'dateTime'

+ render: (dom, entity) => {

+ return entity.startTime === -1 || entity['start-time'] === -1

+ ? '-'

+ : formatTimestampToYYYYMMDDHHMMSS(entity['start-time'] as number) ||

+ formatTimestampToYYYYMMDDHHMMSS(entity.startTime as number);

+ }

},

{

title: l('global.table.endTime'),

- dataIndex: 'endTime',

- valueType: 'dateTime',

render: (dom, entity) => {

- return entity.endTime === -1 ? '-' : entity.endTime;

+ return entity.endTime === -1 || entity['end-time'] === -1

+ ? '-'

+ : formatTimestampToYYYYMMDDHHMMSS(entity['end-time'] as number) ||

+ formatTimestampToYYYYMMDDHHMMSS(entity.endTime as number);

}

},

{

diff --git a/dinky-web/src/pages/DevOps/JobDetail/JobOverview/components/JobDesc.tsx b/dinky-web/src/pages/DevOps/JobDetail/JobOverview/components/JobDesc.tsx

index bb645801e7..99e50d90f6 100644

--- a/dinky-web/src/pages/DevOps/JobDetail/JobOverview/components/JobDesc.tsx

+++ b/dinky-web/src/pages/DevOps/JobDetail/JobOverview/components/JobDesc.tsx

@@ -88,7 +88,7 @@ const JobDesc = (props: JobProps) => {

- {jobDetail?.jobDataDto?.config?.executionConfig?.restartStrategy}

+ {jobDetail?.jobDataDto?.config['execution-config']['restart-strategy']}

@@ -109,13 +109,11 @@ const JobDesc = (props: JobProps) => {

- {jobDetail?.history?.configJson?.useSqlFragment

- ? l('button.enable')

- : l('button.disable')}

+ {jobDetail?.history?.configJson?.fragment ? l('button.enable') : l('button.disable')}

- {jobDetail?.history?.configJson?.useBatchModel

+ {jobDetail?.history?.configJson?.batchModel

? l('global.table.execmode.batch')

: l('global.table.execmode.streaming')}

@@ -125,7 +123,7 @@ const JobDesc = (props: JobProps) => {

- {jobDetail?.jobDataDto?.config?.executionConfig?.jobParallelism}

+ {jobDetail?.jobDataDto?.config['execution-config']['job-parallelism']}

@@ -137,7 +135,7 @@ const JobDesc = (props: JobProps) => {

- {jobDetail?.history?.configJson.savePointPath}

+ {jobDetail?.history?.configJson?.configJson['state.savepoints.dir'] ?? '-'}

diff --git a/dinky-web/src/pages/DevOps/JobDetail/index.tsx b/dinky-web/src/pages/DevOps/JobDetail/index.tsx

index 337d7ab1b4..e80134a2af 100644

--- a/dinky-web/src/pages/DevOps/JobDetail/index.tsx

+++ b/dinky-web/src/pages/DevOps/JobDetail/index.tsx

@@ -65,7 +65,7 @@ const JobDetail = (props: any) => {

pollingInterval: 3000

});

- const jobInfoDetail: Jobs.JobInfoDetail = data;

+ const jobInfoDetail = data as Jobs.JobInfoDetail;

const [tabKey, setTabKey] = useState(OperatorEnum.JOB_BASE_INFO);

diff --git a/dinky-web/src/types/DevOps/data.d.ts b/dinky-web/src/types/DevOps/data.d.ts

index 13d615472b..f25fff4868 100644

--- a/dinky-web/src/types/DevOps/data.d.ts

+++ b/dinky-web/src/types/DevOps/data.d.ts

@@ -18,7 +18,7 @@

*/

import { BaseBeanColumns } from '@/types/Public/data';

-import { Alert } from '@/types/RegCenter/data.d';

+import { Alert, Cluster } from '@/types/RegCenter/data.d';

/**

* about flink job

@@ -48,6 +48,62 @@ declare namespace Jobs {

useBatchModel: string;

};

+ export type ExecutorSetting = {

+ type: string;

+ host: string;

+ port: number;

+ useBatchModel: boolean;

+ checkpoint: string;

+ parallelism: number;

+ useSqlFragment: boolean;

+ useStatementSet: boolean;

+ savePointPath: string;

+ jobName: string;

+ config: Map;

+ variables: Map;

+ jarFiles: [];

+ jobManagerAddress: string;

+ plan: boolean;

+ remote: boolean;

+ validParallelism: boolean;

+ validJobName: boolean;

+ validHost: boolean;

+ validPort: boolean;

+ validConfig: boolean;

+ validVariables: boolean;

+ validJarFiles: boolean;

+ };

+

+ export type JobConfigJsonInfo = {

+ type: string;

+ checkpoint: string;

+ savePointStrategy: string;

+ savePointPath: string;

+ parallelism: number;

+ clusterId: number;

+ clusterConfigurationId: number;

+ step: number;

+ configJson: {

+ 'state.savepoints.dir': string;

+ };

+ useResult: boolean;

+ useChangeLog: boolean;

+ useAutoCancel: boolean;

+ useRemote: boolean;

+ address: string;

+ taskId: number;

+ jarFiles: [];

+ pyFiles: [];

+ jobName: string;

+ fragment: boolean;

+ statementSet: boolean;

+ batchModel: boolean;

+ maxRowNum: number;

+ gatewayConfig: any;

+ variables: Map;

+ executorSetting: ExecutorSetting;

+ };

+

export type History = {

id: number;

tenantId: number;

@@ -61,7 +117,7 @@ declare namespace Jobs {

type: string;

error: string;

result: string;

- configJson: JobConfig;

+ configJson: JobConfigJsonInfo;

startTime: string;

endTime: string;

taskId: number;

@@ -166,13 +222,18 @@ declare namespace Jobs {

jid: string;

name: string;

executionConfig: ExecutionConfig;

+ 'execution-config': ExecutionConfig;

};

export type ExecutionConfig = {

executionMode: string;

+ 'execution-mode': string;

restartStrategy: string;

+ 'restart-strategy': string;

jobParallelism: number;

- objectReuse: boolean;

+ 'job-parallelism': number;

+ 'object-reuse': boolean;

userConfig: any;

+ 'user-config': any;

};

export type JobDataDtoItem = {

@@ -191,8 +252,8 @@ declare namespace Jobs {

export type JobInfoDetail = {

id: number;

instance: JobInstance;

- clusterInstance: any;

- clusterConfiguration: any;

+ clusterInstance: Cluster.Instance;

+ clusterConfiguration: Cluster.Config;

history: History;

jobDataDto: JobDataDtoItem;

jobManagerConfiguration: any;

diff --git a/dinky-web/src/utils/function.tsx b/dinky-web/src/utils/function.tsx

index 755deca87d..e00484b843 100644

--- a/dinky-web/src/utils/function.tsx

+++ b/dinky-web/src/utils/function.tsx

@@ -45,7 +45,6 @@ import { l } from '@/utils/intl';

import { Monaco } from '@monaco-editor/react';

import dayjs from 'dayjs';

import cookies from 'js-cookie';

-import { trim } from 'lodash';

import { editor, KeyCode, KeyMod } from 'monaco-editor';

import path from 'path';

import { format } from 'sql-formatter';

@@ -619,6 +618,13 @@ export const formatDateToYYYYMMDDHHMMSS = (date: Date) => {

return dayjs(date).format(DATETIME_FORMAT);

};

+export const formatTimestampToYYYYMMDDHHMMSS = (timestamp: number) => {

+ if (timestamp == null) {

+ return '-';

+ }

+ return dayjs(timestamp).format(DATETIME_FORMAT);

+};

+

export const parseDateStringToDate = (dateString: Date) => {

return dayjs(dateString).toDate();

};

diff --git a/docs/docs/data_integration_guide/dinky_k8s_quick_start.mdx b/docs/docs/data_integration_guide/dinky_k8s_quick_start.mdx

index 74518fffce..f4e08b931f 100644

--- a/docs/docs/data_integration_guide/dinky_k8s_quick_start.mdx

+++ b/docs/docs/data_integration_guide/dinky_k8s_quick_start.mdx

@@ -3,6 +3,7 @@ sidebar_position: 1

id: dinky_k8s_quick_start

title: K8s集成

---

+

import Tabs from '@theme/Tabs';

import TabItem from '@theme/TabItem';

@@ -20,27 +21,21 @@ Dinky支持以下几种 Flink on k8s 运行模式:

**部分内容可参考 Flink 对应集成 k8s 文档链接**

-

-

-

-[https://nightlies.apache.org/flink/flink-docs-release-1.13/zh/docs/deployment/resource-providers/native_kubernetes/](https://nightlies.apache.org/flink/flink-docs-release-1.16/zh/docs/deployment/resource-providers/native_kubernetes/)

-

-

-

-

-[https://nightlies.apache.org/flink/flink-docs-release-1.14/zh/docs/deployment/resource-providers/native_kubernetes/](https://nightlies.apache.org/flink/flink-docs-release-1.16/zh/docs/deployment/resource-providers/native_kubernetes/)

-

-

-

-

-[https://nightlies.apache.org/flink/flink-docs-release-1.15/zh/docs/deployment/resource-providers/native_kubernetes/](https://nightlies.apache.org/flink/flink-docs-release-1.16/zh/docs/deployment/resource-providers/native_kubernetes/)

-

-

-

-

-[https://nightlies.apache.org/flink/flink-docs-release-1.16/zh/docs/deployment/resource-providers/native_kubernetes/](https://nightlies.apache.org/flink/flink-docs-release-1.16/zh/docs/deployment/resource-providers/native_kubernetes/)

-

-

+

+ [https://nightlies.apache.org/flink/flink-docs-release-1.14/zh/docs/deployment/resource-providers/native_kubernetes/](https://nightlies.apache.org/flink/flink-docs-release-1.16/zh/docs/deployment/resource-providers/native_kubernetes/)

+

+

+ [https://nightlies.apache.org/flink/flink-docs-release-1.15/zh/docs/deployment/resource-providers/native_kubernetes/](https://nightlies.apache.org/flink/flink-docs-release-1.16/zh/docs/deployment/resource-providers/native_kubernetes/)

+

+

+ [https://nightlies.apache.org/flink/flink-docs-release-1.16/zh/docs/deployment/resource-providers/native_kubernetes/](https://nightlies.apache.org/flink/flink-docs-release-1.16/zh/docs/deployment/resource-providers/native_kubernetes/)

+

+

+ [https://nightlies.apache.org/flink/flink-docs-release-1.17/zh/docs/deployment/resource-providers/native_kubernetes/](https://nightlies.apache.org/flink/flink-docs-release-1.16/zh/docs/deployment/resource-providers/native_kubernetes/)

+

+

+ [https://nightlies.apache.org/flink/flink-docs-release-1.18/zh/docs/deployment/resource-providers/native_kubernetes/](https://nightlies.apache.org/flink/flink-docs-release-1.16/zh/docs/deployment/resource-providers/native_kubernetes/)

+

@@ -144,52 +139,61 @@ ADD extends /opt/flink/lib # 把当前extends目录下的jar添加进依赖目

##### Kubernetes 配置

-| 参数 | 说明 | 是否必填 | 默认值 | 示例值 |

-|--------|--------------------------------------------------------|:----:|:---:|:----------:|

-| 暴露端口类型 | 支持NodePort与ClusterIP | 是 | 无 | NodePort |

-| Kubernetes 命名空间 | 集群所在的 Kubernetes 命名空间 | 是 | 无 | dinky |

-| K8s 提交账号 | 集群提交任务的账号 | 是 | 无 | default |

-| Flink 镜像地址 | 上一步打包的镜像地址 | 是 | 无 | dinky-flink-1.0.0-1.15.4 |

-| JobManager CPU 配置 | JobManager 资源配置 | 否 | 无 | 1 |

-| TaskManager CPU 配置 | TaskManager 资源配置 | 否 | 无 | 1 |

-| Flink 配置文件路径 | 仅指定到文件夹,dinky会自行读取文件夹下的配置文件并作为flink的默认配置 | 否 | 无 | /opt/flink/conf |

+| 参数 | 说明 | 是否必填 | 默认值 | 示例值 |

+|--------------------|------------------------------------------|:----:|:---:|:------------------------:|

+| 暴露端口类型 | 支持NodePort与ClusterIP | 是 | 无 | NodePort |

+| Kubernetes 命名空间 | 集群所在的 Kubernetes 命名空间 | 是 | 无 | dinky |

+| K8s 提交账号 | 集群提交任务的账号 | 是 | 无 | default |

+| Flink 镜像地址 | 上一步打包的镜像地址 | 是 | 无 | dinky-flink-1.0.0-1.15.4 |

+| JobManager CPU 配置 | JobManager 资源配置 | 否 | 无 | 1 |

+| TaskManager CPU 配置 | TaskManager 资源配置 | 否 | 无 | 1 |

+| Flink 配置文件路径 | 仅指定到文件夹,dinky会自行读取文件夹下的配置文件并作为flink的默认配置 | 否 | 无 | /opt/flink/conf |

> 如果您有其他的配置项需要添加,请点击添加配置项按钮,添加完毕后,点击保存即可

##### Kubernetes 连接与pod配置

-| 参数 | 说明 | 是否必填 | 默认值 | 示例值 |

-|--------|--------------------------------------------------------|:----:|:---:|:----------:|

-|K8s KubeConfig |集群的KubeConfig内容,如果不填写,则默认使用`~/.kube/config`文件 | 否 | 无 | 无 |

-|Default Pod Template |默认的Pod模板 | 否 | 无 | 无 |

-|JM Pod Template |JobManager的Pod模板 | 否 | 无 | 无 |

-|TM Pod Template |TaskManager的Pod模板 | 否 | 无 | 无 |

+| 参数 | 说明 | 是否必填 | 默认值 | 示例值 |

+|----------------------|-----------------------------------------------|:----:|:---:|:---:|

+| K8s KubeConfig | 集群的KubeConfig内容,如果不填写,则默认使用`~/.kube/config`文件 | 否 | 无 | 无 |

+| Default Pod Template | 默认的Pod模板 | 否 | 无 | 无 |

+| JM Pod Template | JobManager的Pod模板 | 否 | 无 | 无 |

+| TM Pod Template | TaskManager的Pod模板 | 否 | 无 | 无 |

##### 提交 FlinkSQL 配置项 (Application 模式必填)-公共配置

-| 参数 | 说明 | 是否必填 | 默认值 | 示例值 |

-|--------|----------------------------------------------------------------------------------------------------------|:----:|:---:|:--------------:|

-| Jar 文件路径 | 指定镜像内dinky-app的 Jar 文件路径,如果该集群配置用于提交 Application 模式任务时 则必填| 否 | 无 | local:///opt/flink/dinky-app-1.16-1.0.0-jar-with-dependencies.jar |

+| 参数 | 说明 | 是否必填 | 默认值 | 示例值 |

+|----------|------------------------------------------------------------|:----:|:---:|:-----------------------------------------------------------------:|

+| Jar 文件路径 | 指定镜像内dinky-app的 Jar 文件路径,如果该集群配置用于提交 Application 模式任务时 则必填 | 否 | 无 | local:///opt/flink/dinky-app-1.16-1.0.0-jar-with-dependencies.jar |

> 由于flink限制,k8s模式只能加载镜像内的jar包,也就是地址必须为local://开头,如果想要自定义jar提交,请查阅jar提交部分

#### Flink 预设配置(高优先级)-公共配置

-| 参数 | 说明 | 是否必填 | 默认值 | 示例值 |

-|-----------------|----|:----:|:---:|:--:|

-| JobManager 内存 | JobManager 内存大小! | 否 | 无 | 1g |

-| TaskManager 内存 | TaskManager 内存大小! | 否 | 无 | 1g |

-| TaskManager 堆内存 | TaskManager 堆内存大小! | 否 | 无 | 1g |

-| 插槽数 | 插槽数量 | 否 | 无 | 2 |

-| 保存点路径 | 对应SavePoint目录 | 否 | 无 | hdfs:///flink/savepoint |

-| 检查点路径 | 对应CheckPoint目录 | 否 | 无 | hdfs:///flink/checkpoint |

+| 参数 | 说明 | 是否必填 | 默认值 | 示例值 |

+|-----------------|--------------------|:----:|:---:|:------------------------:|

+| JobManager 内存 | JobManager 内存大小! | 否 | 无 | 1g |

+| TaskManager 内存 | TaskManager 内存大小! | 否 | 无 | 1g |

+| TaskManager 堆内存 | TaskManager 堆内存大小! | 否 | 无 | 1g |

+| 插槽数 | 插槽数量 | 否 | 无 | 2 |

+| 保存点路径 | 对应SavePoint目录 | 否 | 无 | hdfs:///flink/savepoint |

+| 检查点路径 | 对应CheckPoint目录 | 否 | 无 | hdfs:///flink/checkpoint |

## 启动session集群(可选)

+

除了您自己手动部署session集群外,dinky还提供了快捷方式部署Kubernetes session集群,在上面Kubernetes集群配置完成后,点击启动按钮即可向指定Kubernetes集群提交session集群

+

+

至此,所有准备工作均已完成完成,接下来就可以通过` kubernetes session`模式或`kubernetes application`模式进行任务提交啦。

+

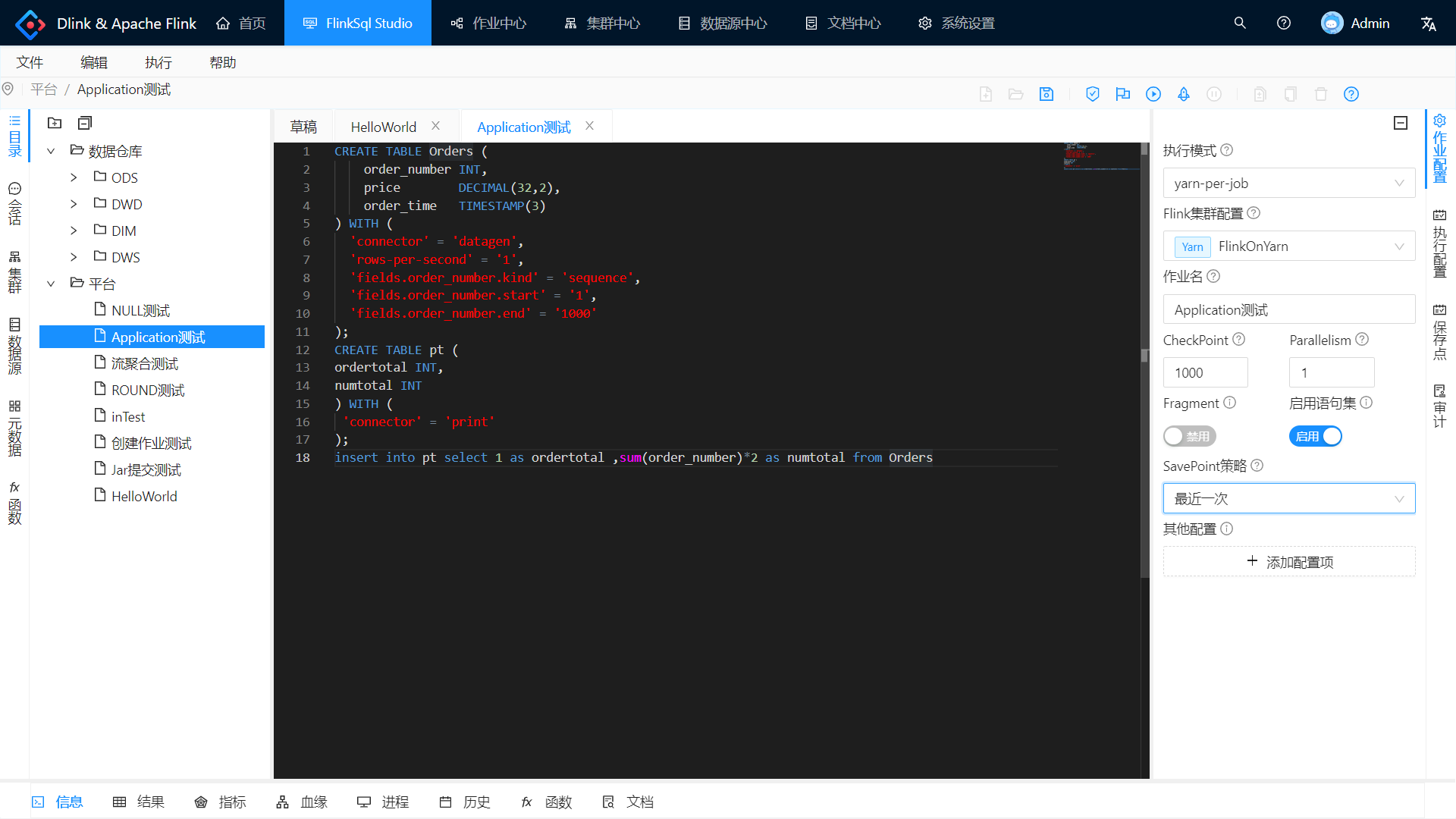

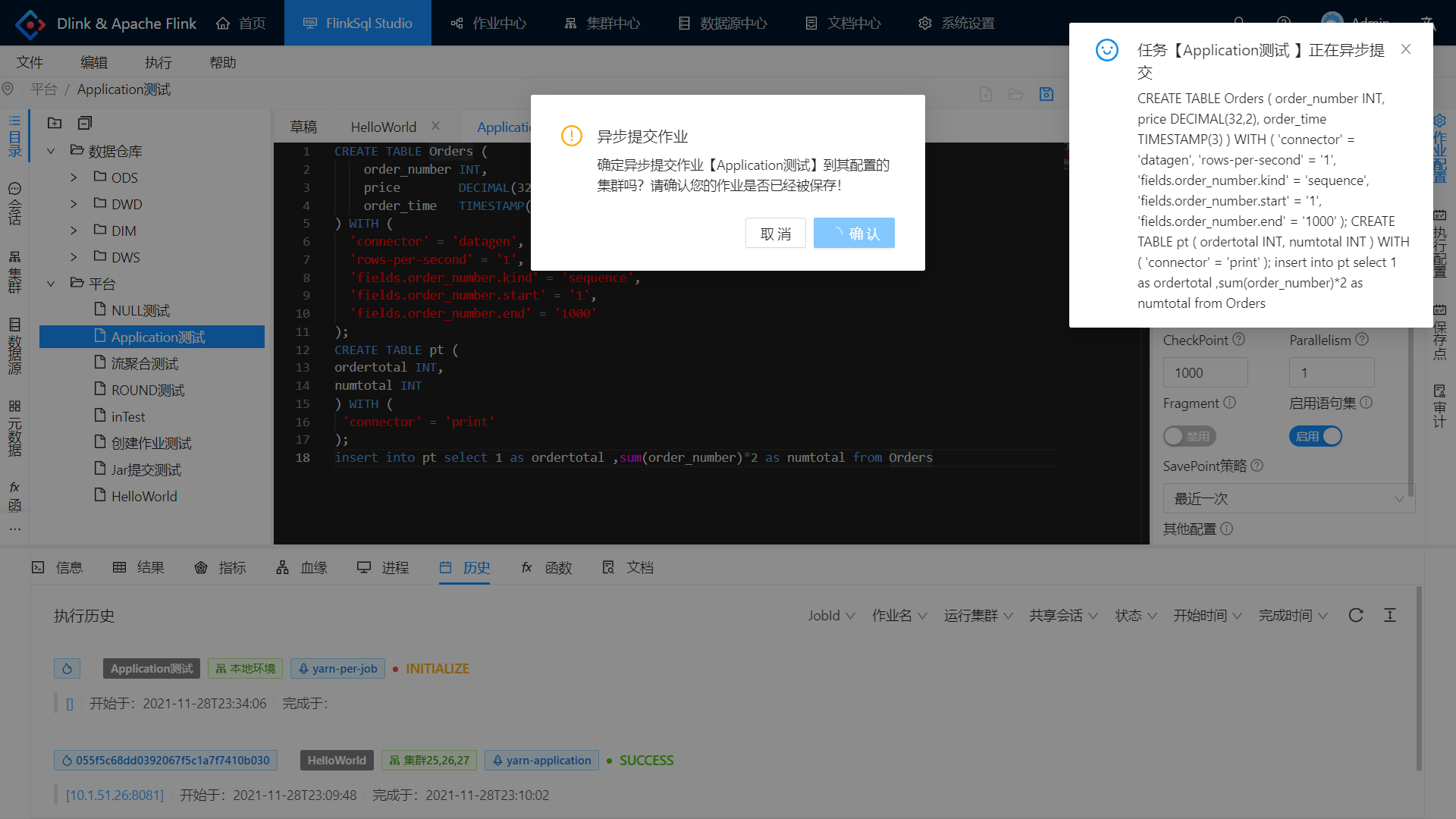

## 提交 kubernetes application 任务

+

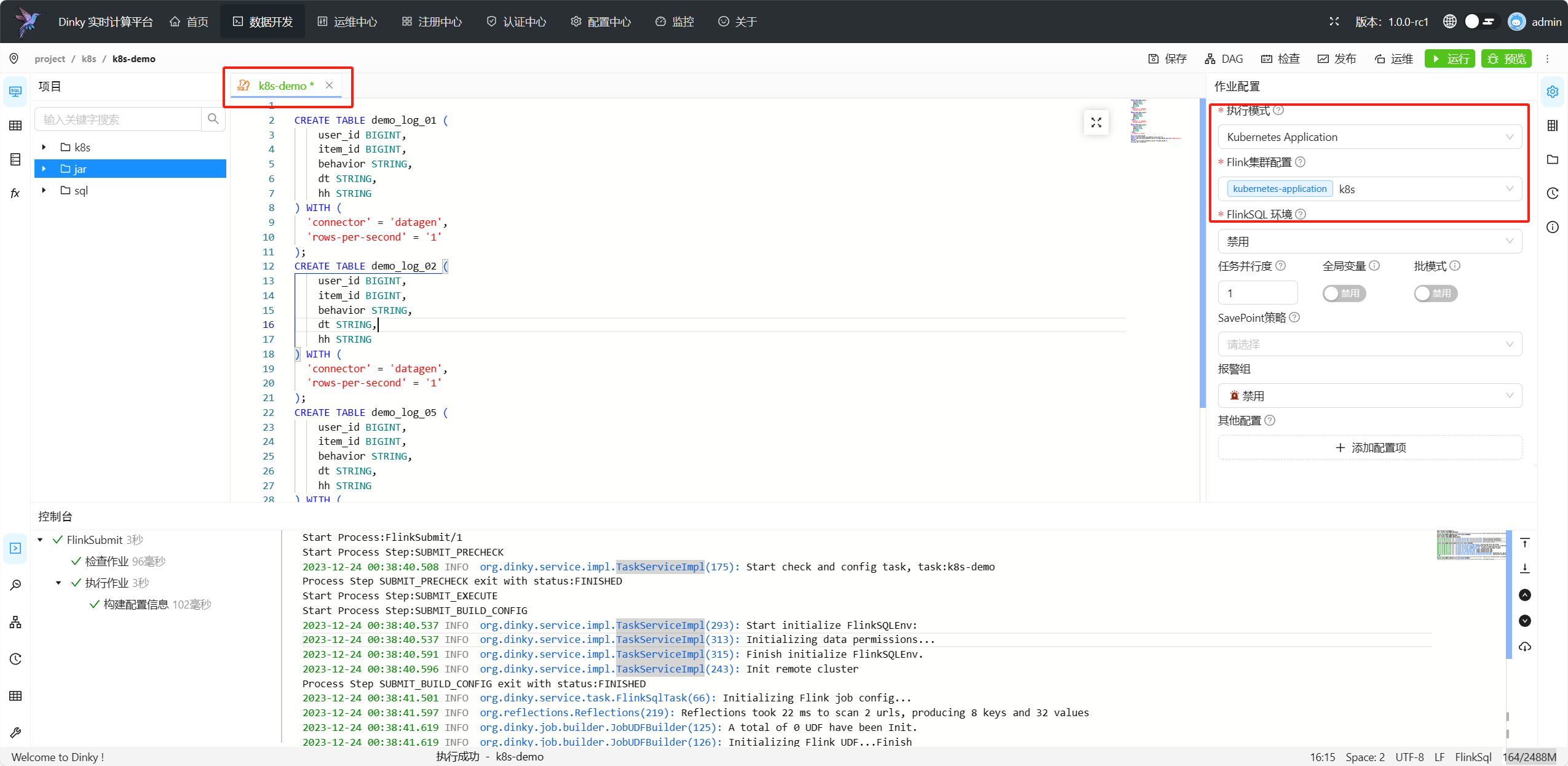

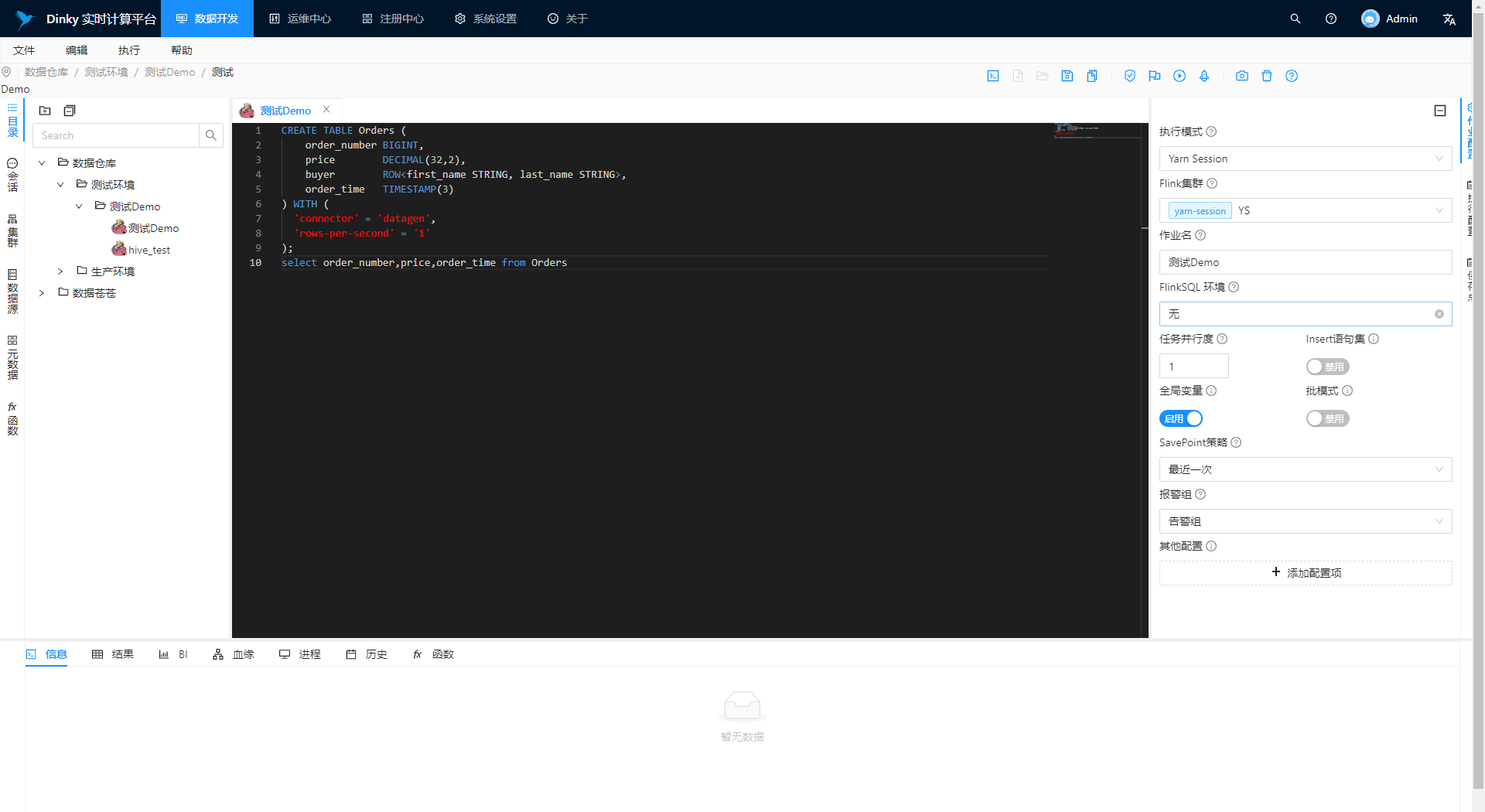

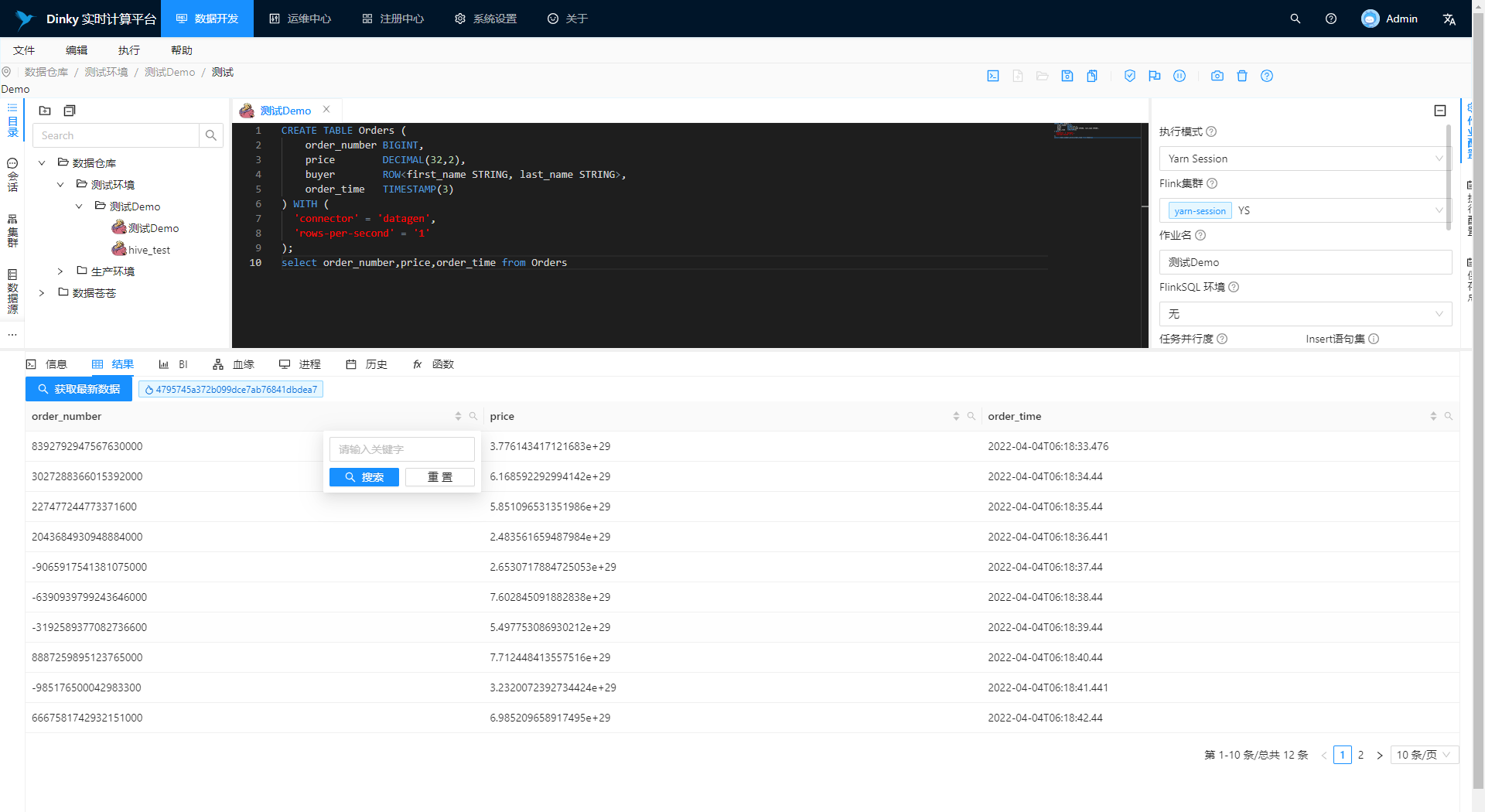

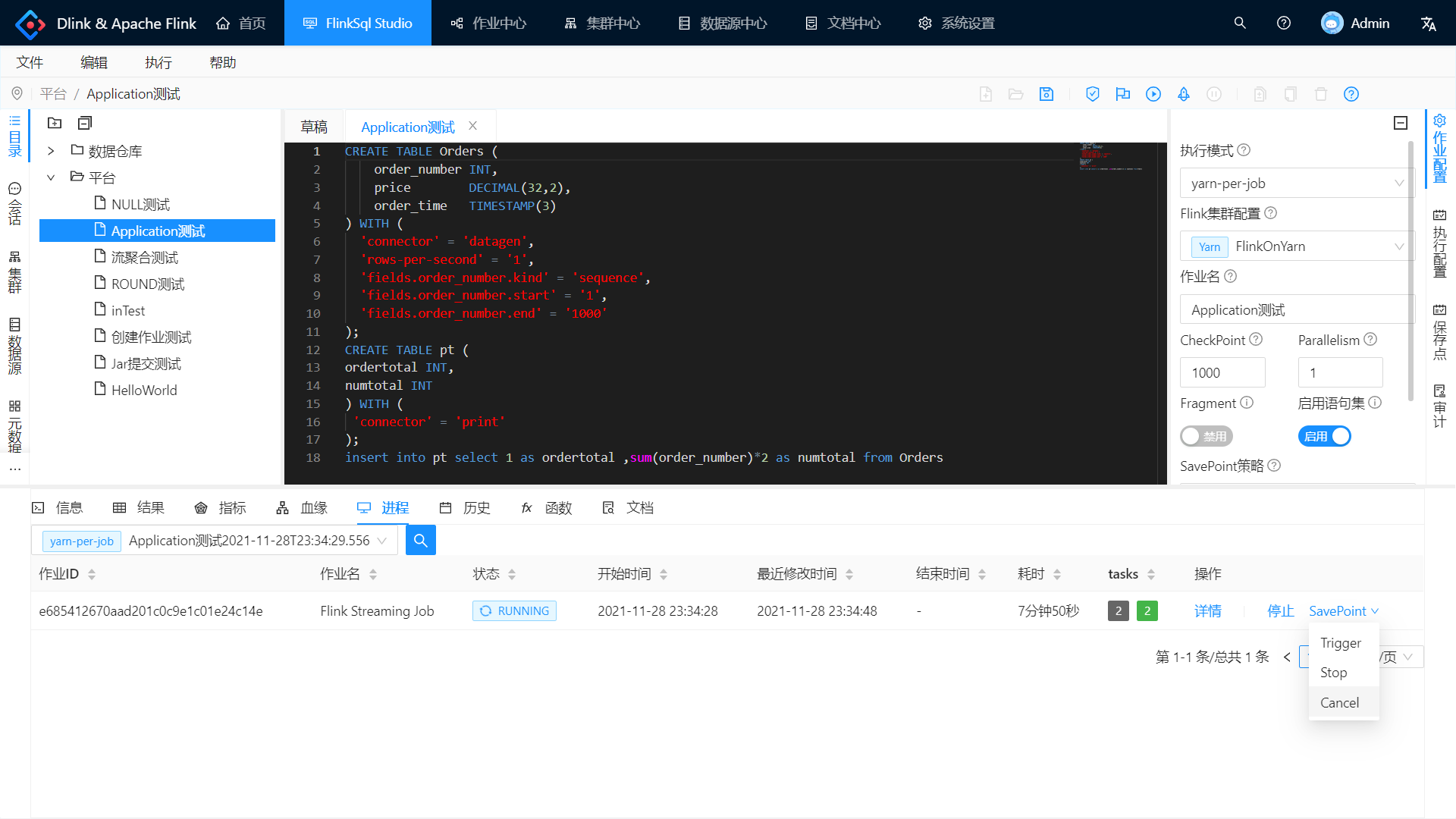

进入数据开发页面,新建一个flink sql任务,选择集群类型为`kubernetes application`,集群选择为我们刚刚配置的集群,点击提交即可

-## 提交 kubernetes session 任务

+

+

+

+## 提交 kubernetes session 任务

+

进入数据开发页面,新建一个flink sql任务,选择集群类型为`kubernetes session`,集群选择为我们刚刚配置的集群,点击提交即可

图片同上

\ No newline at end of file

diff --git a/docs/docs/developer_guide/local_debug.md b/docs/docs/developer_guide/local_debug.md

index 8d1bbd6a94..69d99a8ecb 100644

--- a/docs/docs/developer_guide/local_debug.md

+++ b/docs/docs/developer_guide/local_debug.md

@@ -90,7 +90,7 @@ npm run dev

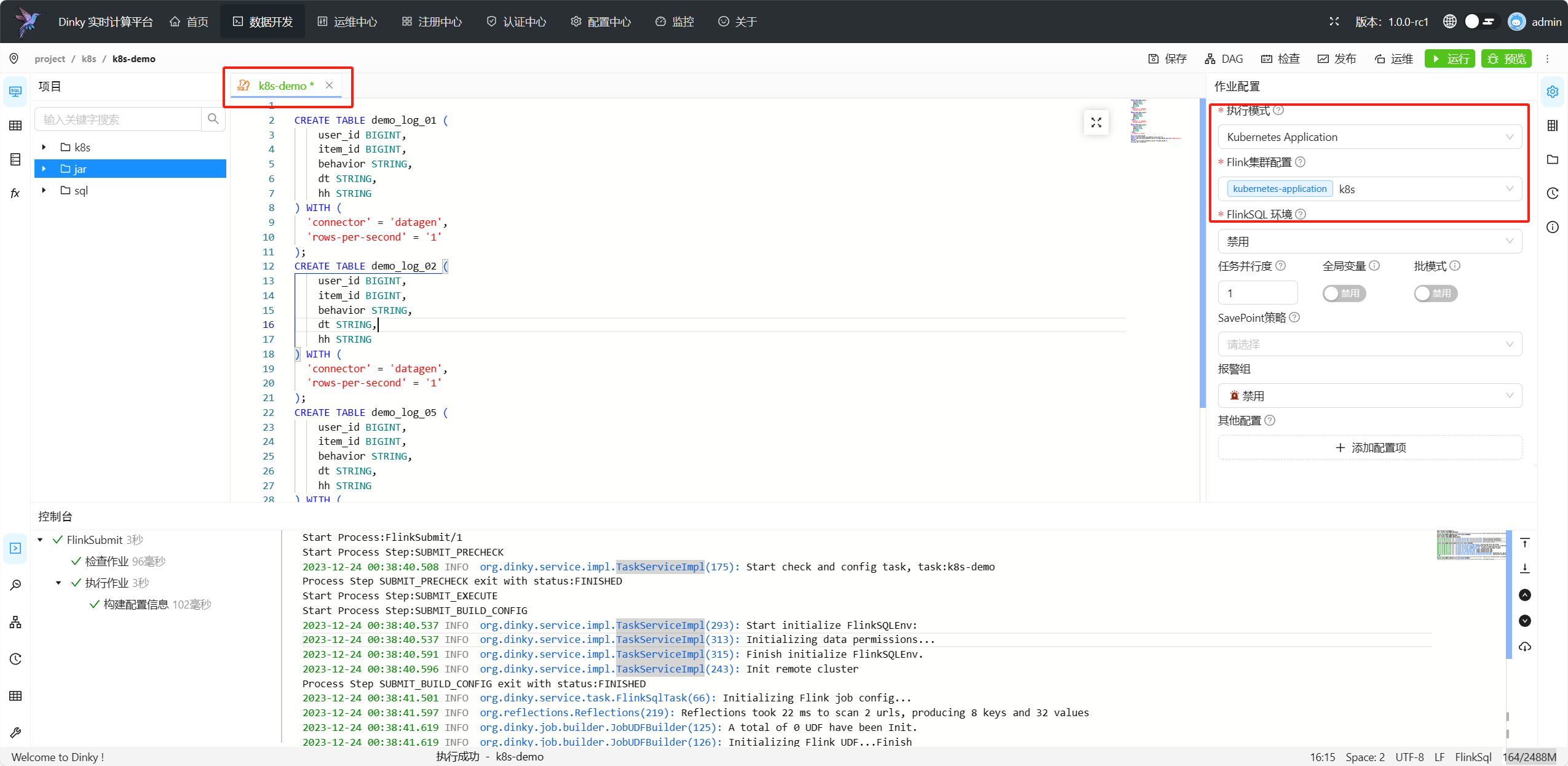

由于目前 Dinky 各个模块未发布到 Maven 中央仓库,所以需要先进行 Install 编译。从而在本地仓库中生成相应的依赖。

-如果你是第一次编译 Dinky,那么请勾选以下 Maven Profile,然后下图中的`生命周期 -> Install`进行编译。

+如果你是第一次编译 Dinky,那么请勾选以下 Maven Profile,然后双击下图中的`生命周期 -> Install`进行编译。

:::

diff --git a/docs/docs/extend/function_expansion/alert.md b/docs/docs/extend/function_expansion/alert.md

deleted file mode 100644

index abd034f218..0000000000

--- a/docs/docs/extend/function_expansion/alert.md

+++ /dev/null

@@ -1,169 +0,0 @@

----

-sidebar_position: 4

-id: alert

-title: 扩展报警插件

----

-

-

-

-

-Dinky 告警机制遵循 SPI,可随意扩展所需要的告警机制。如需扩展可在 dinky-alert 模块中进行可插拔式扩展。现已经支持的告警机制包括如下:

-

-- DingDingTalk

-- 企业微信: 同时支持**APP** 和 **WeChat 群聊** 方式

-- Email

-- 飞书

-

-Dinky 学习了 ``Apache Dolphinscheduler`` 的插件扩展机制,可以在 Dinky 中添加自定义的告警机制。

-

-## 准备工作

-- 本地开发环境搭建

- - 详见 [开发者本地调试手册](../../developer_guide/local_debug)

-

-## 后端开发

-- 在 **dinky-alert** 新建子模块 , 命名规则为 `dinky-alert-{报警类型}` 在子模块中实现相关告警机制

-- **代码层面** 根据告警场景自行实现报警逻辑

- - 注意事项:

- - 不可在父类的基础上修改代码,可以在子类中进行扩展 ,或者重写父类方法

- - 注意告警所使用到的常量需要继承**AlertBaseConstant** 其他差异的特殊常量在新建的模块中定义,参考其他告警类型代码

- - 扩展告警类型需要同时提交**测试用例**

-- 需要在新建的此模块的 **resource** 下 新建包 ``META-INF.services`` , 在此包中新建文件 ``org.dinky.alert.Alert`` 内容如下:

- - ``org.dinky.alert.{报警类型}.{报警类型Alert}`` 参考其他告警类型的此文件

-- 打包相关配置 修改如下:

- - 在 **dinky-core** 模块的 **pom.xml** 下 , 找到扩展告警相关的依赖 `放在一起方便管理` 并且新增如下内容:

- ```xml

-

- org.dinky

- 模块名称

- ${scope.runtime}

-

- ```

-

- - 在 **dinky-admin** 模块的 **pom.xml** 下 , 找到扩展告警相关的依赖 `放在一起方便管理` 并且新增如下内容:

- ```xml

-

- org.dinky

- 模块名称

- ${expand.scope}

-

- ```

-

-- 在 **dinky** 根下 **pom.xml** 中 ,新增如下内容:

- ```xml

-

- org.dinky

- 模块名称

- ${project.version}

-

- ```

-

-- 在 **dinky-assembly** 模块中 , 找到 ``package.xml`` 路径: **/dinky-assembly/src/main/assembly/package.xml** , 新增如下内容:

-```xml

-

- ${project.parent.basedir}/dinky-alert/模块名称/target

-

- lib

-

- 模块名称-${project.version}.jar

-

-

- ```

-

-

-----

-

-## 前端开发

-- **dinky-web** 为 Dinky 的前端模块

-- 扩展告警插件相关表单所在路径: `dinky-web/src/pages/RegistrationCenter/AlertManage/AlertInstance`

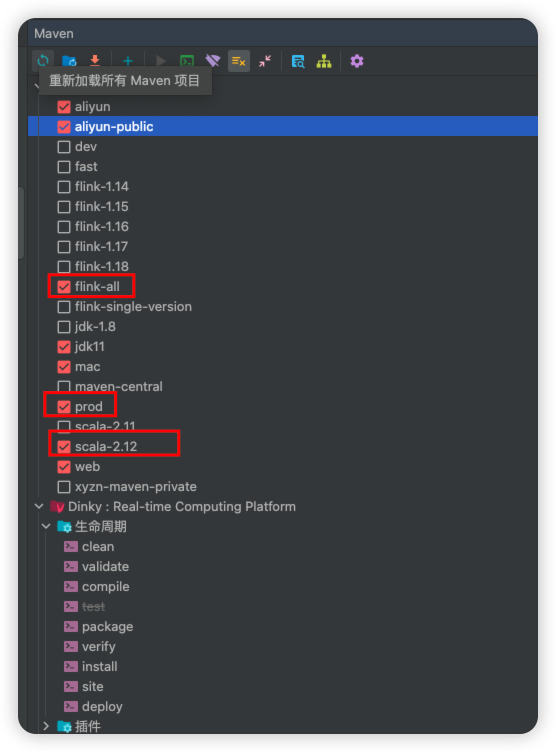

- - 修改 `dinky-web/src/pages/RegistrationCenter/AlertManage/AlertInstance/conf.ts`

-

- **ALERT_TYPE** 添加如下 eg:

- ``` typescript

- EMAIL:'Email',

- ```

- **ALERT_CONFIG_LIST** 添加如下 eg:

- ```typescript

- {

- type: ALERT_TYPE.EMAIL,

- }

- ```

- **注意:** 此处属性值需要与后端 `AlertTypeEnum` 声明的值保持一致

-

-如下图:

-

-

-

- 修改 `dinky-web/src/pages/RegistrationCenter/AlertManage/AlertInstance/icon.tsx` 的 **getAlertIcon** 中

-

- 添加如下 eg:

-```typescript

- case ALERT_TYPE.EMAIL:

- return ();

-```

-同时在下方定义 SVG : `如不定义将使用默认 SVG`

-

-svg 获取: [https://www.iconfont.cn](https://www.iconfont.cn)

-``` typescript

-export const EmailSvg = () => (

- {svg 相关代码}

-);

-```

-**注意:** svg 相关代码中需要将 **width** **height** 统一更换为 **width={svgSize} height={svgSize}**

-

-如下图:

-

-

-

-

- - 修改 `dinky-web/src/pages/RegistrationCenter/AlertManage/AlertInstance/components/AlertInstanceChooseForm.tsx`

-

- 追加如下 eg:

-```typescript

- {(values?.type == ALERT_TYPE.EMAIL || alertType == ALERT_TYPE.EMAIL)?

- {

- setAlertType(undefined);

- handleChooseModalVisible();

- }}

- modalVisible={values?.type == ALERT_TYPE.EMAIL || alertType == ALERT_TYPE.EMAIL}

- values={values}

- onSubmit={(value) => {

- onSubmit(value);

- }}

- onTest={(value) => {

- onTest(value);

- }}

- />:undefined

- }

-```

-其中需要修改的地方为

-- `EMAIL` 替换为上述 **dinky-web/src/pages/RegistrationCenter/AlertManage/AlertInstance/conf.ts** 中 **ALERT_TYPE** 的新增类型

-- `EmailForm` 为新建告警表单文件 **dinky-web/src/pages/RegistrationCenter/AlertManage/AlertInstance/components/EmailForm.tsx** 中的 **EmailForm** .

-

-如下图:

-

-

- - 需要新建表单文件 , 命名规则: ``{告警类型}Form``

- - 该文件中除 **表单属性** 外 , 其余可参照其他类型告警 , 建议复制其他类型告警的表单 , 修改其中的表单属性即可

- - 注意:

- - 部分表单属性保存为 Json 格式

- - 需要修改 如下的表单配置

-

-

- ```typescript

- // 找到如下相关代码:

- const [formVals, setFormVals] = useState>({

- id: props.values?.id,

- name: props.values?.name,

- type: ALERT_TYPE.EMAIL, // 此处需要修改为新增的告警类型

- params: props.values?.params,

- enabled: props.values?.enabled,

- });

-

-```

-

-

-----

-:::tip 说明

-至此 , 基于 Dinky 扩展告警完成 , 如您也有扩展需求 ,请参照如何 [[Issuse]](../../developer_guide/contribution/issue) 和如何[[提交 PR]](../../developer_guide/contribution/pull_request)

-:::

\ No newline at end of file

diff --git a/docs/docs/extend/function_expansion/completion.md b/docs/docs/extend/function_expansion/completion.md

deleted file mode 100644

index 652aab6d32..0000000000

--- a/docs/docs/extend/function_expansion/completion.md

+++ /dev/null

@@ -1,44 +0,0 @@

----

-sidebar_position: 5

-id: completion

-title: FlinkSQL 编辑器自动补全函数

----

-

-

-

-

-## FlinkSQL 编辑器自动补全函数

-

-Dlink-0.3.2 版本上线了一个非常实用的功能——自动补全。

-

-我们在使用 IDEA 等工具时,提示方法并补全、生成的功能大大提升了开发效率。而 Dlink 的目标便是让 FlinkSQL 更加丝滑,所以其提供了自定义的自动补全功能。对比传统的使用 `Java` 字符串来编写 FlinkSQL 的方式,Dlink 的优势是巨大。

-

-在文档中心,我们可以根据自己的需要扩展相应的自动补全规则,如 `UDF`、`Connector With` 等 FlinkSQL 片段,甚至可以扩展任意可以想象到内容,如注释、模板、配置、算法等。

-

-具体新增规则的示例请看下文描述。

-

-## set 语法来设置执行环境参数

-

-对于一个 FlinkSQL 的任务来说,除了 sql 口径,其任务配置也十分重要。所以 Dlink-0.3.2 版本中提供了 `sql-client` 的 `set` 语法,可以通过 `set` 关键字来指定任务的执行配置(如 “ `set table.exec.resource.default-parallelism=2;` ” ),其优先级要高于 Dlink 自身的任务配置(面板右侧)。

-

-那么长的参数一般人谁记得住?等等,别忘了 Dlink 的新功能自动补全~

-

-配置实现输入 `parallelism` 子字符串来自动补全 `table.exec.resource.default-parallelism=` 。

-

-在文档中心中添加一个规则,名称为 `parallelism`,填充值为 `table.exec.resource.default-parallelism=`,其他内容随意。

-

-保存之后,来到编辑器输入 `par` .

-

-选中要补全的规则后,编辑器中自动补全了 `table.exec.resource.default-parallelism=` 。

-

-至此,有些小伙伴发现,是不是可以直接定义 `pl2` 来自动生成 `set table.exec.resource.default-parallelism=2;` ?

-

-当然可以的。

-

-还有小伙伴问,可不可以定义 `pl` 生成 `set table.exec.resource.default-parallelism=;` 后,光标自动定位到 `=` 于 `;` 之间?

-

-这个也可以的,只需要定义 `pl` 填充值为 `set table.exec.resource.default-parallelism=${1:};` ,即可实现。

-

-所以说,只要能想象到的都可以定义,这样的 Dlink 你爱了吗?

-

-嘘,还有点小 bug 后续修复呢。如果有什么建议及问题请及时指出哦。

\ No newline at end of file

diff --git a/docs/docs/extend/function_expansion/connector.md b/docs/docs/extend/function_expansion/connector.md

deleted file mode 100644

index ab25f82d72..0000000000

--- a/docs/docs/extend/function_expansion/connector.md

+++ /dev/null

@@ -1,38 +0,0 @@

----

-sidebar_position: 2

-id: connector

-title: 扩展连接器

----

-

-

-

-

-## Flink Connector 介绍

-

-Flink做为实时计算引擎,支持非常丰富的上下游存储系统的 Connectors。并从这些上下系统读写数据并进行计算。对于这些 Connectors 在 Flink 中统一称之为数据源(Source) 端和 目标(Sink) 端。

-

-- 数据源(Source)指的是输入流计算系统的上游存储系统来源。在当前的 FlinkSQL 模式的作业中,数据源可以是消息队列 Kafka、数据库 MySQL 等。

-- 目标(Sink)指的是流计算系统输出处理结果的目的地。在当前的流计算 FlinkSQL 模式的作业中,目标端可以是消息队列 Kafka、数据库 MySQL、OLAP引擎 Doris、ClickHouse 等。

-

-Dinky 实时计算平台支持支持 Flink 1.13、Flink 1.14、Flink 1.15、Flink 1.16 五个版本,对应的版本支持所有开源的上下游存储系统具体Connector信息详见Flink开源社区:

-

-- [Flink1.13](https://nightlies.apache.org/flink/flink-docs-release-1.13/docs/connectors/table/overview/)

-- [Flink1.14](https://nightlies.apache.org/flink/flink-docs-release-1.14/docs/connectors/table/overview/)

-- [Flink1.15](https://nightlies.apache.org/flink/flink-docs-release-1.15/docs/connectors/table/overview/)

-- [Flink1.16](https://nightlies.apache.org/flink/flink-docs-release-1.16/docs/connectors/table/overview/)

-

-

-另外非 Flink 官网支持的 Connector 详见 github:

-

-- [Flink-CDC](https://github.com/ververica/flink-cdc-connectors/releases/)

-- [Hudi](https://github.com/apache/hudi/releases)

-- [Iceberg](https://github.com/apache/iceberg/releases)

-- [Doris](https://github.com/apache/incubator-doris-flink-connector/tags)

-- [Starrocks](https://github.com/StarRocks/flink-connector-starrocks/releases)

-- [ClickHouse](https://github.com/itinycheng/flink-connector-clickhouse)

-- [Pulsar](https://github.com/streamnative/pulsar-flink/releases)

-

-

-## 扩展 Connector

-

-将 Flink 集群上已扩展好的 Connector 直接放入 Dlink 的 lib 或者 plugins 下,然后重启即可。定制 Connector 过程同 Flink 官方一样。

diff --git a/docs/docs/extend/function_expansion/datasource.md b/docs/docs/extend/function_expansion/datasource.md

deleted file mode 100644

index 3e909022f6..0000000000

--- a/docs/docs/extend/function_expansion/datasource.md

+++ /dev/null

@@ -1,623 +0,0 @@

----

-sidebar_position: 3

-id: datasource

-title: 扩展数据源

----

-

-

-

-

- Dinky 数据源遵循 SPI,可随意扩展所需要的数据源。数据源扩展可在 dlink-metadata 模块中进行可插拔式扩展。现已经支持的数据源包括如下:

-

- - MySQL

- - Oracle

- - SQLServer

- - PostGreSQL

- - Phoenix

- - Doris(Starrocks)

- - ClickHouse

- - Hive ``需要的jar包: hive-jdbc-2.1.1.jar && hive-service-2.1.1.jar``

-

-使用以上数据源,详见注册中心[数据源管理](../../user_guide/register_center/datasource_manage),配置数据源连接

-:::tip 注意事项

- Dinky 不在对 Starorcks 进行额外扩展,Doris 和 Starorcks 底层并无差别,原则上只是功能区分。经社区测试验证,可采用 Doris 扩展连接 Starrocks。

-:::

-----

-

-## 准备工作

-- 本地开发环境搭建

- - 详见 [开发者本地调试手册](../../developer_guide/local_debug)

-

-## 后端开发

-- 本文以 Hive 数据源扩展为例

-- 在 **dlink-metadata** 模块中, 右键**新建子模块**, 命名规则: **dlink-metadata-{数据源名称}**

-- **代码层面**

- - 注意事项:

- - 不可在父类的基础上修改代码,可以在子类中进行扩展 ,或者重写父类方法

- - 扩展数据源需要同时提交**测试用例**

- - 在此模块的 **pom.xml** 中,添加所需依赖, 需要注意的是 : 数据源本身的 ``JDBC``的 jar 不要包含在打包中 , 而是后续部署时,添加在 ``plugins`` 下

- - 需要在此模块的 **resource** 下 新建包 ``META-INF.services`` , 在此包中新建文件 ``com.dlink.metadata.driver.Driver`` 内容如下:

- - ``com.dlink.metadata.driver.数据源类型Driver``

- 基础包:

-```bash

-顶层包名定义: com.dlink.metadata

- 子包含义:

- - constant: 常量定义 目前此模块中主要定义各种动态构建的执行 SQL

- - convert: 存放数据源的数据类型<->Java 类型的转换类 ps: 可以不定义 不定义使用 dlink-metadata-base 的默认转换 即调用父类的方法

- - driver: 存放数据源驱动类,获取元数据的主要类,类 extends AbstractJdbcDriver implements Driver

- - query : 存放解析获取元数据的主要类,类 extends AbstractDBQuery 方法不重写 默认使用父类

-```

-代码如下:

-

-HiveConstant

-```java

-public interface HiveConstant {

-

- /**

- * 查询所有database

- */

- String QUERY_ALL_DATABASE = " show databases";

- /**

- * 查询所有schema下的所有表

- */

- String QUERY_ALL_TABLES_BY_SCHEMA = "show tables";

- /**

- * 扩展信息Key

- */

- String DETAILED_TABLE_INFO = "Detailed Table Information";

- /**

- * 查询指定schema.table的扩展信息

- */

- String QUERY_TABLE_SCHEMA_EXTENED_INFOS = " describe extended `%s`.`%s`";

- /**

- * 查询指定schema.table的信息 列 列类型 列注释

- */

- String QUERY_TABLE_SCHEMA = " describe `%s`.`%s`";

- /**

- * 使用 DB

- */

- String USE_DB = "use `%s`";

- /**

- * 只查询指定schema.table的列名

- */

- String QUERY_TABLE_COLUMNS_ONLY = "show columns in `%s`.`%s`";

-}

-

-```

-

-HiveTypeConvert

-```java

-

-public class HiveTypeConvert implements ITypeConvert {

- // 主要是将获取到的数据类型转换为 Java 数据类型的映射 存储在 Column 中 , 此处根据扩展的数据源特性进行修改

- @Override

- public ColumnType convert(Column column) {

- if (Asserts.isNull(column)) {

- return ColumnType.STRING;

- }

- String t = column.getType().toLowerCase().trim();

- if (t.contains("char")) {

- return ColumnType.STRING;

- } else if (t.contains("boolean")) {

- if (column.isNullable()) {

- return ColumnType.JAVA_LANG_BOOLEAN;

- }

- return ColumnType.BOOLEAN;

- } else if (t.contains("tinyint")) {

- if (column.isNullable()) {

- return ColumnType.JAVA_LANG_BYTE;

- }

- return ColumnType.BYTE;

- } else if (t.contains("smallint")) {

- if (column.isNullable()) {

- return ColumnType.JAVA_LANG_SHORT;

- }

- return ColumnType.SHORT;

- } else if (t.contains("bigint")) {

- if (column.isNullable()) {

- return ColumnType.JAVA_LANG_LONG;

- }

- return ColumnType.LONG;

- } else if (t.contains("largeint")) {

- return ColumnType.STRING;

- } else if (t.contains("int")) {

- if (column.isNullable()) {

- return ColumnType.INTEGER;

- }

- return ColumnType.INT;

- } else if (t.contains("float")) {

- if (column.isNullable()) {

- return ColumnType.JAVA_LANG_FLOAT;

- }

- return ColumnType.FLOAT;

- } else if (t.contains("double")) {

- if (column.isNullable()) {

- return ColumnType.JAVA_LANG_DOUBLE;

- }

- return ColumnType.DOUBLE;

- } else if (t.contains("timestamp")) {

- return ColumnType.TIMESTAMP;

- } else if (t.contains("date")) {

- return ColumnType.STRING;

- } else if (t.contains("datetime")) {

- return ColumnType.STRING;

- } else if (t.contains("decimal")) {

- return ColumnType.DECIMAL;

- } else if (t.contains("time")) {

- return ColumnType.DOUBLE;

- }

- return ColumnType.STRING;

- }

-

- // 转换为 DB 的数据类型

- @Override

- public String convertToDB(ColumnType columnType) {

- switch (columnType) {

- case STRING:

- return "varchar";

- case BOOLEAN:

- case JAVA_LANG_BOOLEAN:

- return "boolean";

- case BYTE:

- case JAVA_LANG_BYTE:

- return "tinyint";

- case SHORT:

- case JAVA_LANG_SHORT:

- return "smallint";

- case LONG:

- case JAVA_LANG_LONG:

- return "bigint";

- case FLOAT:

- case JAVA_LANG_FLOAT:

- return "float";

- case DOUBLE:

- case JAVA_LANG_DOUBLE:

- return "double";

- case DECIMAL:

- return "decimal";

- case INT:

- case INTEGER:

- return "int";

- case TIMESTAMP:

- return "timestamp";

- default:

- return "varchar";

- }

- }

-}

-

-

-```

-

-

-HiveDriver

-```java

-

-public class HiveDriver extends AbstractJdbcDriver implements Driver {

- // 获取表的信息

- @Override

- public Table getTable(String schemaName, String tableName) {

- List tables = listTables(schemaName);

- Table table = null;

- for (Table item : tables) {

- if (Asserts.isEquals(item.getName(), tableName)) {

- table = item;

- break;

- }

- }

- if (Asserts.isNotNull(table)) {

- table.setColumns(listColumns(schemaName, table.getName()));

- }

- return table;

- }

-

-

-// 根据库名称获取表的信息

- @Override

- public List listTables(String schemaName) {

- List tableList = new ArrayList<>();

- PreparedStatement preparedStatement = null;

- ResultSet results = null;

- IDBQuery dbQuery = getDBQuery();

- String sql = dbQuery.tablesSql(schemaName);

- try {

- //此步骤是为了切换数据库 与其他数据源有所区别

- execute(String.format(HiveConstant.USE_DB, schemaName));

- preparedStatement = conn.prepareStatement(sql);

- results = preparedStatement.executeQuery();

- ResultSetMetaData metaData = results.getMetaData();

- List columnList = new ArrayList<>();

- for (int i = 1; i <= metaData.getColumnCount(); i++) {

- columnList.add(metaData.getColumnLabel(i));

- }

- while (results.next()) {

- String tableName = results.getString(dbQuery.tableName());

- if (Asserts.isNotNullString(tableName)) {

- Table tableInfo = new Table();

- tableInfo.setName(tableName);

- if (columnList.contains(dbQuery.tableComment())) {

- tableInfo.setComment(results.getString(dbQuery.tableComment()));

- }

- tableInfo.setSchema(schemaName);

- if (columnList.contains(dbQuery.tableType())) {

- tableInfo.setType(results.getString(dbQuery.tableType()));

- }

- if (columnList.contains(dbQuery.catalogName())) {

- tableInfo.setCatalog(results.getString(dbQuery.catalogName()));

- }

- if (columnList.contains(dbQuery.engine())) {

- tableInfo.setEngine(results.getString(dbQuery.engine()));

- }

- tableList.add(tableInfo);

- }

- }

- } catch (Exception e) {

- e.printStackTrace();

- } finally {

- close(preparedStatement, results);

- }

- return tableList;

- }

-

- //获取所有数据库 和 库下所有表

- @Override

- public List getSchemasAndTables() {

- return listSchemas();

- }

-

- //获取所有数据库

- @Override

- public List listSchemas() {

-

- List schemas = new ArrayList<>();

- PreparedStatement preparedStatement = null;

- ResultSet results = null;

- String schemasSql = getDBQuery().schemaAllSql();

- try {

- preparedStatement = conn.prepareStatement(schemasSql);

- results = preparedStatement.executeQuery();

- while (results.next()) {

- String schemaName = results.getString(getDBQuery().schemaName());

- if (Asserts.isNotNullString(schemaName)) {

- Schema schema = new Schema(schemaName);

- if (execute(String.format(HiveConstant.USE_DB, schemaName))) {

- // 获取库下的所有表 存储到schema中

- schema.setTables(listTables(schema.getName()));

- }

- schemas.add(schema);

- }

- }

- } catch (Exception e) {

- e.printStackTrace();

- } finally {

- close(preparedStatement, results);

- }

- return schemas;

- }

-

- // 根据库名表名获取表的列信息

- @Override

- public List listColumns(String schemaName, String tableName) {

- List columns = new ArrayList<>();

- PreparedStatement preparedStatement = null;

- ResultSet results = null;

- IDBQuery dbQuery = getDBQuery();

- String tableFieldsSql = dbQuery.columnsSql(schemaName, tableName);

- try {

- preparedStatement = conn.prepareStatement(tableFieldsSql);

- results = preparedStatement.executeQuery();

- ResultSetMetaData metaData = results.getMetaData();

- List columnList = new ArrayList<>();

- for (int i = 1; i <= metaData.getColumnCount(); i++) {

- columnList.add(metaData.getColumnLabel(i));

- }

- Integer positionId = 1;

- while (results.next()) {

- Column field = new Column();

- if (StringUtils.isEmpty(results.getString(dbQuery.columnName()))) {

- break;

- } else {

- if (columnList.contains(dbQuery.columnName())) {

- String columnName = results.getString(dbQuery.columnName());

- field.setName(columnName);

- }

- if (columnList.contains(dbQuery.columnType())) {

- field.setType(results.getString(dbQuery.columnType()));

- }

- if (columnList.contains(dbQuery.columnComment()) && Asserts.isNotNull(results.getString(dbQuery.columnComment()))) {

- String columnComment = results.getString(dbQuery.columnComment()).replaceAll("\"|'", "");

- field.setComment(columnComment);

- }

- field.setPosition(positionId++);

- field.setJavaType(getTypeConvert().convert(field));

- }

- columns.add(field);

- }

- } catch (SQLException e) {

- e.printStackTrace();

- } finally {

- close(preparedStatement, results);

- }

- return columns;

- }

-

- //获取建表的SQL

- @Override

- public String getCreateTableSql(Table table) {

- StringBuilder createTable = new StringBuilder();

- PreparedStatement preparedStatement = null;

- ResultSet results = null;

- String createTableSql = getDBQuery().createTableSql(table.getSchema(), table.getName());

- try {

- preparedStatement = conn.prepareStatement(createTableSql);

- results = preparedStatement.executeQuery();

- while (results.next()) {

- createTable.append(results.getString(getDBQuery().createTableName())).append("\n");

- }

- } catch (Exception e) {

- e.printStackTrace();

- } finally {

- close(preparedStatement, results);

- }

- return createTable.toString();

- }

-

- @Override

- public int executeUpdate(String sql) throws Exception {

- Asserts.checkNullString(sql, "Sql 语句为空");

- String querySQL = sql.trim().replaceAll(";$", "");

- int res = 0;

- try (Statement statement = conn.createStatement()) {

- res = statement.executeUpdate(querySQL);

- }

- return res;

- }

-

- @Override

- public JdbcSelectResult query(String sql, Integer limit) {

- if (Asserts.isNull(limit)) {

- limit = 100;

- }

- JdbcSelectResult result = new JdbcSelectResult();

- List> datas = new ArrayList<>();

- List columns = new ArrayList<>();

- List columnNameList = new ArrayList<>();

- PreparedStatement preparedStatement = null;

- ResultSet results = null;

- int count = 0;

- try {

- String querySQL = sql.trim().replaceAll(";$", "");

- preparedStatement = conn.prepareStatement(querySQL);

- results = preparedStatement.executeQuery();

- if (Asserts.isNull(results)) {

- result.setSuccess(true);

- close(preparedStatement, results);

- return result;

- }

- ResultSetMetaData metaData = results.getMetaData();

- for (int i = 1; i <= metaData.getColumnCount(); i++) {

- columnNameList.add(metaData.getColumnLabel(i));

- Column column = new Column();

- column.setName(metaData.getColumnLabel(i));

- column.setType(metaData.getColumnTypeName(i));

- column.setAutoIncrement(metaData.isAutoIncrement(i));

- column.setNullable(metaData.isNullable(i) == 0 ? false : true);

- column.setJavaType(getTypeConvert().convert(column));

- columns.add(column);

- }

- result.setColumns(columnNameList);

- while (results.next()) {

- LinkedHashMap data = new LinkedHashMap<>();

- for (int i = 0; i < columns.size(); i++) {

- data.put(columns.get(i).getName(), getTypeConvert().convertValue(results, columns.get(i).getName(), columns.get(i).getType()));

- }

- datas.add(data);

- count++;

- if (count >= limit) {

- break;

- }

- }

- result.setSuccess(true);

- } catch (Exception e) {

- result.setError(LogUtil.getError(e));

- result.setSuccess(false);

- } finally {

- close(preparedStatement, results);

- result.setRowData(datas);

- return result;

- } }

-

- @Override

- public IDBQuery getDBQuery() {

- return new HiveQuery();

- }

-

- @Override

- public ITypeConvert getTypeConvert() {

- return new HiveTypeConvert();

- }

-

- // 获取驱动类

- @Override

- String getDriverClass() {

- return "org.apache.hive.jdbc.HiveDriver";

- }

-

- // 改数据源表的类型 此处必须

- @Override

- public String getType() {

- return "Hive";

- }