10W字高质量java并发系列详解教程-附PDF下载

[toc]

并发是java高级程序员必须要深入研究的话题,从Synchronized到Lock,JDK本身提供了很多优秀的并发类和锁控制器,灵活使用这些类,可以写出优秀的并发程序,而这些类基本上都是在java.util.concurrent包中的,本文将会从具体的例子出发,一步一步带领大家进入java高质量并发的世界。

本文PDF下载链接concurrent-all-in-one.pdf

本文的例子可以参考https://github.com/ddean2009/learn-java-concurrency/

java.util.concurrent包提供了很多有用的类,方便我们进行并发程序的开发。本文将会做一个总体的简单介绍。

java.util.concurrent包含了很多内容, 本文将会挑选其中常用的一些类来进行大概的说明:

- Executor

- ExecutorService

- ScheduledExecutorService

- Future

- CountDownLatch

- CyclicBarrier

- Semaphore

- ThreadFactory

Executor是一个接口,它定义了一个execute方法,这个方法接收一个Runnable,并在其中调用Runnable的run方法。

我们看一个Executor的实现:

public class Invoker implements Executor {

@Override

public void execute(Runnable r) {

r.run();

}

}现在我们可以直接调用该类中的方法:

public void execute() {

Executor executor = new Invoker();

executor.execute( () -> {

log.info("{}", Thread.currentThread().toString());

});

}注意,Executor并不一定要求执行的任务是异步的。

如果我们真正的需要使用多线程的话,那么就需要用到ExecutorService了。

ExecutorService管理了一个内存的队列,并定时提交可用的线程。

我们首先定义一个Runnable类:

public class Task implements Runnable {

@Override

public void run() {

// task details

}

}我们可以通过Executors来方便的创建ExecutorService:

ExecutorService executor = Executors.newFixedThreadPool(10);上面创建了一个ThreadPool, 我们也可以创建单线程的ExecutorService:

ExecutorService executor =Executors.newSingleThreadExecutor();我们这样提交task:

public void execute() {

executor.submit(new Task());

}因为ExecutorService维持了一个队列,所以它不会自动关闭, 我们需要调用executor.shutdown() 或者executor.shutdownNow()来关闭它。

如果想要判断ExecutorService中的线程在收到shutdown请求后是否全部执行完毕,可以调用如下的方法:

try {

executor.awaitTermination( 5l, TimeUnit.SECONDS );

} catch (InterruptedException e) {

e.printStackTrace();

}ScheduledExecutorService和ExecutorService很类似,但是它可以周期性的执行任务。

我们这样创建ScheduledExecutorService:

ScheduledExecutorService executorService

= Executors.newSingleThreadScheduledExecutor();executorService的schedule方法,可以传入Runnable也可以传入Callable:

Future<String> future = executorService.schedule(() -> {

// ...

return "Hello world";

}, 1, TimeUnit.SECONDS);

ScheduledFuture<?> scheduledFuture = executorService.schedule(() -> {

// ...

}, 1, TimeUnit.SECONDS);还有两个比较相近的方法:

scheduleAtFixedRate( Runnable command, long initialDelay, long period, TimeUnit unit )

scheduleWithFixedDelay( Runnable command, long initialDelay, long delay, TimeUnit unit ) 两者的区别是前者的period是以任务开始时间来计算的,后者是以任务结束时间来计算。

Future用来获取异步执行的结果。可以调用cancel(boolean mayInterruptIfRunning) 方法来取消线程的执行。

我们看下怎么得到一个Future对象:

public void invoke() {

ExecutorService executorService = Executors.newFixedThreadPool(10);

Future<String> future = executorService.submit(() -> {

// ...

Thread.sleep(10000l);

return "Hello world";

});

}我们看下怎么获取Future的结果:

if (future.isDone() && !future.isCancelled()) {

try {

str = future.get();

} catch (InterruptedException | ExecutionException e) {

e.printStackTrace();

}

}future还可以接受一个时间参数,超过指定的时间,将会报TimeoutException。

try {

future.get(10, TimeUnit.SECONDS);

} catch (InterruptedException | ExecutionException | TimeoutException e) {

e.printStackTrace();

}CountDownLatch是一个并发中很有用的类,CountDownLatch会初始化一个counter,通过这个counter变量,来控制资源的访问。我们会在后面的文章详细介绍。

CyclicBarrier和CountDownLatch很类似。CyclicBarrier主要用于多个线程互相等待的情况,可以通过调用await() 方法等待,知道达到要等的数量。

public class Task implements Runnable {

private CyclicBarrier barrier;

public Task(CyclicBarrier barrier) {

this.barrier = barrier;

}

@Override

public void run() {

try {

LOG.info(Thread.currentThread().getName() +

" is waiting");

barrier.await();

LOG.info(Thread.currentThread().getName() +

" is released");

} catch (InterruptedException | BrokenBarrierException e) {

e.printStackTrace();

}

}

}public void start() {

CyclicBarrier cyclicBarrier = new CyclicBarrier(3, () -> {

// ...

LOG.info("All previous tasks are completed");

});

Thread t1 = new Thread(new Task(cyclicBarrier), "T1");

Thread t2 = new Thread(new Task(cyclicBarrier), "T2");

Thread t3 = new Thread(new Task(cyclicBarrier), "T3");

if (!cyclicBarrier.isBroken()) {

t1.start();

t2.start();

t3.start();

}

}Semaphore包含了一定数量的许可证,通过获取许可证,从而获得对资源的访问权限。通过 tryAcquire()来获取许可,如果获取成功,许可证的数量将会减少。

一旦线程release()许可,许可的数量将会增加。

我们看下怎么使用:

static Semaphore semaphore = new Semaphore(10);

public void execute() throws InterruptedException {

LOG.info("Available permit : " + semaphore.availablePermits());

LOG.info("Number of threads waiting to acquire: " +

semaphore.getQueueLength());

if (semaphore.tryAcquire()) {

try {

// ...

}

finally {

semaphore.release();

}

}

}ThreadFactory可以很方便的用来创建线程:

public class ThreadFactoryUsage implements ThreadFactory {

private int threadId;

private String name;

public ThreadFactoryUsage(String name) {

threadId = 1;

this.name = name;

}

@Override

public Thread newThread(Runnable r) {

Thread t = new Thread(r, name + "-Thread_" + threadId);

log.info("created new thread with id : " + threadId +

" and name : " + t.getName());

threadId++;

return t;

}

}如果在多线程的环境中,我们经常会遇到资源竞争的情况,比如多个线程要去同时修改同一个共享变量,这时候,就需要对资源的访问方法进行一定的处理,保证同一时间只有一个线程访问。

java提供了synchronized关键字,方便我们实现上述操作。

我们举个例子,我们创建一个类,提供了一个setSum的方法:

public class SynchronizedMethods {

private int sum = 0;

public void calculate() {

setSum(getSum() + 1);

}

}如果我们在多线程的环境中调用这个calculate方法:

@Test

public void givenMultiThread_whenNonSyncMethod() throws InterruptedException {

ExecutorService service = Executors.newFixedThreadPool(3);

SynchronizedMethods summation = new SynchronizedMethods();

IntStream.range(0, 1000)

.forEach(count -> service.submit(summation::calculate));

service.shutdown();

service.awaitTermination(1000, TimeUnit.MILLISECONDS);

assertEquals(1000, summation.getSum());

}按照上面的方法,我们预计要返回1000, 但是实际上基本不可能得到1000这个值,因为在多线程环境中,对同一个资源进行同时操作带来的不利影响。

那我们怎么才能够建线程安全的环境呢?

java提供了多种线程安全的方法,本文主要讲解Synchronized关键词,Synchronized关键词可以有很多种形式:

- Instance methods

- Static methods

- Code blocks

当我们使用synchronized时,java会在相应的对象上加锁,从而在同一个对象等待锁的方法都必须顺序执行,从而保证了线程的安全。

Synchronized关键词可以放在实例方法的前面:

public synchronized void synchronisedCalculate() {

setSum(getSum() + 1);

}看下调用结果:

@Test

public void givenMultiThread_whenMethodSync() {

ExecutorService service = Executors.newFixedThreadPool(3);

SynchronizedMethods method = new SynchronizedMethods();

IntStream.range(0, 1000)

.forEach(count -> service.submit(method::synchronisedCalculate));

service.awaitTermination(1000, TimeUnit.MILLISECONDS);

assertEquals(1000, method.getSum());

}这里synchronized将会锁住该方法的实例对象,多个线程中只有获得该实例对象锁的线程才能够执行。

Synchronized关键词也可以用在static方法前面:

public static synchronized void syncStaticCalculate() {

staticSum = staticSum + 1;

}Synchronized放在static方法前面和实例方法前面锁住的对象不同。放在static方法前面锁住的对象是这个Class本身,因为一个Class在JVM中只会存在一个,所以不管有多少该Class的实例,在同一时刻只会有一个线程可以执行该放方法。

@Test

public void givenMultiThread_whenStaticSyncMethod() throws InterruptedException {

ExecutorService service = Executors.newCachedThreadPool();

IntStream.range(0, 1000)

.forEach(count ->

service.submit(SynchronizedMethods::syncStaticCalculate));

service.shutdown();

service.awaitTermination(100, TimeUnit.MILLISECONDS);

assertEquals(1000, SynchronizedMethods.staticSum);

}有时候,我们可能不需要Synchronize整个方法,而是同步其中的一部分,这时候,我们可以使用Synchronized Blocks:

public void performSynchronizedTask() {

synchronized (this) {

setSum(getSum() + 1);

}

}我们看下怎么测试:

@Test

public void givenMultiThread_whenBlockSync() throws InterruptedException {

ExecutorService service = Executors.newFixedThreadPool(3);

SynchronizedMethods synchronizedBlocks = new SynchronizedMethods();

IntStream.range(0, 1000)

.forEach(count ->

service.submit(synchronizedBlocks::performSynchronizedTask));

service.shutdown();

service.awaitTermination(100, TimeUnit.MILLISECONDS);

assertEquals(1000, synchronizedBlocks.getSum());

}上面我们同步的是实例,如果在静态方法中,我们也可以同步class:

public static void performStaticSyncTask(){

synchronized (SynchronizedMethods.class) {

staticSum = staticSum + 1;

}

}我们看下怎么测试:

@Test

public void givenMultiThread_whenStaticSyncBlock() throws InterruptedException {

ExecutorService service = Executors.newCachedThreadPool();

IntStream.range(0, 1000)

.forEach(count ->

service.submit(SynchronizedMethods::performStaticSyncTask));

service.shutdown();

service.awaitTermination(100, TimeUnit.MILLISECONDS);

assertEquals(1000, SynchronizedMethods.staticSum);

}在本文中,我们会介绍java中的一个关键字volatile。 volatile的中文意思是易挥发的,不稳定的。那么在java中使用是什么意思呢?

我们知道,在java中,每个线程都会有个自己的内存空间,我们称之为working memory。这个空间会缓存一些变量的信息,从而提升程序的性能。当执行完某个操作之后,thread会将更新后的变量更新到主缓存中,以供其他线程读写。

因为变量存在working memory和main memory两个地方,那么就有可能出现不一致的情况。 那么我们就可以使用Volatile关键字来强制将变量直接写到main memory,从而保证了不同线程读写到的是同一个变量。

那么我们什么时候使用volatile呢?当一个线程需要立刻读取到另外一个线程修改的变量值的时候,我们就可以使用volatile。我们来举个例子:

public class VolatileWithoutUsage {

private int count = 0;

public void incrementCount() {

count++;

}

public int getCount() {

return count;

}

}这个类定义了一个incrementCount()方法,会去更新count值,我们接下来在多线程环境中去测试这个方法:

@Test

public void testWithoutVolatile() throws InterruptedException {

ExecutorService service= Executors.newFixedThreadPool(3);

VolatileWithoutUsage volatileWithoutUsage=new VolatileWithoutUsage();

IntStream.range(0,1000).forEach(count ->service.submit(volatileWithoutUsage::incrementCount) );

service.shutdown();

service.awaitTermination(1000, TimeUnit.MILLISECONDS);

assertEquals(1000,volatileWithoutUsage.getCount() );

}运行一下,我们会发现结果是不等于1000的。

java.lang.AssertionError:

Expected :1000

Actual :999这是因为多线程去更新同一个变量,我们在上篇文章也提到了,这种情况可以通过加Synchronized关键字来解决。

那么是不是我们加上Volatile关键字后就可以解决这个问题了呢?

public class VolatileFalseUsage {

private volatile int count = 0;

public void incrementCount() {

count++;

}

public int getCount() {

return count;

}

}上面的类中,我们加上了关键字Volatile,我们再测试一下:

@Test

public void testWithVolatileFalseUsage() throws InterruptedException {

ExecutorService service= Executors.newFixedThreadPool(3);

VolatileFalseUsage volatileFalseUsage=new VolatileFalseUsage();

IntStream.range(0,1000).forEach(count ->service.submit(volatileFalseUsage::incrementCount) );

service.shutdown();

service.awaitTermination(5000, TimeUnit.MILLISECONDS);

assertEquals(1000,volatileFalseUsage.getCount() );

}运行一下,我们会发现结果还是错误的:

java.lang.AssertionError:

Expected :1000

Actual :992

~~

为什么呢? 我们先来看下count++的操作,count++可以分解为三步操作,1. 读取count的值,2.给count加1, 3.将count写回内存。添加Volatile关键词只能够保证count的变化立马可见,而不能保证1,2,3这三个步骤的总体原子性。 要实现总体的原子性还是需要用到类似Synchronized的关键字。

下面看下正确的用法:

~~~java

public class VolatileTrueUsage {

private volatile int count = 0;

public void setCount(int number) {

count=number;

}

public int getCount() {

return count;

}

} @Test

public void testWithVolatileTrueUsage() throws InterruptedException {

VolatileTrueUsage volatileTrueUsage=new VolatileTrueUsage();

Thread threadA = new Thread(()->volatileTrueUsage.setCount(10));

threadA.start();

Thread.sleep(100);

Thread reader = new Thread(() -> {

int valueReadByThread = volatileTrueUsage.getCount();

assertEquals(10, valueReadByThread);

});

reader.start();

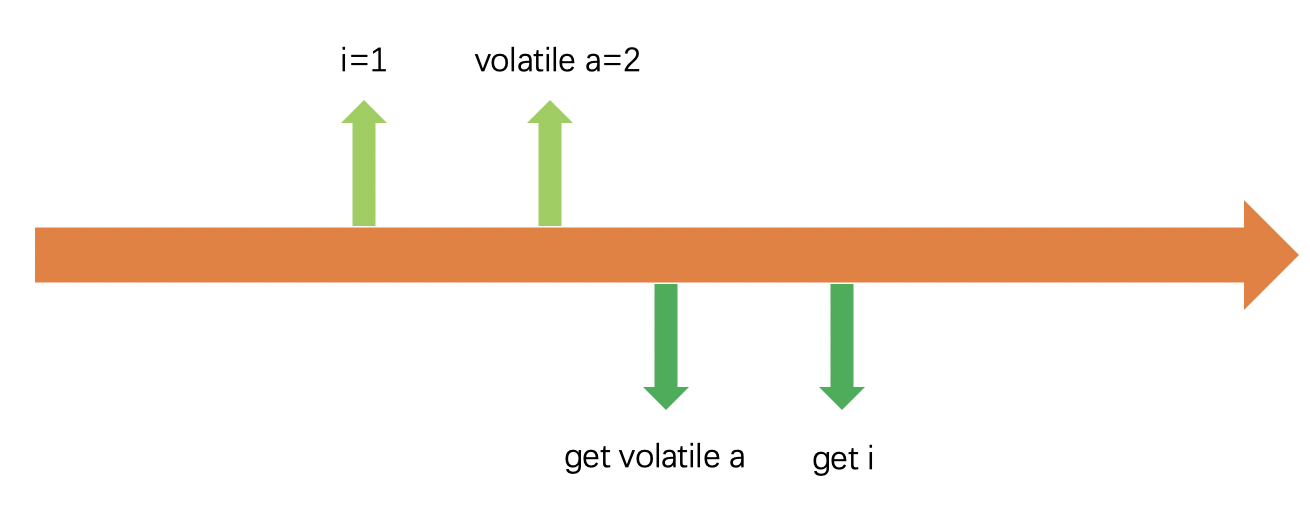

}从java5之后,volatile提供了一个Happens-Before的功能。Happens-Before 是指当volatile进行写回主内存的操作时,会将之前的非volatile的操作一并写回主内存。

public class VolatileHappenBeforeUsage {

int a = 0;

volatile boolean flag = false;

public void writer() {

a = 1; // 1 线程A修改共享变量

flag = true; // 2 线程A写volatile变量

}

}上面的例子中,a是一个非volatile变量,flag是一个volatile变量,但是由于happens-before的特性,a 将会表现的和volatile一样。

在本篇文章中,我们将会讨论一下java中wait()和sleep()方法的区别。并讨论一下怎么使用这两个方法。

wait() 是Object中定义的native方法:

public final native void wait(long timeout) throws InterruptedException;所以每一个类的实例都可以调用这个方法。wait()只能在synchronized block中调用。它会释放synchronized时加在object上的锁。

sleep()是定义Thread中的native静态类方法:

public static native void sleep(long millis) throws InterruptedException;所以Thread.sleep()可以在任何情况下调用。Thread.sleep()将会暂停当前线程,并且不会释放任何锁资源。

我们先看一下一个简单的wait使用:

@Slf4j

public class WaitUsage {

private static Object LOCK = new Object();

public static void WaitExample() throws InterruptedException {

synchronized (LOCK) {

LOCK.wait(1000);

log.info("Object '" + LOCK + "' is woken after" +

" waiting for 1 second");

}

}

}再看一下sleep的使用:

@Slf4j

public class SleepUsage {

public static void sleepExample() throws InterruptedException {

Thread.sleep(1000);

log.info(

"Thread '" + Thread.currentThread().getName() +

"' is woken after sleeping for 1 second");

}

}sleep()方法自带sleep时间,时间过后,Thread会自动被唤醒。 或者可以通过调用interrupt()方法来中断。

相比而言wait的唤醒会比较复杂,我们需要调用notify() 和 notifyAll()方法来唤醒等待在特定wait object上的线程。

notify()会根据线程调度的机制选择一个线程来唤醒,而notifyAll()会唤醒所有等待的线程,由这些线程重新争夺资源锁。

wait,notity通常用在生产者和消费者情形,我们看下怎么使用:

@Slf4j

public class WaitNotifyUsage {

private int count =0;

public void produceMessage() throws InterruptedException {

while(true) {

synchronized (this) {

while (count == 5) {

log.info("count == 5 , wait ....");

wait();

}

count++;

log.info("produce count {}", count);

notify();

}

}

}

public void consumeMessage() throws InterruptedException {

while (true) {

synchronized (this) {

while (count == 0) {

log.info("count == 0, wait ...");

wait();

}

log.info("consume count {}", count);

count--;

notify();

}

}

}

}看下怎么调用:

@Test

public void testWaitNotifyUsage() throws InterruptedException{

WaitNotifyUsage waitNotifyUsage=new WaitNotifyUsage();

ExecutorService executorService=Executors.newFixedThreadPool(4);

executorService.submit(()-> {

try {

waitNotifyUsage.produceMessage();

} catch (InterruptedException e) {

e.printStackTrace();

}

});

executorService.submit(()-> {

try {

waitNotifyUsage.consumeMessage();

} catch (InterruptedException e) {

e.printStackTrace();

}

});

Thread.sleep(50000);

}Future是java 1.5引入的一个interface,可以方便的用于异步结果的获取。 本文将会通过具体的例子讲解如何使用Future。

正如上面所说,Future代表的是异步执行的结果,意思是当异步执行结束之后,返回的结果将会保存在Future中。

那么我们什么时候会用到Future呢? 一般来说,当我们执行一个长时间运行的任务时,使用Future就可以让我们暂时去处理其他的任务,等长任务执行完毕再返回其结果。

经常会使用到Future的场景有:1. 计算密集场景。2. 处理大数据量。3. 远程方法调用等。

接下来我们将会使用ExecutorService来创建一个Future。

<T> Future<T> submit(Callable<T> task);上面是ExecutorService中定义的一个submit方法,它接收一个Callable参数,并返回一个Future。

我们用一个线程来计算一个平方运算:

private ExecutorService executor

= Executors.newSingleThreadExecutor();

public Future<Integer> calculate(Integer input) {

return executor.submit(() -> {

System.out.println("Calculating..."+ input);

Thread.sleep(1000);

return input * input;

});

}submit需要接受一个Callable参数,Callable需要实现一个call方法,并返回结果。这里我们使用lamaba表达式来简化这一个流程。

上面我们创建好了Future,接下来我们看一下怎么获取到Future的值。

FutureUsage futureUsage=new FutureUsage();

Future<Integer> futureOne = futureUsage.calculate(20);

while(!futureOne.isDone()) {

System.out.println("Calculating...");

Thread.sleep(300);

}

Integer result = futureOne.get();首先我们通过Future.isDone() 来判断这个异步操作是否执行完毕,如果完毕我们就可以直接调用futureOne.get()来获得Futre的结果。

这里futureOne.get()是一个阻塞操作,会一直等待异步执行完毕才返回结果。

如果我们不想等待,future提供了一个带时间的方法:

Integer result = futureOne.get(500, TimeUnit.MILLISECONDS);如果在等待时间结束的时候,Future还有返回,则会抛出一个TimeoutException。

如果我们提交了一个异步程序,但是想取消它, 则可以这样:

uture<Integer> futureTwo = futureUsage.calculate(4);

boolean canceled = futureTwo.cancel(true);Future.cancel(boolean) 传入一个boolean参数,来选择是否中断正在运行的task。

如果我们cancel之后,再次调用get()方法,则会抛出CancellationException。

如果有两个计算任务,先看下在单线程下运行的结果。

Future<Integer> future1 = futureUsage.calculate(10);

Future<Integer> future2 = futureUsage.calculate(100);

while (!(future1.isDone() && future2.isDone())) {

System.out.println(

String.format(

"future1 is %s and future2 is %s",

future1.isDone() ? "done" : "not done",

future2.isDone() ? "done" : "not done"

)

);

Thread.sleep(300);

}

Integer result1 = future1.get();

Integer result2 = future2.get();

System.out.println(result1 + " and " + result2);因为我们通过Executors.newSingleThreadExecutor()来创建的单线程池。所以运行结果如下:

Calculating...10

future1 is not done and future2 is not done

future1 is not done and future2 is not done

future1 is not done and future2 is not done

future1 is not done and future2 is not done

Calculating...100

future1 is done and future2 is not done

future1 is done and future2 is not done

future1 is done and future2 is not done

100 and 10000如果我们使用Executors.newFixedThreadPool(2)来创建一个多线程池,则可以得到如下的结果:

calculating...10

calculating...100

future1 is not done and future2 is not done

future1 is not done and future2 is not done

future1 is not done and future2 is not done

future1 is not done and future2 is not done

100 and 10000ExecutorService是java中的一个异步执行的框架,通过使用ExecutorService可以方便的创建多线程执行环境。

本文将会详细的讲解ExecutorService的具体使用。

通常来说有两种方法来创建ExecutorService。

第一种方式是使用Executors中的工厂类方法,例如:

ExecutorService executor = Executors.newFixedThreadPool(10);除了newFixedThreadPool方法之外,Executors还包含了很多创建ExecutorService的方法。

第二种方法是直接创建一个ExecutorService, 因为ExecutorService是一个interface,我们需要实例化ExecutorService的一个实现。

这里我们使用ThreadPoolExecutor来举例:

ExecutorService executorService =

new ThreadPoolExecutor(1, 1, 0L, TimeUnit.MILLISECONDS,

new LinkedBlockingQueue<Runnable>());ExecutorService可以执行Runnable和Callable的task。其中Runnable是没有返回值的,而Callable是有返回值的。我们分别看一下两种情况的使用:

Runnable runnableTask = () -> {

try {

TimeUnit.MILLISECONDS.sleep(300);

} catch (InterruptedException e) {

e.printStackTrace();

}

};

Callable<String> callableTask = () -> {

TimeUnit.MILLISECONDS.sleep(300);

return "Task's execution";

};将task分配给ExecutorService,可以通过调用xecute(), submit(), invokeAny(), invokeAll()这几个方法来实现。

execute() 返回值是void,他用来提交一个Runnable task。

executorService.execute(runnableTask);submit() 返回值是Future,它可以提交Runnable task, 也可以提交Callable task。 提交Runnable的有两个方法:

<T> Future<T> submit(Runnable task, T result);

Future<?> submit(Runnable task);第一个方法在返回传入的result。第二个方法返回null。

再看一下callable的使用:

Future<String> future =

executorService.submit(callableTask);invokeAny() 将一个task列表传递给executorService,并返回其中的一个成功返回的结果。

String result = executorService.invokeAny(callableTasks);invokeAll() 将一个task列表传递给executorService,并返回所有成功执行的结果:

List<Future<String>> futures = executorService.invokeAll(callableTasks);如果ExecutorService中的任务运行完毕之后,ExecutorService不会自动关闭。它会等待接收新的任务。如果需要关闭ExecutorService, 我们需要调用shutdown() 或者 shutdownNow() 方法。

shutdown() 会立即销毁ExecutorService,它会让ExecutorServic停止接收新的任务,并等待现有任务全部执行完毕再销毁。

executorService.shutdown();shutdownNow()并不保证所有的任务都被执行完毕,它会返回一个未执行任务的列表:

List<Runnable> notExecutedTasks = executorService.shutdownNow();oracle推荐的最佳关闭方法是和awaitTermination一起使用:

executorService.shutdown();

try {

if (!executorService.awaitTermination(800, TimeUnit.MILLISECONDS)) {

executorService.shutdownNow();

}

} catch (InterruptedException e) {

executorService.shutdownNow();

}先停止接收任务,然后再等待一定的时间让所有的任务都执行完毕,如果超过了给定的时间,则立刻结束任务。

submit() 和 invokeAll() 都会返回Future对象。之前的文章我们已经详细讲过了Future。 这里就只列举一下怎么使用:

Future<String> future = executorService.submit(callableTask);

String result = null;

try {

result = future.get();

} catch (InterruptedException | ExecutionException e) {

e.printStackTrace();

}ScheduledExecutorService为我们提供了定时执行任务的机制。

我们这样创建ScheduledExecutorService:

ScheduledExecutorService executorService

= Executors.newSingleThreadScheduledExecutor();executorService的schedule方法,可以传入Runnable也可以传入Callable:

Future<String> future = executorService.schedule(() -> {

// ...

return "Hello world";

}, 1, TimeUnit.SECONDS);

ScheduledFuture<?> scheduledFuture = executorService.schedule(() -> {

// ...

}, 1, TimeUnit.SECONDS);还有两个比较相近的方法:

scheduleAtFixedRate( Runnable command, long initialDelay, long period, TimeUnit unit )

scheduleWithFixedDelay( Runnable command, long initialDelay, long delay, TimeUnit unit ) 两者的区别是前者的period是以任务开始时间来计算的,后者是以任务结束时间来计算。

java 7 引入了Fork/Join框架。 那么两者的区别是什么呢?

ExecutorService可以由用户来自己控制生成的线程,提供了对线程更加细粒度的控制。而Fork/Join则是为了让任务更加快速的执行完毕。

在java的多线程开发中Runnable一直以来都是多线程的核心,而Callable是java1.5添加进来的一个增强版本。

本文我们会详细探讨Runnable和Callable的区别。

首先看下Runnable和Callable的接口定义:

@FunctionalInterface

public interface Runnable {

/**

* When an object implementing interface <code>Runnable</code> is used

* to create a thread, starting the thread causes the object's

* <code>run</code> method to be called in that separately executing

* thread.

* <p>

* The general contract of the method <code>run</code> is that it may

* take any action whatsoever.

*

* @see java.lang.Thread#run()

*/

public abstract void run();

}@FunctionalInterface

public interface Callable<V> {

/**

* Computes a result, or throws an exception if unable to do so.

*

* @return computed result

* @throws Exception if unable to compute a result

*/

V call() throws Exception;

}Runnable需要实现run()方法,Callable需要实现call()方法。

我们都知道要自定义一个Thread有两种方法,一是继承Thread,而是实现Runnable接口,这是因为Thread本身就是一个Runnable的实现:

class Thread implements Runnable {

/* Make sure registerNatives is the first thing <clinit> does. */

private static native void registerNatives();

static {

registerNatives();

}

...所以Runnable可以通过Runnable和之前我们介绍的ExecutorService 来执行,而Callable则只能通过ExecutorService 来执行。

根据上面两个接口的定义,Runnable是不返还值的,而Callable可以返回值。

如果我们都通过ExecutorService来提交,看看有什么不同:

- 使用runnable

public void executeTask() {

ExecutorService executorService = Executors.newSingleThreadExecutor();

Future future = executorService.submit(()->log.info("in runnable!!!!"));

executorService.shutdown();

}- 使用callable

public void executeTask() {

ExecutorService executorService = Executors.newSingleThreadExecutor();

Future future = executorService.submit(()->{

log.info("in callable!!!!");

return "callable";

});

executorService.shutdown();

}虽然我们都返回了Future,但是runnable的情况下Future将不包含任何值。

Runnable的run()方法定义没有抛出任何异常,所以任何的Checked Exception都需要在run()实现方法中自行处理。

Callable的Call()方法抛出了throws Exception,所以可以在call()方法的外部,捕捉到Checked Exception。我们看下Callable中异常的处理。

public void executeTaskWithException(){

ExecutorService executorService = Executors.newSingleThreadExecutor();

Future future = executorService.submit(()->{

log.info("in callable!!!!");

throw new CustomerException("a customer Exception");

});

try {

Object object= future.get();

} catch (InterruptedException e) {

e.printStackTrace();

} catch (ExecutionException e) {

e.printStackTrace();

e.getCause();

}

executorService.shutdown();

}上面的例子中,我们在Callable中抛出了一个自定义的CustomerException。

这个异常会被包含在返回的Future中。当我们调用future.get()方法时,就会抛出ExecutionException,通过e.getCause(),就可以获取到包含在里面的具体异常信息。

ThreadLocal主要用来为当前线程存储数据,这个数据只有当前线程可以访问。

在定义ThreadLocal的时候,我们可以同时定义存储在ThreadLocal中的特定类型的对象。

ThreadLocal<Integer> threadLocalValue = new ThreadLocal<>();上面我们定义了一个存储Integer的ThreadLocal对象。

要存储和获取ThreadLocal中的对象也非常简单,使用get()和set()即可:

threadLocalValue.set(1);

Integer result = threadLocalValue.get();我可以将ThreadLocal看成是一个map,而当前的线程就是map中的key。

除了new一个ThreadLocal对象,我们还可以通过:

public static <S> ThreadLocal<S> withInitial(Supplier<? extends S> supplier) {

return new SuppliedThreadLocal<>(supplier);

}ThreadLocal提供的静态方法withInitial来初始化一个ThreadLocal。

ThreadLocal<Integer> threadLocal = ThreadLocal.withInitial(() -> 1);withInitial需要一个Supplier对象,通过调用Supplier的get()方法获取到初始值。

要想删除ThreadLocal中的存储数据,可以调用:

threadLocal.remove();下面我通过两个例子的对比,来看一下使用ThreadLocal的好处。

在实际的应用中,我们通常会需要为不同的用户请求存储不同的用户信息,一般来说我们需要构建一个全局的Map,来根据不同的用户ID,来存储不同的用户信息,方便在后面获取。

我们先看下如果使用全局的Map该怎么用:

public class SharedMapWithUserContext implements Runnable {

public static Map<Integer, Context> userContextPerUserId

= new ConcurrentHashMap<>();

private Integer userId;

private UserRepository userRepository = new UserRepository();

public SharedMapWithUserContext(int i) {

this.userId=i;

}

@Override

public void run() {

String userName = userRepository.getUserNameForUserId(userId);

userContextPerUserId.put(userId, new Context(userName));

}

}这里我们定义了一个static的Map来存取用户信息。

再看一下怎么使用:

@Test

public void testWithMap(){

SharedMapWithUserContext firstUser = new SharedMapWithUserContext(1);

SharedMapWithUserContext secondUser = new SharedMapWithUserContext(2);

new Thread(firstUser).start();

new Thread(secondUser).start();

assertEquals(SharedMapWithUserContext.userContextPerUserId.size(), 2);

}如果我们要在ThreadLocal中使用可以这样:

public class ThreadLocalWithUserContext implements Runnable {

private static ThreadLocal<Context> userContext

= new ThreadLocal<>();

private Integer userId;

private UserRepository userRepository = new UserRepository();

public ThreadLocalWithUserContext(int i) {

this.userId=i;

}

@Override

public void run() {

String userName = userRepository.getUserNameForUserId(userId);

userContext.set(new Context(userName));

System.out.println("thread context for given userId: "

+ userId + " is: " + userContext.get());

}

}测试代码如下:

public class ThreadLocalWithUserContextTest {

@Test

public void testWithThreadLocal(){

ThreadLocalWithUserContext firstUser

= new ThreadLocalWithUserContext(1);

ThreadLocalWithUserContext secondUser

= new ThreadLocalWithUserContext(2);

new Thread(firstUser).start();

new Thread(secondUser).start();

}

}运行之后,我们可以得到下面的结果:

thread context for given userId: 1 is: com.flydean.Context@411734d4

thread context for given userId: 2 is: com.flydean.Context@1e9b6cc不同的用户信息被存储在不同的线程环境中。

注意,我们使用ThreadLocal的时候,一定是我们可以自由的控制所创建的线程。如果在ExecutorService环境下,就最好不要使用ThreadLocal,因为在ExecutorService中,线程是不可控的。

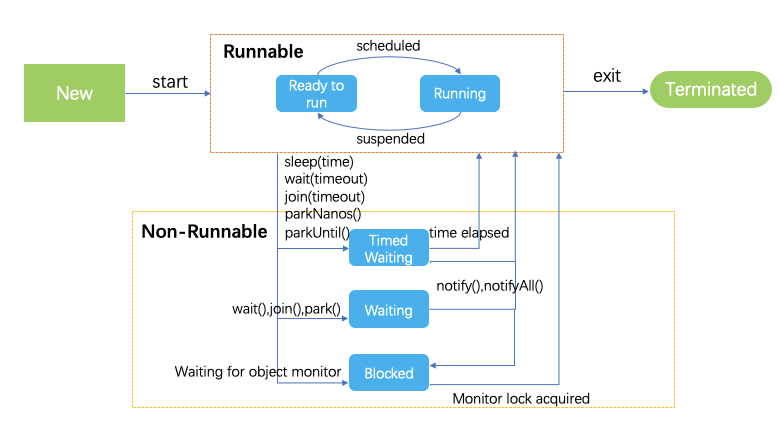

线程是java中绕不过去的一个话题, 今天本文将会详细讲解java中线程的生命周期,希望可以给大家一些启发。

java中Thread有6种状态,分别是:

- NEW - 新创建的Thread,还没有开始执行

- RUNNABLE - 可运行状态的Thread,包括准备运行和正在运行的。

- BLOCKED - 正在等待资源锁的线程

- WAITING - 正在无限期等待其他线程来执行某个特定操作

- TIMED_WAITING - 在一定的时间内等待其他线程来执行某个特定操作

- TERMINATED - 线程执行完毕

我们可以用一个图来直观的表示:

JDK代码中的定义如下:

public enum State {

/**

* Thread state for a thread which has not yet started.

*/

NEW,

/**

* Thread state for a runnable thread. A thread in the runnable

* state is executing in the Java virtual machine but it may

* be waiting for other resources from the operating system

* such as processor.

*/

RUNNABLE,

/**

* Thread state for a thread blocked waiting for a monitor lock.

* A thread in the blocked state is waiting for a monitor lock

* to enter a synchronized block/method or

* reenter a synchronized block/method after calling

* {@link Object#wait() Object.wait}.

*/

BLOCKED,

/**

* Thread state for a waiting thread.

* A thread is in the waiting state due to calling one of the

* following methods:

* <ul>

* <li>{@link Object#wait() Object.wait} with no timeout</li>

* <li>{@link #join() Thread.join} with no timeout</li>

* <li>{@link LockSupport#park() LockSupport.park}</li>

* </ul>

*

* <p>A thread in the waiting state is waiting for another thread to

* perform a particular action.

*

* For example, a thread that has called <tt>Object.wait()</tt>

* on an object is waiting for another thread to call

* <tt>Object.notify()</tt> or <tt>Object.notifyAll()</tt> on

* that object. A thread that has called <tt>Thread.join()</tt>

* is waiting for a specified thread to terminate.

*/

WAITING,

/**

* Thread state for a waiting thread with a specified waiting time.

* A thread is in the timed waiting state due to calling one of

* the following methods with a specified positive waiting time:

* <ul>

* <li>{@link #sleep Thread.sleep}</li>

* <li>{@link Object#wait(long) Object.wait} with timeout</li>

* <li>{@link #join(long) Thread.join} with timeout</li>

* <li>{@link LockSupport#parkNanos LockSupport.parkNanos}</li>

* <li>{@link LockSupport#parkUntil LockSupport.parkUntil}</li>

* </ul>

*/

TIMED_WAITING,

/**

* Thread state for a terminated thread.

* The thread has completed execution.

*/

TERMINATED;

}NEW 表示线程创建了,但是还没有开始执行。我们看一个NEW的例子:

public class NewThread implements Runnable{

public static void main(String[] args) {

Runnable runnable = new NewThread();

Thread t = new Thread(runnable);

log.info(t.getState().toString());

}

@Override

public void run() {

}

}上面的代码将会输出:

NEWRunnable表示线程正在可执行状态。包括正在运行和准备运行两种。

为什么这两种都叫做Runnable呢?我们知道在多任务环境中,CPU的个数是有限的,所以任务都是轮循占有CPU来处理的,JVM中的线程调度器会为每个线程分配特定的执行时间,当执行时间结束后,线程调度器将会释放CPU,以供其他的Runnable线程执行。

我们看一个Runnable的例子:

public class RunnableThread implements Runnable {

@Override

public void run() {

}

public static void main(String[] args) {

Runnable runnable = new RunnableThread();

Thread t = new Thread(runnable);

t.start();

log.info(t.getState().toString());

}

}上面的代码将会输出:

RUNNABLEBLOCKED表示线程正在等待资源锁,而目前该资源正在被其他线程占有。

我们举个例子:

public class BlockThread implements Runnable {

@Override

public void run() {

loopResource();

}

public static synchronized void loopResource() {

while(true) {

//无限循环

}

}

public static void main(String[] args) throws InterruptedException {

Thread t1 = new Thread(new BlockThread());

Thread t2 = new Thread(new BlockThread());

t1.start();

t2.start();

Thread.sleep(1000);

log.info(t1.getState().toString());

log.info(t2.getState().toString());

System.exit(0);

}

}上面的例子中,由于t1是无限循环,将会一直占有资源锁,导致t2无法获取资源锁,从而位于BLOCKED状态。

我们会得到如下结果:

12:40:11.710 [main] INFO com.flydean.BlockThread - RUNNABLE

12:40:11.713 [main] INFO com.flydean.BlockThread - BLOCKEDWAITING 状态表示线程正在等待其他的线程执行特定的操作。有三种方法可以导致线程处于WAITTING状态:

- object.wait()

- thread.join()

- LockSupport.park()

其中1,2方法不需要传入时间参数。

我们看下使用的例子:

public class WaitThread implements Runnable{

public static Thread t1;

@Override

public void run() {

Thread t2 = new Thread(()->{

try {

Thread.sleep(10000);

} catch (InterruptedException e) {

Thread.currentThread().interrupt();

log.error("Thread interrupted", e);

}

log.info("t1"+t1.getState().toString());

});

t2.start();

try {

t2.join();

} catch (InterruptedException e) {

Thread.currentThread().interrupt();

log.error("Thread interrupted", e);

}

log.info("t2"+t2.getState().toString());

}

public static void main(String[] args) {

t1 = new Thread(new WaitThread());

t1.start();

}

}在这个例子中,我们调用的t2.join(),这会使调用它的t1线程处于WAITTING状态。

我们看下输出结果:

12:44:12.958 [Thread-1] INFO com.flydean.WaitThread - t1 WAITING

12:44:12.964 [Thread-0] INFO com.flydean.WaitThread - t2 TERMINATEDTIMED_WAITING状态表示在一个有限的时间内等待其他线程执行特定的某些操作。

java中有5中方式来达到这种状态:

- thread.sleep(long millis)

- wait(int timeout) 或者 wait(int timeout, int nanos)

- thread.join(long millis)

- LockSupport.parkNanos

- LockSupport.parkUntil

我们举个例子:

public class TimedWaitThread implements Runnable{

@Override

public void run() {

try {

Thread.sleep(5000);

} catch (InterruptedException e) {

Thread.currentThread().interrupt();

log.error("Thread interrupted", e);

}

}

public static void main(String[] args) throws InterruptedException {

TimedWaitThread obj1 = new TimedWaitThread();

Thread t1 = new Thread(obj1);

t1.start();

// The following sleep will give enough time for ThreadScheduler

// to start processing of thread t1

Thread.sleep(1000);

log.info(t1.getState().toString());

}

}上面的例子中我们调用了Thread.sleep(5000)来让线程处于TIMED_WAITING状态。

看下输出:

12:58:02.706 [main] INFO com.flydean.TimedWaitThread - TIMED_WAITING那么问题来了,TIMED_WAITING和WAITTING有什么区别呢?

TIMED_WAITING如果在给定的时间内没有等到其他线程的特定操作,则会被唤醒,从而进入争夺资源锁的队列,如果能够获取到锁,则会变成Runnable状态,如果获取不到锁,则会变成BLOCKED状态。

TERMINATED表示线程已经执行完毕。我们看下例子:

public class TerminatedThread implements Runnable{

@Override

public void run() {

}

public static void main(String[] args) throws InterruptedException {

Thread t1 = new Thread(new TerminatedThread());

t1.start();

// The following sleep method will give enough time for

// thread t1 to complete

Thread.sleep(1000);

log.info(t1.getState().toString());

}

}输出结果:

13:02:38.868 [main] INFO com.flydean.TerminatedThread - TERMINATEDjoin()应该是我们在java中经常会用到的一个方法,它主要是将当前线程置为WAITTING状态,然后等待调用的线程执行完毕或被interrupted。

join()是Thread中定义的方法,我们看下他的定义:

/**

* Waits for this thread to die.

*

* <p> An invocation of this method behaves in exactly the same

* way as the invocation

*

* <blockquote>

* {@linkplain #join(long) join}{@code (0)}

* </blockquote>

*

* @throws InterruptedException

* if any thread has interrupted the current thread. The

* <i>interrupted status</i> of the current thread is

* cleared when this exception is thrown.

*/

public final void join() throws InterruptedException {

join(0);

}我们看下join是怎么使用的,通常我们需要在线程A中调用线程B.join():

public class JoinThread implements Runnable{

public int processingCount = 0;

JoinThread(int processingCount) {

this.processingCount = processingCount;

log.info("Thread Created");

}

@Override

public void run() {

log.info("Thread " + Thread.currentThread().getName() + " started");

while (processingCount > 0) {

try {

Thread.sleep(1000);

} catch (InterruptedException e) {

log.info("Thread " + Thread.currentThread().getName() + " interrupted");

}

processingCount--;

}

log.info("Thread " + Thread.currentThread().getName() + " exiting");

}

@Test

public void joinTest()

throws InterruptedException {

Thread t2 = new Thread(new JoinThread(1));

t2.start();

log.info("Invoking join");

t2.join();

log.info("Returned from join");

log.info("t2 status {}",t2.isAlive());

}

}我们在主线程中调用了t2.join(),则主线程将会等待t2执行完毕,我们看下输出结果:

06:17:14.775 [main] INFO com.flydean.JoinThread - Thread Created

06:17:14.779 [main] INFO com.flydean.JoinThread - Invoking join

06:17:14.779 [Thread-0] INFO com.flydean.JoinThread - Thread Thread-0 started

06:17:15.783 [Thread-0] INFO com.flydean.JoinThread - Thread Thread-0 exiting

06:17:15.783 [main] INFO com.flydean.JoinThread - Returned from join

06:17:15.783 [main] INFO com.flydean.JoinThread - t2 status false当线程已经执行完毕或者还没开始执行的时候,join()将会立即返回:

Thread t1 = new SampleThread(0);

t1.join(); //returns immediatelyjoin还有两个带时间参数的方法:

public final void join(long millis) throws InterruptedExceptionpublic final void join(long millis,int nanos) throws InterruptedException如果在给定的时间内调用的线程没有返回,则主线程将会继续执行:

@Test

public void testJoinTimeout()

throws InterruptedException {

Thread t3 = new Thread(new JoinThread(10));

t3.start();

t3.join(1000);

log.info("t3 status {}", t3.isAlive());

}上面的例子将会输出:

06:30:58.159 [main] INFO com.flydean.JoinThread - Thread Created

06:30:58.163 [Thread-0] INFO com.flydean.JoinThread - Thread Thread-0 started

06:30:59.172 [main] INFO com.flydean.JoinThread - t3 status trueJoin()还有个happen-before的特性,这就是如果thread t1调用 t2.join(), 那么当t2返回时,所有t2的变动都会t1可见。

之前我们讲volatile关键词的时候也提到了这个happen-before规则。 我们看下例子:

@Test

public void testHappenBefore() throws InterruptedException {

JoinThread t4 = new JoinThread(10);

t4.start();

// not guaranteed to stop even if t4 finishes.

do {

log.info("inside the loop");

Thread.sleep(1000);

} while ( t4.processingCount > 0);

}我们运行下,可以看到while循环一直在进行中,即使t4中的变量已经变成了0。

所以如果我们需要在这种情况下使用的话,我们需要用到join(),或者其他的同步机制。

我们经常需要在java中用到thread,我们知道thread有一个start()方法可以开启一个线程。那么怎么关闭这个线程呢?

有人会说可以用Thread.stop()方法。但是这个方法已经被废弃了。

根据Oracle的官方文档,Thread.stop是不安全的。因为调用stop方法的时候,将会释放它获取的所有监视器锁(通过传递ThreadDeath异常实现)。如果有资源该监视器锁所保护的话,就可能会出现数据不一致的异常。并且这种异常很难被发现。 所以现在已经不推荐是用Thread.stop方法了。

那我们还有两种方式来关闭一个Thread。

- Flag变量

如果我们有一个无法自动停止的Thread,我们可以创建一个条件变量,通过不断判断该变量的值,来决定是否结束该线程的运行。

public class KillThread implements Runnable {

private Thread worker;

private final AtomicBoolean running = new AtomicBoolean(false);

private int interval;

public KillThread(int sleepInterval) {

interval = sleepInterval;

}

public void start() {

worker = new Thread(this);

worker.start();

}

public void stop() {

running.set(false);

}

public void run() {

running.set(true);

while (running.get()) {

try {

Thread.sleep(interval);

} catch (InterruptedException e){

Thread.currentThread().interrupt();

log.info("Thread was interrupted, Failed to complete operation");

}

// do something here

}

log.info("finished");

}

public static void main(String[] args) {

KillThread killThread= new KillThread(1000);

killThread.start();

killThread.stop();

}

}上面的例子中,我们通过定义一个AtomicBoolean 的原子变量来存储Flag标志。

我们将会在后面的文章中详细的讲解原子变量。

- 调用interrupt()方法

通过调用interrupt()方法,将会中断正在等待的线程,并抛出InterruptedException异常。

根据Oracle的说明,如果你想自己处理这个异常的话,需要reasserts出去,注意,这里是reasserts而不是rethrows,因为有些情况下,无法rethrow这个异常,我们需要这样做:

Thread.currentThread().interrupt();这将会reasserts InterruptedException异常。

看下我们第二种方法怎么调用:

public class KillThread implements Runnable {

private Thread worker;

private final AtomicBoolean running = new AtomicBoolean(false);

private int interval;

public KillThread(int sleepInterval) {

interval = sleepInterval;

}

public void start() {

worker = new Thread(this);

worker.start();

}

public void interrupt() {

running.set(false);

worker.interrupt();

}

public void stop() {

running.set(false);

}

public void run() {

running.set(true);

while (running.get()) {

try {

Thread.sleep(interval);

} catch (InterruptedException e){

Thread.currentThread().interrupt();

log.info("Thread was interrupted, Failed to complete operation");

}

// do something here

}

log.info("finished");

}

public static void main(String[] args) {

KillThread killThread= new KillThread(1000);

killThread.start();

killThread.interrupt();

}

}上面的例子中,当线程在Sleep中时,调用了interrupt方法,sleep会退出,并且抛出InterruptedException异常。

在多线程环境中,我们最常遇到的问题就是变量的值进行同步。因为变量需要在多线程中进行共享,所以我们必须需要采用一定的同步机制来进行控制。

通过之前的文章,我们知道可以采用Lock的机制,当然也包括今天我们讲的Atomic类。

下面我们从两种方式来分别介绍。

在之前的文章中,我们也讲了同步的问题,我们再回顾一下。 如果定义了一个计数器如下:

public class Counter {

int counter;

public void increment() {

counter++;

}

}如果是在单线程环境中,上面的代码没有任何问题。但是如果在多线程环境中,counter++将会得到不同的结果。

因为虽然counter++看起来是一个原子操作,但是它实际上包含了三个操作:读数据,加一,写回数据。

我们之前的文章也讲了,如何解决这个问题:

public class LockCounter {

private volatile int counter;

public synchronized void increment() {

counter++;

}

}通过加synchronized,保证同一时间只会有一个线程去读写counter变量。

通过volatile,保证所有的数据直接操作的主缓存,而不使用线程缓存。

这样虽然解决了问题,但是性能可能会受影响,因为synchronized会锁住整个LockCounter实例。

通过引入低级别的原子化语义命令(比如compare-and-swap (CAS)),从而能在保证效率的同时保证原子性。

一个标准的CAS包含三个操作:

- 将要操作的内存地址M。

- 现有的变量A。

- 新的需要存储的变量B。

CAS将会先比较A和M中存储的值是否一致,一致则表示其他线程未对该变量进行修改,则将其替换为B。 否则不做任何操作。

使用CAS可以不用阻塞其他的线程,但是我们需要自己处理好当更新失败的情况下的业务逻辑处理情况。

Java提供了很多Atomic类,最常用的包括AtomicInteger, AtomicLong, AtomicBoolean, 和 AtomicReference.

其中的主要方法:

- get() – 直接中主内存中读取变量的值,类似于volatile变量。

- set() – 将变量写回主内存。类似于volatile变量。

- lazySet() – 延迟写回主内存。一种常用的情景是将引用重置为null的情况。

- compareAndSet() – 执行CAS操作,成功返回true,失败返回false。

- weakCompareAndSet() – 比较弱的CAS操作,不同的是它不执行happens-before操作,从而不保证能够读取到其他变量最新的值。

我们看下怎么用:

public class AtomicCounter {

private final AtomicInteger counter = new AtomicInteger(0);

public int getValue() {

return counter.get();

}

public void increment() {

while(true) {

int existingValue = getValue();

int newValue = existingValue + 1;

if(counter.compareAndSet(existingValue, newValue)) {

return;

}

}

}

}前面的文章我们讲到了调用interrupt()来停止一个Thread,本文将会详细讲解java中三个非常相似的方法interrupt,interrupted和isInterrupted。

首先看下最简单的isInterrupted方法。isInterrupted是Thread类中的一个实例方法:

public boolean isInterrupted() {

return isInterrupted(false);

}通过调用isInterrupted()可以判断实例线程是否被中断。

它的内部调用了isInterrupted(false)方法:

/**

* Tests if some Thread has been interrupted. The interrupted state

* is reset or not based on the value of ClearInterrupted that is

* passed.

*/

private native boolean isInterrupted(boolean ClearInterrupted);这个方法是个native方法,接收一个是否清除Interrupted标志位的参数。

我们可以看到isInterrupted()传入的参数是false,这就表示isInterrupted()只会判断是否被中断,而不会清除中断状态。

interrupted是Thread中的一个类方法:

public static boolean interrupted() {

return currentThread().isInterrupted(true);

}我们可以看到,interrupted()也调用了isInterrupted(true)方法,不过它传递的参数是true,表示将会清除中断标志位。

注意,因为interrupted()是一个类方法,调用isInterrupted(true)判断的是当前线程是否被中断。注意这里currentThread()的使用。

前面两个是判断是否中断的方法,而interrupt()就是真正触发中断的方法。

我们先看下interrupt的定义:

public void interrupt() {

if (this != Thread.currentThread())

checkAccess();

synchronized (blockerLock) {

Interruptible b = blocker;

if (b != null) {

interrupt0(); // Just to set the interrupt flag

b.interrupt(this);

return;

}

}

interrupt0();

}从定义我们可以看到interrupt()是一个实例方法。

它的工作要点有下面4点:

-

如果当前线程实例在调用Object类的wait(),wait(long)或wait(long,int)方法或join(),join(long),join(long,int)方法,或者在该实例中调用了Thread.sleep(long)或Thread.sleep(long,int)方法,并且正在阻塞状态中时,则其中断状态将被清除,并将收到InterruptedException。

-

如果此线程在InterruptibleChannel上的I / O操作中处于被阻塞状态,则该channel将被关闭,该线程的中断状态将被设置为true,并且该线程将收到java.nio.channels.ClosedByInterruptException异常。

-

如果此线程在java.nio.channels.Selector中处于被被阻塞状态,则将设置该线程的中断状态为true,并且它将立即从select操作中返回。

-

如果上面的情况都不成立,则设置中断状态为true。

我们来举个例子:

@Slf4j

public class InterruptThread extends Thread {

@Override

public void run() {

for (int i = 0; i < 1000; i++) {

log.info("i= {}", (i+1));

log.info("call inside thread.interrupted(): {}", Thread.interrupted());

}

}

@Test

public void testInterrupt(){

InterruptThread thread=new InterruptThread();

thread.start();

thread.interrupt();

//test isInterrupted

log.info("first call isInterrupted(): {}", thread.isInterrupted());

log.info("second call isInterrupted(): {}", thread.isInterrupted());

//test interrupted()

log.info("first call outside thread.interrupted(): {}", Thread.interrupted());

log.info("second call outside thread.interrupted() {}:", Thread.interrupted());

log.info("thread is alive : {}",thread.isAlive() );

}

}输出结果如下:

13:07:17.804 [main] INFO com.flydean.InterruptThread - first call isInterrupted(): true

13:07:17.808 [main] INFO com.flydean.InterruptThread - second call isInterrupted(): true

13:07:17.808 [Thread-1] INFO com.flydean.InterruptThread - call inside thread.interrupted(): true

13:07:17.808 [Thread-1] INFO com.flydean.InterruptThread - call inside thread.interrupted(): false

13:07:17.808 [main] INFO com.flydean.InterruptThread - first call outside thread.interrupted(): false

13:07:17.809 [main] INFO com.flydean.InterruptThread - second call outside thread.interrupted() false上面的例子中,两次调用thread.isInterrupted()的值都是true。

在线程内部调用Thread.interrupted(), 只有第一次返回的是ture,后面返回的都是false,这表明第一次被重置了。

在线程外部,因为并没有中断外部线程,所以返回的值一直都是false。

java中有两种类型的thread,user threads 和 daemon threads。

User threads是高优先级的thread,JVM将会等待所有的User Threads运行完毕之后才会结束运行。

daemon threads是低优先级的thread,它的作用是为User Thread提供服务。 因为daemon threads的低优先级,并且仅为user thread提供服务,所以当所有的user thread都结束之后,JVM会自动退出,不管是否还有daemon threads在运行中。

因为这个特性,所以我们通常在daemon threads中处理无限循环的操作,因为这样不会影响user threads的运行。

daemon threads并不推荐使用在I/O操作中。

但是有些不当的操作也可能导致daemon threads阻塞JVM关闭,比如在daemon thread中调用join()方法。

我们看下怎么创建daemon thread:

public class DaemonThread extends Thread{

public void run(){

while(true){

log.info("Thread A run");

try {

log.info("Thread A is daemon {}" ,Thread.currentThread().isDaemon());

Thread.sleep(1000);

} catch (InterruptedException e) {

e.printStackTrace();

}

}

}

public static void main(String[] args) throws InterruptedException {

DaemonThread daemonThread = new DaemonThread();

daemonThread.setDaemon(true);

daemonThread.start();

}

}创建 daemon thread很简单,只需要在创建之后,设置其daemon属性为true即可。

注意setDaemon(true)必须在thread start()之前执行,否则会抛出IllegalThreadStateException

上面的例子将会立刻退出。

如果我们将daemonThread.setDaemon(true);去掉,则因为user thread一直执行,JVM将会一直运行下去,不会退出。

这是在main中运行的情况,如果我们在一个@Test中运行,会发生什么现象呢?

public class DaemonThread extends Thread{

public void run(){

while(true){

log.info("Thread A run");

try {

log.info("Thread A is daemon {}" ,Thread.currentThread().isDaemon());

Thread.sleep(1000);

} catch (InterruptedException e) {

e.printStackTrace();

}

}

}

@Test

public void testDaemon() throws InterruptedException {

DaemonThread daemonThread = new DaemonThread();

daemonThread.start();

}

}我们将main方法改成了@Test执行。执行之后我们会发现,不管是不是daemon thread, Test都会立刻结束。

再看一个daemon线程中启动一个user thread的情况:

public class DaemonBThread extends Thread{

Thread worker = new Thread(()->{

while(true){

log.info("Thread B run");

log.info("Thread B is daemon {}",Thread.currentThread().isDaemon());

}

});

public void run(){

log.info("Thread A run");

worker.start();

}

public static void main(String[] args) {

DaemonBThread daemonThread = new DaemonBThread();

daemonThread.setDaemon(true);

daemonThread.start();

}

}这个例子中,daemonThread启动了一个user thread,运行之后我们会发现,即使有user thread正在运行,JVM也会立刻结束执行。

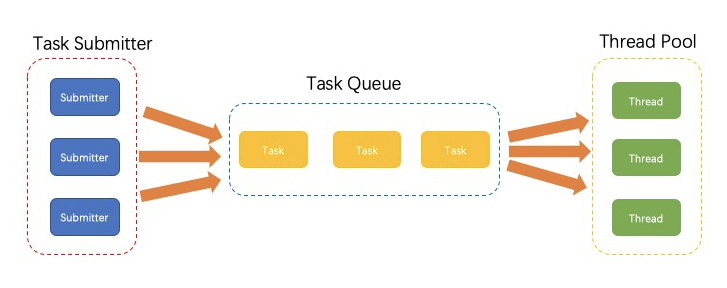

在Java中,threads是和系统的threads相对应的,用来处理一系列的系统资源。不管在windows和linux下面,能开启的线程个数都是有限的,如果你在java程序中无限制的创建thread,那么将会遇到无线程可创建的情况。

CPU的核数是有限的,如果同时有多个线程正在运行中,那么CPU将会根据线程的优先级进行轮循,给每个线程分配特定的CPU时间。所以线程也不是越多越好。

在java中,代表管理ThreadPool的接口有两个:ExecutorService和Executor。

我们运行线程的步骤一般是这样的:1. 创建一个ExecutorService。 2.将任务提交给ExecutorService。3.ExecutorService调度线程来运行任务。

画个图来表示:

下面我讲一下,怎么在java中使用ThreadPool。

Executors 提供了一系列简便的方法,来帮助我们创建ThreadPool。

Executor接口定义了一个方法:

public interface Executor {

/**

* Executes the given command at some time in the future. The command

* may execute in a new thread, in a pooled thread, or in the calling

* thread, at the discretion of the {@code Executor} implementation.

*

* @param command the runnable task

* @throws RejectedExecutionException if this task cannot be

* accepted for execution

* @throws NullPointerException if command is null

*/

void execute(Runnable command);

}ExecutorService继承了Executor,提供了更多的线程池的操作。是对Executor的补充。

根据接口实现分离的原则,我们通常在java代码中使用ExecutorService或者Executor,而不是具体的实现类。

我们看下怎么通过Executors来创建一个Executor和ExecutorService:

Executor executor = Executors.newSingleThreadExecutor();

executor.execute(() -> log.info("in Executor"));

ExecutorService executorService= Executors.newCachedThreadPool();

executorService.submit(()->log.info("in ExecutorService"));

executorService.shutdown();关于ExecutorService的细节,我们这里就多讲了,感兴趣的朋友可以参考之前我写的ExecutorService的详细文章。

ThreadPoolExecutor是ExecutorService接口的一个实现,它可以为线程池添加更加精细的配置,具体而言它可以控制这三个参数:corePoolSize, maximumPoolSize, 和 keepAliveTime。

PoolSize就是线程池里面的线程个数,corePoolSize表示的是线程池里面初始化和保持的最小的线程个数。

如果当前等待线程太多,可以设置maximumPoolSize来提供最大的线程池个数,从而线程池会创建更多的线程以供任务执行。

keepAliveTime是多余的线程未分配任务将会等待的时间。超出该时间,线程将会被线程池回收。

我们看下怎么创建一个ThreadPoolExecutor:

ThreadPoolExecutor threadPoolExecutor =

new ThreadPoolExecutor(1, 1, 0L, TimeUnit.MILLISECONDS,

new LinkedBlockingQueue<Runnable>());

threadPoolExecutor.submit(()->log.info("submit through threadPoolExecutor"));

threadPoolExecutor.shutdown();上面的例子中我们通过ThreadPoolExecutor的构造函数来创建ThreadPoolExecutor。

通常来说Executors已经内置了ThreadPoolExecutor的很多实现,我们来看下面的例子:

ThreadPoolExecutor executor1 =

(ThreadPoolExecutor) Executors.newFixedThreadPool(2);

executor1.submit(() -> {

Thread.sleep(1000);

return null;

});

executor1.submit(() -> {

Thread.sleep(1000);

return null;

});

executor1.submit(() -> {

Thread.sleep(1000);

return null;

});

log.info("executor1 poolsize {}",executor1.getPoolSize());

log.info("executor1 queuesize {}", executor1.getQueue().size());

executor1.shutdown();上的例子中我们Executors.newFixedThreadPool(2)来创建一个ThreadPoolExecutor。

上面的例子中我们提交了3个task。但是我们pool size只有2。所以还有一个1个不能立刻被执行,需要在queue中等待。

我们再看一个例子:

ThreadPoolExecutor executor2 =

(ThreadPoolExecutor) Executors.newCachedThreadPool();

executor2.submit(() -> {

Thread.sleep(1000);

return null;

});

executor2.submit(() -> {

Thread.sleep(1000);

return null;

});

executor2.submit(() -> {

Thread.sleep(1000);

return null;

});

log.info("executor2 poolsize {}", executor2.getPoolSize());

log.info("executor2 queue size {}", executor2.getQueue().size());

executor2.shutdown();上面的例子中我们使用Executors.newCachedThreadPool()来创建一个ThreadPoolExecutor。 运行之后我们可以看到poolsize是3,而queue size是0。这表明newCachedThreadPool会自动增加pool size。

如果thread在60秒钟之类没有被激活,则会被收回。

这里的Queue是一个SynchronousQueue,因为插入和取出基本上是同时进行的,所以这里的queue size基本都是0.

还有个很常用的ScheduledThreadPoolExecutor,它继承自ThreadPoolExecutor, 并且实现了ScheduledExecutorService接口。

public class ScheduledThreadPoolExecutor

extends ThreadPoolExecutor

implements ScheduledExecutorService我们看下怎么使用:

ScheduledExecutorService executor = Executors.newScheduledThreadPool(5);

executor.schedule(() -> {

log.info("Hello World");

}, 500, TimeUnit.MILLISECONDS);上面的例子中,我们定义了一个定时任务将会在500毫秒之后执行。

之前我们也讲到了ScheduledExecutorService还有两个非常常用的方法:

- scheduleAtFixedRate - 以开始时间为间隔。

- scheduleWithFixedDelay - 以结束时间为间隔。

CountDownLatch lock = new CountDownLatch(3);

ScheduledExecutorService executor2 = Executors.newScheduledThreadPool(5);

ScheduledFuture<?> future = executor2.scheduleAtFixedRate(() -> {

log.info("in ScheduledFuture");

lock.countDown();

}, 500, 100, TimeUnit.MILLISECONDS);

lock.await(1000, TimeUnit.MILLISECONDS);

future.cancel(true);ForkJoinPool是在java 7 中引入的新框架,我们将会在后面的文章中详细讲解。 这里做个简单的介绍。

ForkJoinPool主要用来生成大量的任务来做算法运算。如果用线程来做的话,会消耗大量的线程。但是在fork/join框架中就不会出现这个问题。

在fork/join中,任何task都可以生成大量的子task,然后通过使用join()等待子task结束。

这里我们举一个例子:

static class TreeNode {

int value;

Set<TreeNode> children;

TreeNode(int value, TreeNode... children) {

this.value = value;

this.children = Sets.newHashSet(children);

}

}定义一个TreeNode,然后遍历所有的value,将其加起来:

public class CountingTask extends RecursiveTask<Integer> {

private final TreeNode node;

public CountingTask(TreeNode node) {

this.node = node;

}

@Override

protected Integer compute() {

return node.value + node.children.stream()

.map(childNode -> new CountingTask(childNode).fork()).mapToInt(ForkJoinTask::join).sum();

}

}下面是调用的代码:

public static void main(String[] args) {

TreeNode tree = new TreeNode(5,

new TreeNode(3), new TreeNode(2,

new TreeNode(2), new TreeNode(8)));

ForkJoinPool forkJoinPool = ForkJoinPool.commonPool();

int sum = forkJoinPool.invoke(new CountingTask(tree));

}fork join框架是java 7中引入框架,这个框架的引入主要是为了提升并行计算的能力。

fork join主要有两个步骤,第一就是fork,将一个大任务分成很多个小任务,第二就是join,将第一个任务的结果join起来,生成最后的结果。如果第一步中并没有任何返回值,join将会等到所有的小任务都结束。

还记得之前的文章我们讲到了thread pool的基本结构吗?

- ExecutorService - ForkJoinPool 用来调用任务执行。

- workerThread - ForkJoinWorkerThread 工作线程,用来执行具体的任务。

- task - ForkJoinTask 用来定义要执行的任务。

下面我们从这三个方面来详细讲解fork join框架。

ForkJoinPool是一个ExecutorService的一个实现,它提供了对工作线程和线程池的一些便利管理方法。

public class ForkJoinPool extends AbstractExecutorService 一个work thread一次只能处理一个任务,但是ForkJoinPool并不会为每个任务都创建一个单独的线程,它会使用一个特殊的数据结构double-ended queue来存储任务。这样的结构可以方便的进行工作窃取(work-stealing)。

什么是work-stealing呢?

默认情况下,work thread从分配给自己的那个队列头中取出任务。如果这个队列是空的,那么这个work thread会从其他的任务队列尾部取出任务来执行,或者从全局队列中取出。这样的设计可以充分利用work thread的性能,提升并发能力。

下面看下怎么创建一个ForkJoinPool。

最常见的方法就是使用ForkJoinPool.commonPool()来创建,commonPool()为所有的ForkJoinTask提供了一个公共默认的线程池。

ForkJoinPool forkJoinPool = ForkJoinPool.commonPool();另外一种方式是使用构造函数:

ForkJoinPool forkJoinPool = new ForkJoinPool(2);这里的参数是并行级别,2指的是线程池将会使用2个处理器核心。

ForkJoinWorkerThread是使用在ForkJoinPool的工作线程。

public class ForkJoinWorkerThread extends Thread

}和一般的线程不一样的是它定义了两个变量:

final ForkJoinPool pool; // the pool this thread works in

final ForkJoinPool.WorkQueue workQueue; // work-stealing mechanics一个是该worker thread所属的ForkJoinPool。 另外一个是支持 work-stealing机制的Queue。

再看一下它的run方法:

public void run() {

if (workQueue.array == null) { // only run once

Throwable exception = null;

try {

onStart();

pool.runWorker(workQueue);

} catch (Throwable ex) {

exception = ex;

} finally {

try {

onTermination(exception);

} catch (Throwable ex) {

if (exception == null)

exception = ex;

} finally {

pool.deregisterWorker(this, exception);

}

}

}

}简单点讲就是从Queue中取出任务执行。

ForkJoinTask是ForkJoinPool中运行的任务类型。通常我们会用到它的两个子类:RecursiveAction和RecursiveTask。

他们都定义了一个需要实现的compute()方法用来实现具体的业务逻辑。不同的是RecursiveAction只是用来执行任务,而RecursiveTask可以有返回值。

既然两个类都带了Recursive,那么具体的实现逻辑也会跟递归有关,我们举个使用RecursiveAction来打印字符串的例子:

public class CustomRecursiveAction extends RecursiveAction {

private String workload = "";

private static final int THRESHOLD = 4;

private static Logger logger =

Logger.getAnonymousLogger();

public CustomRecursiveAction(String workload) {

this.workload = workload;

}

@Override

protected void compute() {

if (workload.length() > THRESHOLD) {

ForkJoinTask.invokeAll(createSubtasks());

} else {

processing(workload);

}

}

private List<CustomRecursiveAction> createSubtasks() {

List<CustomRecursiveAction> subtasks = new ArrayList<>();

String partOne = workload.substring(0, workload.length() / 2);

String partTwo = workload.substring(workload.length() / 2, workload.length());

subtasks.add(new CustomRecursiveAction(partOne));

subtasks.add(new CustomRecursiveAction(partTwo));

return subtasks;

}

private void processing(String work) {

String result = work.toUpperCase();

logger.info("This result - (" + result + ") - was processed by "

+ Thread.currentThread().getName());

}

}上面的例子使用了二分法来打印字符串。

我们再看一个RecursiveTask的例子:

public class CustomRecursiveTask extends RecursiveTask<Integer> {

private int[] arr;

private static final int THRESHOLD = 20;

public CustomRecursiveTask(int[] arr) {

this.arr = arr;

}

@Override

protected Integer compute() {

if (arr.length > THRESHOLD) {

return ForkJoinTask.invokeAll(createSubtasks())

.stream()

.mapToInt(ForkJoinTask::join)

.sum();

} else {

return processing(arr);

}

}

private Collection<CustomRecursiveTask> createSubtasks() {

List<CustomRecursiveTask> dividedTasks = new ArrayList<>();

dividedTasks.add(new CustomRecursiveTask(

Arrays.copyOfRange(arr, 0, arr.length / 2)));

dividedTasks.add(new CustomRecursiveTask(

Arrays.copyOfRange(arr, arr.length / 2, arr.length)));

return dividedTasks;

}

private Integer processing(int[] arr) {

return Arrays.stream(arr)

.filter(a -> a > 10 && a < 27)

.map(a -> a * 10)

.sum();

}

}和上面的例子很像,不过这里我们需要有返回值。

有了上面的两个任务,我们就可以在ForkJoinPool中提交了:

int[] intArray= {12,12,13,14,15};

CustomRecursiveTask customRecursiveTask= new CustomRecursiveTask(intArray);

int result = forkJoinPool.invoke(customRecursiveTask);

System.out.println(result);上面的例子中,我们使用invoke来提交,invoke将会等待任务的执行结果。

如果不使用invoke,我们也可以将其替换成fork()和join():

customRecursiveTask.fork();

int result2= customRecursiveTask.join();

System.out.println(result2);fork() 是将任务提交给pool,但是并不触发执行, join()将会真正的执行并且得到返回结果。

在java并发中,控制共享变量的访问非常重要,有时候我们也想控制并发线程的执行顺序,比如:等待所有线程都执行完毕之后再执行另外的线程,或者等所有线程都准备好了才开始所有线程的执行等。

这个时候我们就可以使用到CountDownLatch。

简单点讲,CountDownLatch存有一个放在QueuedSynchronizer中的计数器。当调用countdown() 方法时,该计数器将会减一。然后再调用await()来等待计数器归零。

private static final class Sync extends AbstractQueuedSynchronizer {

...

}

private final Sync sync;

public void countDown() {

sync.releaseShared(1);

} public void await() throws InterruptedException {

sync.acquireSharedInterruptibly(1);

}

public boolean await(long timeout, TimeUnit unit)

throws InterruptedException {

return sync.tryAcquireSharedNanos(1, unit.toNanos(timeout));

}下面我们举两个使用的例子:

这里我们定义子线程类,在子线程类里面,我们传入一个CountDownLatch用来计数,然后在子线程结束之前,调用该CountDownLatch的countDown方法。最后在主线程中调用await()方法来等待子线程结束执行。

@Slf4j

public class MainThreadWaitUsage implements Runnable {

private List<String> outputScraper;

private CountDownLatch countDownLatch;

public MainThreadWaitUsage(List<String> outputScraper, CountDownLatch countDownLatch) {

this.outputScraper = outputScraper;

this.countDownLatch = countDownLatch;

}

@Override

public void run() {

outputScraper.add("Counted down");

countDownLatch.countDown();

}

}看下怎么调用:

@Test

public void testCountDownLatch()

throws InterruptedException {

List<String> outputScraper = Collections.synchronizedList(new ArrayList<>());

CountDownLatch countDownLatch = new CountDownLatch(5);

List<Thread> workers = Stream

.generate(() -> new Thread(new MainThreadWaitUsage(outputScraper, countDownLatch)))

.limit(5)

.collect(toList());

workers.forEach(Thread::start);

countDownLatch.await();

outputScraper.add("Latch released");

log.info(outputScraper.toString());

}执行结果如下:

07:37:27.388 [main] INFO MainThreadWaitUsageTest - [Counted down, Counted down, Counted down, Counted down, Counted down, Latch released]上面的例子中,我们是主线程等待子线程,那么在这个例子中,我们将会看看怎么子线程一起等待到准备好的状态,再一起执行。

思路也很简单,在子线程开始之后,将等待的子线程计数器减一,在主线程中await该计数器,等计数器归零之后,主线程再通知子线程运行。

public class ThreadWaitThreadUsage implements Runnable {

private List<String> outputScraper;

private CountDownLatch readyThreadCounter;

private CountDownLatch callingThreadBlocker;

private CountDownLatch completedThreadCounter;

public ThreadWaitThreadUsage(

List<String> outputScraper,

CountDownLatch readyThreadCounter,

CountDownLatch callingThreadBlocker,

CountDownLatch completedThreadCounter) {

this.outputScraper = outputScraper;

this.readyThreadCounter = readyThreadCounter;

this.callingThreadBlocker = callingThreadBlocker;

this.completedThreadCounter = completedThreadCounter;

}

@Override

public void run() {

readyThreadCounter.countDown();

try {

callingThreadBlocker.await();

outputScraper.add("Counted down");

} catch (InterruptedException e) {

e.printStackTrace();

} finally {

completedThreadCounter.countDown();

}

}

}看下怎么调用:

@Test

public void testCountDownLatch()

throws InterruptedException {

List<String> outputScraper = Collections.synchronizedList(new ArrayList<>());

CountDownLatch readyThreadCounter = new CountDownLatch(5);

CountDownLatch callingThreadBlocker = new CountDownLatch(1);

CountDownLatch completedThreadCounter = new CountDownLatch(5);

List<Thread> workers = Stream

.generate(() -> new Thread(new ThreadWaitThreadUsage(

outputScraper, readyThreadCounter, callingThreadBlocker, completedThreadCounter)))

.limit(5)

.collect(toList());

workers.forEach(Thread::start);

readyThreadCounter.await();

outputScraper.add("Workers ready");

callingThreadBlocker.countDown();

completedThreadCounter.await();

outputScraper.add("Workers complete");

log.info(outputScraper.toString());

}输出结果如下:

07:41:47.861 [main] INFO ThreadWaitThreadUsageTest - [Workers ready, Counted down, Counted down, Counted down, Counted down, Counted down, Workers complete]如果我们调用await()方法,该方法将会等待一直到count=0才结束。但是如果在线程执行过程中出现了异常,可能导致countdown方法执行不了。那么await()方法可能会出现无限等待的情况。

这个时候我们可以使用:

public boolean await(long timeout, TimeUnit unit)

throws InterruptedException {

return sync.tryAcquireSharedNanos(1, unit.toNanos(timeout));

}CyclicBarrier是java 5中引入的线程安全的组件。它有一个barrier的概念,主要用来等待所有的线程都执行完毕,然后再去执行特定的操作。

假如我们有很多个线程,每个线程都计算出了一些数据,然后我们需要等待所有的线程都执行完毕,再把各个线程计算出来的数据加起来,的到最终的结果,那么我们就可以使用CyclicBarrier。

我们先看下CyclicBarrier的构造函数:

public CyclicBarrier(int parties, Runnable barrierAction) {

if (parties <= 0) throw new IllegalArgumentException();

this.parties = parties;

this.count = parties;

this.barrierCommand = barrierAction;

}

public CyclicBarrier(int parties) {

this(parties, null);

}CyclicBarrier有两个构造函数,第一个只接受一个参数,表示需要统一行动的线程个数。第二个参数叫做barrierAction,表示出发barrier是需要执行的方法。

其中barrierAction是一个Runnable,我们可以在其中定义最后需要执行的工作。

再看下重要await方法:

public int await() throws InterruptedException, BrokenBarrierException {

try {

return dowait(false, 0L);

} catch (TimeoutException toe) {

throw new Error(toe); // cannot happen

}

}

public int await(long timeout, TimeUnit unit)

throws InterruptedException,

BrokenBarrierException,

TimeoutException {

return dowait(true, unit.toNanos(timeout));

}await也有两个方法,一个是带时间参数的,一个是不带时间参数的。

await本质上调用了lock.newCondition().await()方法。

因为有多个parties,下面我们考虑两种情况。

- 该线程不是最后一个调用await的线程

在这种情况下,该线程将会进入等待状态,直到下面的情况发送:

- 最后一个线程调用await()

- 其他线程中断了当前线程

- 其他线程中断了其他正在等待的线程

- 其他线程在等待barrier的时候超时

- 其他线程在该barrier上调用的reset()方法

如果该线程在调用await()的时候已经设置了interrupted的状态,或者在等待的时候被interrupted,那么将会抛出InterruptedException异常,并清除中断状态。(这里和Thread的interrupt()方法保持一致)

如果任何线程正在等待状态中,这时候barrier被重置。或者在线程调用await方法或者正在等待中,barrier被broken,那么将会抛出BrokenBarrierException。

如果任何线程在等待的时候被中断,那么所有其他等待的线程将会抛出BrokenBarrierException,barrier将会被置为broken状态。

- 如果该线程是最后一个调用await方法的

在这种情况,如果barrierAction不为空,那么该线程将会在其他线程继续执行前调用这个barrierAction。

如果该操作抛出异常,那么barrier的状态将会被置为broken状态。

再看看这个reset() 方法:

public void reset() {

final ReentrantLock lock = this.lock;

lock.lock();

try {

breakBarrier(); // break the current generation

nextGeneration(); // start a new generation

} finally {

lock.unlock();

}

}该方法将会将barrier置为broken状态,并且开启一个新的generation,来进行下一轮的操作。

我们在子线程中生成一个随机的整数队列,当所有的线程都生成完毕之后,我们再将生成的整数全都加起来。看下怎么实现。

定义生成整数队列的子线程:

public class CyclicBarrierUsage implements Runnable {

private CyclicBarrier cyclicBarrier;

private List<List<Integer>> partialResults;

private Random random = new Random();

public CyclicBarrierUsage(CyclicBarrier cyclicBarrier,List<List<Integer>> partialResults){

this.cyclicBarrier=cyclicBarrier;

this.partialResults=partialResults;

}

@Override

public void run() {

String thisThreadName = Thread.currentThread().getName();

List<Integer> partialResult = new ArrayList<>();

// Crunch some numbers and store the partial result

for (int i = 0; i < 10; i++) {

Integer num = random.nextInt(10);

System.out.println(thisThreadName

+ ": Crunching some numbers! Final result - " + num);

partialResult.add(num);

}

partialResults.add(partialResult);

try {

System.out.println(thisThreadName

+ " waiting for others to reach barrier.");

cyclicBarrier.await();

} catch (InterruptedException e) {

// ...

} catch (BrokenBarrierException e) {

// ...

}

}

}上面的子线程接收外部传入的cyclicBarrier和保存数据的partialResults,并在运行完毕调用cyclicBarrier.await()来等待其他线程执行完毕。

看下CyclicBarrier的构建:

CyclicBarrier cyclicBarrier=new CyclicBarrier(5,()->{

String thisThreadName = Thread.currentThread().getName();

System.out.println(

thisThreadName + ": Computing sum of 5 workers, having 10 results each.");

int sum = 0;

for (List<Integer> threadResult : partialResults) {

System.out.print("Adding ");

for (Integer partialResult : threadResult) {

System.out.print(partialResult+" ");

sum += partialResult;

}

System.out.println();

}

System.out.println(thisThreadName + ": Final result = " + sum);

});在CyclicBarrier中,我们定义了一个BarrierAction来做最后数据的汇总处理。

运行:

for (int i = 0; i < 5; i++) {

Thread worker = new Thread(new CyclicBarrierUsage(cyclicBarrier,partialResults));

worker.setName("Thread " + i);

worker.start();

}输出结果如下:

Spawning 5 worker threads to compute 10 partial results each

Thread 0: Crunching some numbers! Final result - 5

Thread 0: Crunching some numbers! Final result - 3

Thread 1: Crunching some numbers! Final result - 1

Thread 0: Crunching some numbers! Final result - 7

Thread 1: Crunching some numbers! Final result - 8

Thread 0: Crunching some numbers! Final result - 4

Thread 0: Crunching some numbers! Final result - 6

Thread 0: Crunching some numbers! Final result - 9

Thread 1: Crunching some numbers! Final result - 3

Thread 2: Crunching some numbers! Final result - 1

Thread 0: Crunching some numbers! Final result - 0

Thread 2: Crunching some numbers! Final result - 9

Thread 1: Crunching some numbers! Final result - 3

Thread 2: Crunching some numbers! Final result - 7

Thread 0: Crunching some numbers! Final result - 2

Thread 2: Crunching some numbers! Final result - 6

Thread 1: Crunching some numbers! Final result - 6

Thread 2: Crunching some numbers! Final result - 5

Thread 0: Crunching some numbers! Final result - 0

Thread 2: Crunching some numbers! Final result - 1

Thread 1: Crunching some numbers! Final result - 5

Thread 2: Crunching some numbers! Final result - 1

Thread 0: Crunching some numbers! Final result - 7

Thread 2: Crunching some numbers! Final result - 8

Thread 1: Crunching some numbers! Final result - 2

Thread 2: Crunching some numbers! Final result - 4

Thread 0 waiting for others to reach barrier.

Thread 2: Crunching some numbers! Final result - 0

Thread 2 waiting for others to reach barrier.

Thread 1: Crunching some numbers! Final result - 7

Thread 1: Crunching some numbers! Final result - 6

Thread 1: Crunching some numbers! Final result - 9

Thread 1 waiting for others to reach barrier.

Thread 3: Crunching some numbers! Final result - 9

Thread 3: Crunching some numbers! Final result - 3

Thread 3: Crunching some numbers! Final result - 8

Thread 3: Crunching some numbers! Final result - 8

Thread 3: Crunching some numbers! Final result - 1

Thread 3: Crunching some numbers! Final result - 8

Thread 3: Crunching some numbers! Final result - 0

Thread 3: Crunching some numbers! Final result - 5

Thread 3: Crunching some numbers! Final result - 9

Thread 3: Crunching some numbers! Final result - 1

Thread 3 waiting for others to reach barrier.

Thread 4: Crunching some numbers! Final result - 2

Thread 4: Crunching some numbers! Final result - 2

Thread 4: Crunching some numbers! Final result - 5

Thread 4: Crunching some numbers! Final result - 5

Thread 4: Crunching some numbers! Final result - 3

Thread 4: Crunching some numbers! Final result - 7

Thread 4: Crunching some numbers! Final result - 4

Thread 4: Crunching some numbers! Final result - 8

Thread 4: Crunching some numbers! Final result - 4

Thread 4: Crunching some numbers! Final result - 3

Thread 4 waiting for others to reach barrier.

Thread 4: Computing sum of 5 workers, having 10 results each.

Adding 5 3 7 4 6 9 0 2 0 7

Adding 1 9 7 6 5 1 1 8 4 0

Adding 1 8 3 3 6 5 2 7 6 9

Adding 9 3 8 8 1 8 0 5 9 1

Adding 2 2 5 5 3 7 4 8 4 3

Thread 4: Final result = 230

Process finished with exit code 0JMH的全称是Java Microbenchmark Harness,是一个open JDK中用来做性能测试的套件。该套件已经被包含在了JDK 12中。

本文将会讲解如何使用JMH来在java中做性能测试。

如果你使用的不是JDK 12,那么需要添加如下依赖:

<dependency>

<groupId>org.openjdk.jmh</groupId>

<artifactId>jmh-core</artifactId>

<version>1.19</version>

</dependency>

<dependency>

<groupId>org.openjdk.jmh</groupId>

<artifactId>jmh-generator-annprocess</artifactId>

<version>1.19</version>

</dependency>如果我们想测试某个方法的性能,一般来说就是重复执行某个方法n次,求出总的执行时间,然后求平均值。

但是这样通常会有一些问题,比如程序的头几次执行通常会比较慢,因为JVM会对多次执行的代码进行优化。另外得出的统计结果也不够直观,需要我们自行解析。

如果使用JMH可以轻松解决这些问题。

在JMH中,将要测试的方法添加@Benchmark注解即可:

@Benchmark

public void measureThroughput() throws InterruptedException {

TimeUnit.MILLISECONDS.sleep(100);

}看下怎么调用:

public static void main(String[] args) throws RunnerException {

Options opt = new OptionsBuilder()

.include(BenchMarkUsage.class.getSimpleName())

// .include(BenchMarkUsage.class.getSimpleName()+".*measureThroughput*")

// 预热3轮

.warmupIterations(3)

// 度量5轮

.measurementIterations(5)

.forks(1)

.build();

new Runner(opt).run();

}上面的例子,我们通过OptionsBuilder的include方法添加了需要进行测试的类。

默认情况下,该类的所有@Benchmark方法都将会被测试,如果我们只想测试其中的某个方法,我们可以在类后面加上方法的名字:

.include(BenchMarkUsage.class.getSimpleName()+".*measureAll*")上面的代码支持通配符。

warmupIterations(3)意思是在真正的执行前,先热身三次。

measurementIterations(5)表示我们将方法运行5次来测试性能。

forks(1)表示启动一个进程来执行这个任务。

上面是最基本的运行,我们看下运行结果:

# JMH version: 1.19

# VM version: JDK 1.8.0_171, VM 25.171-b11

# VM invoker: /Library/Java/JavaVirtualMachines/jdk1.8.0_171.jdk/Contents/Home/jre/bin/java

# VM options: -javaagent:/Applications/IntelliJ IDEA 2.app/Contents/lib/idea_rt.jar=55941:/Applications/IntelliJ IDEA 2.app/Contents/bin -Dfile.encoding=UTF-8

# Warmup: 3 iterations, 1 s each

# Measurement: 5 iterations, 1 s each

# Timeout: 10 min per iteration

# Threads: 1 thread, will synchronize iterations

# Benchmark mode: Throughput, ops/time

# Benchmark: com.flydean.BenchMarkUsage.measureThroughput

# Run progress: 26.66% complete, ETA 00:01:42

# Fork: 1 of 1

# Warmup Iteration 1: 9.727 ops/s

# Warmup Iteration 2: 9.684 ops/s

# Warmup Iteration 3: 9.678 ops/s

Iteration 1: 9.652 ops/s

Iteration 2: 9.678 ops/s

Iteration 3: 9.733 ops/s

Iteration 4: 9.651 ops/s

Iteration 5: 9.678 ops/s

Result "com.flydean.BenchMarkUsage.measureThroughput":

9.678 ±(99.9%) 0.129 ops/s [Average]

(min, avg, max) = (9.651, 9.678, 9.733), stdev = 0.034

CI (99.9%): [9.549, 9.808] (assumes normal distribution)ops/s 是每秒的OPS次数。程序会给出运行的最小值,平均值和最大值。同时给出标准差stdev和置信区间CI。

上面的例子中, 我们只用了最简单的@Benchmark。如果想实现更加复杂和自定义的BenchMark,我们可以使用@BenchmarkMode。

先举个例子:

@Benchmark

@BenchmarkMode(Mode.Throughput)

@OutputTimeUnit(TimeUnit.SECONDS)

public void measureThroughput() throws InterruptedException {

TimeUnit.MILLISECONDS.sleep(100);

}上面的例子中,我们指定了@BenchmarkMode(Mode.Throughput),Throughput的意思是整体吞吐量,表示给定的时间内执行的次数。

这里我们通过 @OutputTimeUnit(TimeUnit.SECONDS)来指定时间单位。

Mode除了Throughput还有如下几种模式:

- AverageTime - 调用的平均时间

- SampleTime - 随机取样,最后输出取样结果的分布

- SingleShotTime - 只会执行一次,通常用来测试冷启动时候的性能。

- All - 所有的benchmark modes。

上面的例子中我们通过代码来显式的制定Fork和Warmup,我们也可以使用注解来实现:

@Fork(value = 1, warmups = 2)

@Warmup(iterations = 5)上面的例子中value表示该benchMark执行多少次,warmups表示fork多少个进程来执行。iterations表示warmup的iterations个数。

如果你同时在代码中和注解中都配置了相关的信息,那么注解将会覆盖掉代码中的显示配置。

如果我们在多线程环境中使用beachMark,那么多线程中用到的类变量是共享还是每个线程一个呢?

这个时候我们就要用到@State注解。

@State(Scope.Benchmark)

public class StateUsage {

}Scope有三种:

- Scope.Thread:默认的State,每个测试线程分配一个实例;

- Scope.Benchmark:所有测试线程共享一个实例,用于测试有状态实例在多线程共享下的性能;

- Scope.Group:每个线程组共享一个实例;

在java中我们通常会需要使用到java.util.Random来便利的生产随机数。但是Random是线程安全的,如果要在线程环境中的话就有可能产生性能瓶颈。

我们以Random中常用的nextInt方法为例来具体看一下:

public int nextInt() {

return next(32);

}nextInt方法实际上调用了下面的方法:

protected int next(int bits) {

long oldseed, nextseed;

AtomicLong seed = this.seed;

do {

oldseed = seed.get();

nextseed = (oldseed * multiplier + addend) & mask;

} while (!seed.compareAndSet(oldseed, nextseed));

return (int)(nextseed >>> (48 - bits));

}从代码中我们可以看到,方法内部使用了AtomicLong,并调用了它的compareAndSet方法来保证线程安全性。所以这个是一个线程安全的方法。

其实在多个线程环境中,Random根本就需要共享实例,那么该怎么处理呢?

在JDK 7 中引入了一个ThreadLocalRandom的类。ThreadLocal大家都知道就是线程的本地变量,而ThreadLocalRandom就是线程本地的Random。

我们看下怎么调用:

ThreadLocalRandom.current().nextInt();我们来为这两个类分别写一个benchMark测试:

public class RandomUsage {

public void testRandom() throws InterruptedException {

ExecutorService executorService=Executors.newFixedThreadPool(2);

Random random = new Random();

List<Callable<Integer>> callables = new ArrayList<>();

for (int i = 0; i < 1000; i++) {

callables.add(() -> {

return random.nextInt();

});

}

executorService.invokeAll(callables);

}

public static void main(String[] args) throws RunnerException {

Options opt = new OptionsBuilder()

.include(RandomUsage.class.getSimpleName())

// 预热5轮

.warmupIterations(5)

// 度量10轮

.measurementIterations(10)

.forks(1)

.build();

new Runner(opt).run();

}

}public class ThreadLocalRandomUsage {

@Benchmark

@BenchmarkMode(Mode.AverageTime)

@OutputTimeUnit(TimeUnit.MICROSECONDS)

public void testThreadLocalRandom() throws InterruptedException {

ExecutorService executorService=Executors.newFixedThreadPool(2);

List<Callable<Integer>> callables = new ArrayList<>();

for (int i = 0; i < 1000; i++) {

callables.add(() -> {

return ThreadLocalRandom.current().nextInt();

});

}

executorService.invokeAll(callables);

}

public static void main(String[] args) throws RunnerException {

Options opt = new OptionsBuilder()

.include(ThreadLocalRandomUsage.class.getSimpleName())

// 预热5轮

.warmupIterations(5)

// 度量10轮

.measurementIterations(10)

.forks(1)

.build();

new Runner(opt).run();

}

}分析运行结果,我们可以看出ThreadLocalRandom在多线程环境中会比Random要快。

FutureTask是java 5引入的一个类,从名字可以看出来FutureTask既是一个Future,又是一个Task。

我们看下FutureTask的定义:

public class FutureTask<V> implements RunnableFuture<V> {

...

}public interface RunnableFuture<V> extends Runnable, Future<V> {

/**

* Sets this Future to the result of its computation

* unless it has been cancelled.

*/

void run();